Энциклопедия поискового продвижения Ingate. Глава восьмая. Ingate энциклопедия поискового продвижения

Мой отзыв о книге "SEMbook" от агентства Ingate

Начнем. "Cембук" от Ингейт:

Что нас ждет в данной книге?

Книга обновляется - читал еще её первые выпуски. В данный момент это мощный, содержательный поток информации, как для SEO-специалиста разного уровня, так и для интернет-маркетолога. Можно сказать, основа основ - фундамент поискового продвижения. Также порекомендовал бы её всем интернет-предпринимателям, чтобы проще было бы понимать своих подрядчиков.

Что ж обратимся к её содержимому:

Содержание

Введение

Раздел I. Поисковые системы для продвижения бизнеса в интернете

Глава 1. Поисковые системы

- Поисковая система глазами посетителя и владельца сайта

- Рекламные возможности поисковых систем

- Как устроены поисковые системы

- Процессы поисковых систем

Раздел II. Работа с органическим трафиком

Глава 2. Ранжирование в деталях

- Факторы ранжирования

- «Матрикснет»

- Классификация запросов

- Ранжирование с учетом географии

- Ранжирование по коммерческим запросам

- Персонализированная выдача

- Полезно знать

Глава 3. Ограничения для продвижения

- Фильтры поисковой системы Яндекс

- Фильтры поисковой системы Google

- Бан сайта

- Влияние хостинга на продвижение сайта

- Влияние доменного имени на продвижение сайта

- Система управления контентом

- Возраст сайта

- Малый объем проиндексированных страниц

- Неуникальность сайта

- Региональность сайта

- Несоответствие запросов тематике сайта

- Большое количество запросов для продвижения

- Большое количество ВЧ-запросов

- Неглавное зеркало

- Неработоспособность и вирусы

- Неинформативная главная страница

- Flash, frame и parallax

- Дорвеи

- Домен и поддомен одной тематики

- Сайт содержит материалы, запрещенные к рекламе

- Проверь свой сайт

Глава 4. Оптимизация сайта в деталях

- Этапы работ по продвижению

- Сроки продвижения

- Этапы оптимизации

- Дополнительные этапы оптимизации

- Нюансы, вызывающие проблемы

- Устранение запрещенных элементов на сайте

- Обзор рекомендаций для сайтов от Яндекса и Google

- Работа со ссылками в деталях

- Что такое ссылка и ее вес

- Внутренняя перелинковка

- Внешние ссылки

- Правила работы со ссылочной массой

Раздел III. Работа с платными источниками трафика

Глава 5. Контекстная реклама

- Сервисы контекстной рекламы

- Создание и ведение рекламной кампании

- Использование рекламных сетей Яндекса и Google

- Ремаркетинг и ретаргетинг

Глава 6. Медийная реклама и маркетплейсы

- Медийная реклама

- Размещение медийной рекламы

- Маркетплейсы (Яндекс.Маркет, Google Покупки)

Раздел IV. Веб-аналитика

Глава 7. Оценка эффективности рекламной кампании

- Анализ привлекательности рекламной кампании

- Максимизация органического трафика

- Оценка корректности настроек инструментов статистики

- Анализ приводимого трафика

Глава 8. Аудит сайта

- Анализ юзабилити

- Конкурентный анализ и рекомендации

Словарь терминов

Полезные ссылки

Приложение 1. Основные правила юзабилити

Приложение 2. SEO-инструментарий

Скачать книгу можно по ссылке

Подробнее на их официальном сайте

Выводы & отзыв

Ранее читал первую часть данной книги и многое уже позабылось...

В книге хоть и охвачены все основные направления, но некоторые расписаны поверхностно. Понятно, что смысла расписывать как это делать, тонкости настроек и моментов технической оптимизации, и остальные фишки палить никто не будет... Но лучше прочитать одну такую книжку (объемом 541 страницу), чем собирать по крупицам на различных форумах, блогах, и профильных новостных порталах. Хотя все последние перечисленные также имеют свои преимущества.

В книге узнал много из таких направлений как PPC, покупка ссылок - т.к. работаю с сайтами без бюджета на ссылочное продвижение, было полезно узнать про новые сервисы и текущее положение работы с биржами ссылок. Очень много написано про аналитику - аж перевернуло сознание и взгляды на данное направление после прочтения данных глав в книге.

Хочу сказать большое спасибо компании Ingate за эти прекрасные материалы! Отдельное спасибо автору - Наталье Нееловой!

Жду от Вас новых книг! :)) Давно их читаю.

Надо перечитать/прочитать и по другим направлениям.

Автор статьи: Алексей СолтыкКонтакты: ВКонтакте, Моя страничка в Инстаграм, [email protected]

Просмотров: 328 (Ранг: 1.665 ?)

Спасибо за прочтение! Если понравилась статья, поделитесь:

soltyk.ru

Энциклопедия поискового продвижения Ingate. Глава восьмая » Мистерия онлайна

Скажите, вы любите, когда что-то дают бесплатно? Уверен, что да. Вот и я тоже. Но в интернете все немного по-другому. Те, кто более или менее в чем-то разбирается, со временем выпускают какие-нибудь кейсы, которые заворачивают в красивую обертку и продают за приличные бабки. Мне приходилось покупать инфопродукты, но когда я начинал изучать приобретённый материал, понимал, что, по сути, данную информацию можно было найти и в бесплатном доступе.

Просто нужно уметь искать. Есть и еще один вариант – когда продают действительно полезную, уникальную информацию, но, как правило, но, как правило, стоит она больших бабок.

Я все это говорю к тому, что если хочешь чему-то научиться, то вовсе не обязательно платить деньги. Можно освоить SEO и самостоятельно, но придется потратить время. Как раз для таких желающих предназначен проект от Ingate под названием Sembook.

В целом я склонен считать, что каждый должен заниматься своим делом. То есть, если ты – инженер, то проектируй, если ты спортсмен – то бегай. Ну, условно говоря, так. Поэтому когда возникает необходимость продвинуть свой сайт, а ты в этом ничего не понимаешь, то есть два варианта:

1. Заплатить сеошнику и не париться.

2. Разобраться и продвигать сайт самому.

Есть еще и третий вариант – разобраться самому, но отдать проект на продвижение сеошнику. Мне кажется, что подобный подход наиболее эффективен, если нет свободного времени, но есть свободные деньги.

SEO – это не такая сложная штука. Продвигать сайты интересно. И не так сложно, как может показаться. Куда сложнее разобраться в программировании, на мой взгляд. Поэтому, если вы – новичок в SEO, если у вас есть необходимость продвигать свои сайты, если вы хотите получить знания в этом области, то обратите внимание на проект Sembook.

Конечно, у Ingate свои цели, раз они предоставляют такую информацию бесплатно. Разумеется, есть какие-то маркетинговые соображения в фундаменте идеи этого проекта, но все-таки с точки зрения пользователя подобный проект – это хорошо. Особенно для новичков.

И вот недавно появилась очередная глава книги под названием «Инструментарий для продвижения».

Содержание главы:

Разумеется, я подробно изучил данную главу. Должен сказать, что тренд развития данного проекта устойчиво ориентирован на новичков и людей среднего уровня знаний в SEO, потому что все описывается просто и понятно. В данной главе доступно описаны процедуры регистрации Метрики и Analytics, использование вебвизора и т.д. Главу нахожу очень полезной, поэтому сегодняшний пост, поэтому сегодняшний пост – это наметка для вас, уважаемые читатели. У меня на сегодня все! До связи!

Вконтакте

Google+

Понравилась запись? Подпишитесь на обновления по почте:

Читайте похожие статьи

max1net.com

Работа со ссылочной массой.

Ссылочная масса — все действующие ссылки, которые направляют пользователя на продвигаемый сайт. Объем и качество ссылочной массы являются важнейшими факторами, от которых зависит ранжирование сайта.

Ссылки бывают двух типов: внутренние и внешние.

Внешние ссылки – это ссылки с внешних ресурсов, которые ведут на продвигаемый сайт.

Внутренние ссылки – ссылки, ведущие с одной страницы продвигаемого сайта на другую страницу этого же сайта.

Работа с внутренними ссылками

«Соединение» страниц сайта внутренними ссылками называется перелинковкой. Правильная перелинковка – один из инструментов внутренней оптимизации сайта. Перелинковка:

- Помогает поисковым роботам в поиске и индексировании страниц за счет видимости ссылок на эти страницы.

- Улучшает поведенческие характеристики сайта, поскольку грамотно расставленные внутренние ссылки упрощают пользователю работу с сайтом.

- Увеличивает внутренний вес продвигаемых страниц. Иногда это влияет на результат продвижения не хуже внешних ссылок. Например, низкочастотные низкоконкурентные запросы могут занять высокие позиции, имея «за спиной» лишь контент и перелинковку.

Советы по внутренней перелинковке:

- не повторяйте одни и те же тексты в анкорах, делайте их разнообразными. Например: «пластиковые окна в Москве» или «пластиковых окон в Москве», или «пластиковыми окнами в Москве». Это придаст ссылкам еще больше естественности, что важно для продвижения сайта в Яндексе.

- используйте “хлебные крошки” при сложном меню или навигации. Это улучшает юзабилити и повышает ссылочный вес. Например, как на сайте ozon.ru:

- Вставляйте ключевые слова в тексты ссылок при перелинковке. Например, если в тексте упоминаются продвигаемые ключевые слова, с них желательно поставить активную ссылку, которая будет вести на целевую страницу.

Работа с внешними ссылками

Внешние ссылки важны для продвижения, так как участвуют в двух факторах ранжирования:

- статическом, когда вес по ссылке перетекает на продвигаемый сайт, что трактуется как вероятность попадания посетителя на сайт;

- динамическом, когда вес передается определенному словосочетанию, которое употребляется в ссылке.

Существует много способов получения ссылок: от обмена до покупки на сайтах напрямую или через различные ссылочные биржи. Проставляя ссылки, учитывайте, что поисковые системы по-разному оценивают их вес. Одни, расположенные на авторитетных ресурсах, поисковики ценят высоко. Такие ссылки помогают сайту повысить свои позиции. Ссылки, размещенные на так называемых линкопомойках, поисковыми системами не учитываются и даже могут принести вред: продвигаемый по ним сайт попадет под фильтр. Поэтому очень важно, чтобы ссылки были проставлены на качественных площадках.

Выбирая место на сторонних сайтах для размещения ссылок на свой сайт, обращайте внимание на различные параметры: показатели тИЦ и PR, тематику сайта, уровень вложенности страниц, возраст домена и т.д. Эти показатели являются индикаторами качества площадки.

Наиболее удобный инструмент для подбора качественных площадок – это сервис Rookee: здесь самая большая база ссылочных бирж рунета, 4 уровня фильтров (white-list) для отбора площадок при продвижении в Яндексе и еще 1 фильтр при продвижении в Google. Десятки настроек для покупки и снятия ссылок помогут эффективно продвигать сайты даже новичкам.

Учтите, что установленные ссылки надо время от времени проверять. Подробности о технической, текстовой и ссылочной оптимизации мы расскажем в следующих главах.

Вернуться назад: Оптимизация сайта Читать далее: Повышение конверсии сайта

www.sembook.ru

Процесс ранжирования | Энциклопедия поискового продвижения Ingate

Ранжирование – процесс сортировки страниц в порядке убывания их значимости для пользователя (релевантности). Со времен основания поисковых систем алгоритмы ранжирования существенно усложнились, качество поиска выросло. Так, поисковая система Яндекс с ноября 2009 года использует метод машинного обучения «Матрикснет», запущенный в новом алгоритме под названием «Снежинск». Он позволяет строить и применять сложную формулу ранжирования, в которой используются тысячи факторов и их комбинации.

Условно процесс ранжирования можно разделить на два этапа:

1. Выбор наиболее релевантной страницы каждого сайта.

2. Вычисление значения релевантности для каждой страницы.

Поскольку на одном сайте может быть несколько страниц, дающих ответ на запрос пользователя, из них выбирается одна, наиболее релевантная. Чтобы предоставить наибольшее количество сайтов, в поисковой выдаче для одного сайта показывается, как правило, только одна страница. В некоторых случаях может показываться несколько страниц с одного сайта.

Показатель релевантности определяется посредством применения сложных многоступенчатых формул, где учитываются различные факторы и их комбинации. Одним из главных факторов оценки релевантности считается степень соответствия содержимого страницы введенному запросу. В Яндексе к этому фактору практически всегда добавляется региональная принадлежность сайта.

Страницы, которые были отобраны при первой фильтрации, участвуют в дальнейшем, более строгом, отборе. Чем выше значение релевантности, тем больше факторов участвует в процессе ранжирования страницы и тем точнее она оценивается. Причем для самых релевантных страниц значение тех или иных факторов может быть различным.

При вычислении релевантности поисковыми системами используется несколько основных групп факторов:

- Факторы страницы, или статические факторы. Связаны непосредственно с самой страницей. Например, количество ссылок на данную страницу, возраст страницы и домена, технические параметры, поведенческие показатели сайта и страницы.

- Факторы запроса. Это уточняющие признаки запроса, влияющие на сортировку страниц по типу запроса – геозависимый, коммерческий, навигационный, транзакционный и т.д.

- Динамические факторы. Они одновременно связаны и с запросом, и со страницей — например, присутствие в тексте слов запроса, их количество и расположение, количество ссылок с анкором, равным ключевому слову, количество общей информации на сайте по данному запросу.

Кроме положительных факторов ранжирования, увеличивающих релевантность страницы и сайта, поисковыми системами могут применяться санкции в виде пессимизации, т.е. намеренное занижение позиций в выдаче. Это так называемые фильтры, которые из-за грубых нарушений могут быть наложены на отдельную страницу, на пару «запрос – страница», а также на сайт в целом.

После вычисления значения релевантности страницы сортируются относительно друг друга. Чем больше значение релевантности для страницы, тем выше она окажется в результатах поиска.

Вернуться назад: Поиск релевантной информации Читать далее: Смысл апдейтов, смен алгоритмов и сбоев

www.sembook.ru

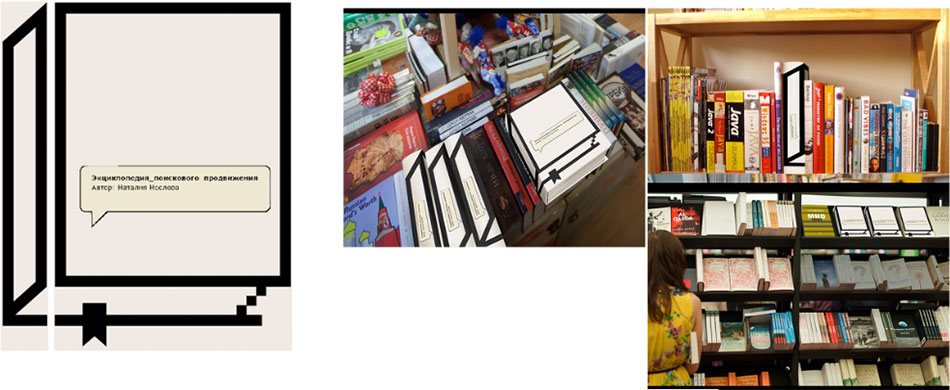

Создание оформления книги Наталии Нееловой «Сембук. Энциклопедия поискового продвижения „Ингейт“»

Начинаем думать над идеей. Это настольная книга сеошника либо человека, который совсем не разбирается в СЕО и решил получить все необходимые знания сразу. Главная тема — продвижение. Все, что нужно для того, чтобы сайт был в первых строках поиска.

Можно изобразить крутого качка в татушках, большую энциклопедию из пикселей, систему подъема курсора и силача.

Арт-директор: Давай немного поприличнее доработаем.

Клиенту не нравится. Он присылает примеры обложек, которые ему по душе, и говорит, что нужна лаконичность.

Еще подход. Обложка в виде иконки книги со всплывающими подсказками. Прикидываем, как книга будет смотреться на полках.

Опять не то. Продолжаем поиск идей: человек с факелом в дремучем лесу, охотничья собака, натасканная на новых пользователей, рыбак и книга притч.

Все равно не нравится. Нужно посерьезнее, чтобы ощущалась весомость и солидность. Делаем черную энциклопедию с гербом сеошников и стреляющий курсор.

Клиент выбирает энциклопецию и присылает список того, что должно быть в гербе: лого поисковиков, изображения панды и пингвина (это названия алгоритмов гугла и яндекса), тИЦ и PR , ссылка, топ-10, лупа, курсор, поисковый паук, ошибка 404, <titlе>.

Рисуем эскиз.

Теперь ок. Отрисовываем подробно.

Арт-директор: Надо элементы в гербе сделать в единой стилистике. И можно побогаче.

Рисуем, сканируем, делаем богато.

Подбираем шрифт. Предлагаем Бингли. Но клиент хочет что-то с более массивными засечками. Сходимся на Вальбауме.

В последний момент решаем, как набрать: SEMBOOK, SEMbook, Sembook, Сембук или СЕМБУК.

www.artlebedev.ru

Ingate - Энциклопедия поискового продвижения (2013)

Ingate - Энциклопедия поискового продвижения (2013)«Энциклопедия поискового продвижения» – уникальный проект. Не следует бояться слова «энциклопедия» – наша книга, безусловно, подробнее других, однако мы ее пишем доступным, живым языком, чтобы вы при желании могли раскрутить свой сайт самостоятельно.Для кого эта книга?Для тех, кому будет интересно узнать о том, как получать заинтересованных посетителей на свои сайты. Владельцам бизнесов, интернет-проектов, интернет-маркетологам, PR-менеджерам, начинающим SEO-специалистам.

Почему мы хотим помочь вам научиться?Мы, Ingate, уже 13 лет осуществляем продвижение сайтов и имеем большой, уникальный опыт – за время существования мы смогли продвинуть более 3500 сайтов. Нашим сервисом автоматической раскрутки сайтов Rookee пользуется почти 200 тысяч человек по всему СНГ.

Книга – это наш способ поделиться своими знаниями. Наша энциклопедия поможет вам разобраться в предмете и подскажет, как избежать ошибок в продвижении Вашего сайта.

Что я буду знать, прочитав книгу?Вы будете понимать, как работают поисковые системы, по каким принципам в поиск попадают сайты, как распределяются места в поисковой выдаче, какие помехи на вашем сайте могут помешать поисковым роботам найти информацию, на какие этапы делится процесс продвижения сайта, как повысить конверсию посетителей сайта в покупателей и какими инструментами нужно пользоваться для получения максимального эффекта.

Смогу ли я продвигать сайты самостоятельно, прочитав книгу?Раскрутка сайта своими руками – это довольно трудоемкий процесс. Цель энциклопедии - помочь вам разобраться в принципах продвижения и уберечь от распространенных ошибок.

Кто авторы книги?Над книгой работает большой коллектив авторов, более 20 человек – одни из лучших специалистов на рынке поискового продвижения. Благодаря им Вы сможете подробно изучить процесс, который называется раскрутка сайтов. Возглавляет коллектив Наталия Неелова – признанный эксперт, в 2011 году защитившая диссертацию по теме нечетких дублей и методов определения авторского контента.

Продажник:

Спойлерhttp://www.sembook.ru/

Скачать:

Нажмите, чтобы раскрыть...

infoclub.pro

листалки, версии для печати и другое; Как защитить контент.

Многие перечисленные выше доработки направлены на то, чтобы на сайте не создавались лишние страницы, точные копии существующего контента. Опасность наличия таких страниц описана в третьей главе. Они могут повлечь за собой как некорректный выбор релевантной страницы, так и наложение санкций на сайт.

Существуют два вида дублей – полные и нечеткие.

Полные дубли – это страницы, содержание которых идентично друг другу, различны только их URL.

Нечеткие дубли – это страницы, которые содержат очень большое количество одинаковой информации, но они не полностью идентичны; их URL также различны.

Источники дублей в сети различны. В одних случаях дубли появляются из-за технических недоработок web-мастеров, в других – в результате осознанного влияния оптимизатора на ответ поисковой машины.

За технические ошибки и форматы документов отвечают непосредственно владелец и разработчик сайта. Дубли текста же могут появляться, в том числе, в результате кражи контента с сайта-первоисточника. Однако борьба оптимизаторов с «нахлебниками» не имеет отношения к технической оптимизации, поэтому далее речь пойдет о недоработках на сайте, автоматически генерирующих дублированные страницы.

Чаще всего проблема решается устранением всех дублей, адреса которых будут отдавать и посетителям, и поисковой системе 404 ошибку, при этом необходимо позаботиться об устранении еще и всех образовавшихся битых ссылок.

Большинство рекомендаций по работе с дублями можно свести к следующему:

1. Закрыть от индексации в файле robots.txt все имеющиеся на сайте дубли.

2. При формировании страниц, которые являются дублями, в их мета-теги прописывать <meta name="robots" content="noindex,nofollow"/>. Это запретит роботу индексировать данные страницы и переходить по ссылкам с этих страниц.

Внутри сайта дубли страниц могут создаваться по разным причинам. Например, дубли могут возникнуть из-за повторения контента в анонсе и на самой странице новости. Другой случай – когда «версия для печати» полностью дублирует основную страницу и т.д.3. Использовать тег <link rel="canonical" href="адрес оригинала" /> на всех автоматически генерируемых страницах.

Однако каждый частный случай появления дублей страниц на сайте нужно рассматривать отдельно и применять те меры, которое будут приемлемы для этого конкретного сайта. Ниже приведены самые распространенные причины автоматической генерации дублей страниц на сайте и варианты их устранения.

«Листалки»

Если на сайте присутствует многостраничный каталог, то очень часто вторая, третья и другие его страницы могут содержать много повторяющейся информации. Это могут быть одинаковые мета-теги или текстовые блоки, которые отображаются на всех страницах каталога из-за особенностей CMS сайта. Получается, что на множестве страниц присутствует один и тот же текст, что особенно плохо, если этот текст оптимизирован для продвижения – он просто «растворяется» в множестве дублей.

Чтобы не допускать дублирования контента в «листалках», можно воспользоваться следующими методами:

1. Закрыть все дублирующиеся страницы через robots.txt, мета-тег “ROBOTS” или использовать тег «rel=”canonical”».

2. Сделать так, чтобы все значимые текстовые блоки отображались только на первой странице и не дублировались на остальных. Это целесообразно, если в продвижении находится только первая страница и на ней остается весь контент, релевантный запросу. Эти работы выполняют разработчики, а вы должны указать им необходимость их выполнения.

Помимо дублей контента на страницах «листалок» также очень часто встречается проблема одинаковых мета-тегов на всех страницах каталога. В этом нет большого вреда, но их уникализация может дать дополнительные бонусы при ранжировании ресурса. Наиболее удобный вариант работы с мета-тегами – создать единый шаблон title и мета-тегов в зависимости от содержания страницы.

Нередко встречается, что «листалка» содержит развернутое описание товара, и точно такой же текст фигурирует на странице с карточкой товара. За счет этого происходит дублирование контента, что может негативно сказаться на ранжировании. У поискового робота возникает диссонанс: какую страницу считать более релевантной?

Чтобы предотвратить такое дублирование, можно:

1. Закрыть страницы «листалки» в robots.txt.

2. Публиковать в «листалках» только небольшую часть из описания товара или услуги со ссылкой на полную версию описания или на карточку товара.Сортировка, фильтрация и поиск

В случае если на сайте располагаются формы сортировки, фильтрации и поиска, то, как правило, результат формируется на отдельной странице с динамическим URL. Эта страница может содержать фрагменты текстов с других страниц сайта. Если не проводить работу с множественными страницами результатов сортировки (или поиска), то они будут открыты для индексации роботами поисковых систем.

В сортировке участвует несколько категорий, фильтрация идет в разных сочетаниях, поиск двух разных слов может привести к одному результату – все это порождает очень много автоматически сгенерированных страниц. А это нарушает лицензию поисковых систем, в частности, Яндекса.

Самый простой способ бороться с такими дублями — закрывать страницы результатов от индексации в robots.txt.

Например, строчка, закрывающая результаты поиска, может принять следующий вид: Disallow: /search=*

Рекомендуется периодически анализировать URL страниц сайта, попадающих в индекс, чтобы вовремя устранять проблемы с сортировкой, фильтрацией и поиском. В качестве алгоритма анализа можем предложить следующее решение:

1. Проанализировать параметры, найденные инструментом GoogleWebmaster и указанные в разделе «Конфигурация – Параметры URL».

Как часто проверять сайт на дубли страниц? Это зависит от объема контента, периодичности обновлений, наличия поиска. В среднем такую проверку рекомендуется устраивать раз в месяц.2. Отобрать параметры, которые являются «незначащими», и задать в Google Webmaster команду «пропускать при индексации». Для настройки сайта под Яндекс следует указать данные параметры в robots.txt как маски для закрытия от индексации.

3. Проанализировать адреса страниц в индексе с помощью Яндекс.Вебмастер (раздел «Индексирование сайта -> Страницы в поиске»). Выявить одинаковые мета-теги (аналогичный инструмент есть и в Google Webmaster), одинаковые адреса с переставленными параметрами (например, первый «/?pr=gr&cost=big» и второй «/?cost=big&pr=gr»), количество страниц одной статьи за счет комментариев. Как только выявлены дубли, необходимо дать задание разработчику, чтобы он закрыл их от индексации.

4. Установить и устранить причину дублей, используя один из перечисленных ранее способов или их комбинацию. В идеале следует пересмотреть структуру сайта и алгоритм формирования URL.

Сортировка, фильтрация и поиск являются важными навигационными элементами сайта; без них нельзя обойтись, особенно на большом сайте, т.к. это серьезно влияет на юзабилити. Но при использовании данных элементов нужно предвидеть возможные проблемы дублирования, периодически проводить проверки и своевременно устранять выявленные недочеты.

Версия для печати

Страница «Версия для печати» имеет большое значение для удобства использования сайта, поэтому ссылки на такие страницы рекомендуется ставить на всех карточках товаров, на странице контактов и в других значимых разделах сайта. Однако страница с версией для печати отличается от основной страницы только отсутствием графической составляющей, т.е. весь контент, как правило, дублируется.

Фактически проблема нечетких дублей в данном случае решается аналогично проблеме полных дублей. Можно воспользоваться атрибутом rel=canonical, мета-тегом «robots» или прописать запрет на индексацию дубля в файле robots.txt. Однако в последнем случае ссылка с оригинала будет передавать вес на страницу печати, что приведет к потере веса продвигаемой страницей. Чтобы этого избежать, ссылку «версия для печати» на странице-оригинале необходимо дополнительно закрыть тегом nofollow. В этом случае робот не будет пытаться переходить по данной ссылке и ошибок сканирования не возникнет.

Также можно создать версию страницы для печати через технологии JavaScript и CSS. Это позволит избежать проблемы с дублями и оптимизирует взаимодействие сайта со сканирующим роботом. Однако к этой работе потребуется привлечь веб-разработчика.

CMS и неосознанные дубли

Некоторые системы управления сайта (CMS) автоматически создают несколько дублей каждой страницы. Например, в WordPress дубли возникают из-за повторения контента в анонсах и на самих страницах. Другая популярная CMS – Joomla – также создает множество дублей из-за того, что одна и та же страница может быть получена множеством различных способов.

Самая распространенная ошибка – передача лишних параметров. Этим грешат более 90% движков. Например, исходная страница site.ru/index.php?id=602, и только она должна индексироваться. Из-за идентификатора сессий и особенностей формирования динамических страниц появляются дубли: site.ru/index.php? showid=602&fs=12&345?SessionID=98765432156789.

Другой случай – наличие главной страницы по разным адресам, например, http://site.ru/ и http://site.ru/index.php.

Часть дублей обычно закрывается от индексации средствами самой CMS, но оставшуюся часть придется дополнительно закрывать методами, описанными выше: настраивать robots.txt (директива сlean-param и/или запрет индексации дублей), работать с битыми ссылками, настраивать 301 редиректы.

Бывает, что проблемы с дублями начинаются при переносе сайта с одной CMS на другую. В этом случае старые параметры накладываются на страницы нового движка, что может вызвать образование большого количества дублей. Поэтому при переносе сайта первое время необходимо контролировать техническую сторону вопроса более тщательно.

Внутренние и внешние дубли

Дубли могут быть созданы не только автоматически, но и вручную вполне осознанно. Например, на сайте есть две страницы. Первая – главная, вторая — страница «О компании», которая совпадает с главной (в свое время некогда было написать текст на эту страницу).

Подобная ситуация может встретиться и с каталогом однотипной продукции. Самый верный способ — сделать все страницы на сайте уникальными, но если это невозможно, необходимо прибегнуть к ранее перечисленным советам.

За внутренние дубли санкции на сайт не накладываются, но могут возникнуть сложности в передаче веса. Если же у сайта есть внешние дубли (кто-то украл контент и разместил его на своем домене), то возможна пессимизация сайта со стороны поисковых систем.

К сожалению, бывают случаи, когда уникальную информацию с сайта растаскивают по сети, и сайт из-за этого не может занять высокие позиции.

Яндекс очень серьезно относится к использованию на сайте неуникальных текстов (раздел «Яндекс.Помощь», подраздел «Советы вебмастеру»):

«Мы стараемся не индексировать или не ранжировать высоко: сайты, копирующие или переписывающие информацию с других ресурсов и не создающие оригинального контента…».

Один из способов запретить копировать текст с вашего сайта – заменить тег body на страницах сайта на тег body onco py=«return false». Другой способ – использовать специальный java-скрипт, который запретит использование правой кнопки мыши на web-странице, затрудняя копирование текста и изображений. Однако через исходный код страницы произвести копирование текста будет возможно, но при этом сохранятся все ссылки.Такая позиция оправдывается главным принципом поисковых систем – информация в выдаче должна быть релевантной, актуальной и качественной. Неуникальный контент нельзя назвать качественным, для поисковых систем это ведет к увеличению индексных баз и повышенной нагрузке на поисковые сервера.

Как защитить контент

Поисковым системам сложно установить первоисточник, но соответствующие исследования ведутся. Например, Яндекс предложил веб-мастерам защитить контент с помощью сообщения о размещенном на сайте материале через сервис «Оригинальные тексты» в панели Яндекс.Вебмастер. Таким образом, при краже контента Яндекс будет знать, кто правонарушитель, и сайт не будет понижен в выдаче.

Есть еще один вариант появления дублированного контента на сайте – когда вы сами как владелец сайта позаимствовали его на других ресурсах. Такие действия уменьшают доверие поисковых систем к сайту и приводят к сложностям в продвижении. Среди сайтов, участвующих в отборе в ТОП-10, даже малейший недочет может сыграть не в пользу вашего сайта. Первая десятка должна быть разнообразной и отвечающей полностью на запрос пользователя, поэтому сайтов с двумя одинаковыми текстами в ней быть не может. Уникальность контента – это одно из главных требований, предъявляемых к сайту. Уважайте авторские права других людей!

Вернуться назад: Внутренние корректировки страниц сайта Читать далее: Оптимизация текста

www.sembook.ru