Аудит SEO продвижения сайта: что влияет на его индексацию. Влияние sitemap на продвижение

зачем нужен sitemap, как создать файл sitemap xml

Есть проблемы с ранжированием, проект не растет, хотите проверить работу своих специалистов по продвижению? Закажите профессиональный аудит в Семантике

Узнай первым о новых статьях в нашем блоге

Карта сайта Sitemap XML

Карта сайта (Sitemap) – это специальный файл в формате .xml, хранящийся в корневой директории сервера. Владельцы сайтов нередко интересуются – зачем нужен Sitemap и влияет ли наличие/отсутствие этого документа на поисковое продвижение? Чтобы ответить на эти вопросы, рассмотрим назначение и структуру карты сайта.

Итак, зачем нужен xml Sitemap, что он собой представляет? Карта сайта – это своеобразный каталог, состоящий из перечня ссылок, ведущих на все разделы и страницы сайта. Файл Sitemap помогает поисковым системам более быстро и качественно индексировать интернет проект. Это особенно важно в том случае, если объем web-ресурса исчисляется тысячами или десятками тысяч страниц.

Это важно! В карту сайта следует включать только те страницы, которые должны быть в поисковом индексе. Документы с запрещенной к индексированию или служебной информацией не следует вносить в Sitemap. В карту сайта также не включают страницы с тегами и динамические URL-адреса.

Влияет ли Sitemap на продвижение?

Поисковики не будут пессимизировать интернет проект за отсутствие этого файла. Теоретически, робот должен самостоятельно просканировать все страницы сайта и включить их в поиск. Однако нужно учитывать, что система может дать сбой и не найти некоторые web-документы. Обычно «проблемными местами» становятся разделы, в которые можно попасть только по длинной цепочке ссылок, и динамически создаваемые URLы.

С точки зрения SEO, Sitemap имеет определенное влияние, поскольку карта сайта значительно ускоряет индексацию. К тому же повышается вероятность, что web-страницы попадут в индекс до того, как недобросовестные конкуренты успеют скопировать и опубликовать контент. Поисковые системы отдают предпочтение первоисточнику, тогда как копипаст подвергается пессимизации.

Как создать сайт мап

Проще всего воспользоваться одним из специализированных сервисов. К примеру, online-генератор http://www.mysitemapgenerator.com/ позволяет бесплатно сделать карту сайта, размером до 500 страниц. Предусмотрена возможность платной генерации Sitemap без каких либо ограничений. Вебмастеру потребуется всего лишь указать адрес своего сайта, а затем поместить полученный файл в корневой папке сервера.

Можно воспользоваться программой SiteMap Generator. В поле http:// следует завести адрес стартовой страницы сайта, кликнуть по клавише «start» и подождать, пока будет сформирована карта сайта. Затем нужно перейти на вкладку «Google Sitemap/XML», скопировать полученный код и вставить его в файл формата .xml.

Файл sitemap xml – доступные директивы

- Параметр Lastmod указывает роботу, когда документ последний раз обновлялся.

- Тег priory указывает на приоритет документа, по отношению к другим страницам сайта.

- Параметром loc обозначают URL адрес страницы.

- Тег changefreq используется для обозначения динамичности страниц (документы с параметром «0» робот будет посещать очень редко).

Как сообщить поисковику о карте сайта

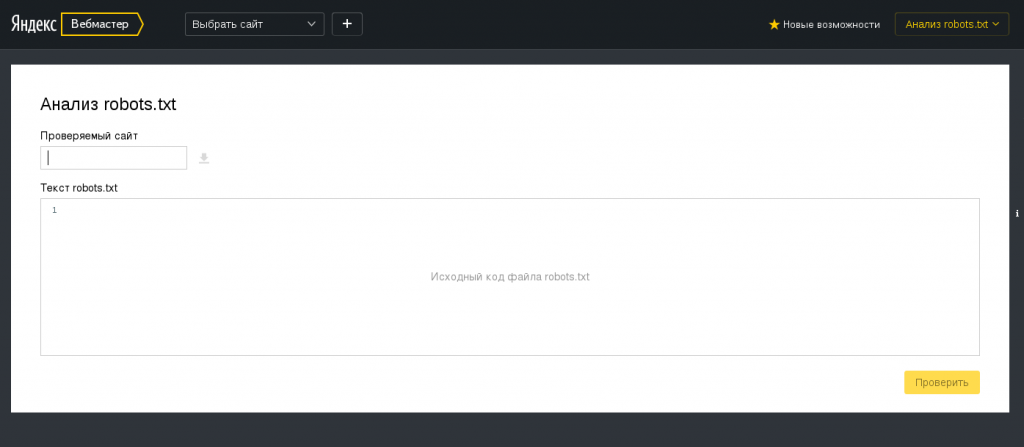

Чтобы оповестить Яндекс, можно добавить директиву sitemap в файл robots.txt. Код будет выглядеть следующим образом:

Sitemap: http://yoursite.ru/sitemap.xml

Кроме того, можно передать карту сайта через интерфейс Яндекс.Вебмастер. Для этого нужно перейти на вкладку «Настройка индексирования» >> «файлы Sitemap», а затем указать системе адрес карты сайта.

Аналогичным образом можно оповестить Google. В панели инструментов для вебмастеров нужно перейти на вкладку «Сканирование» >> «файлы Sitemap».

semantica.in

Нужен ли Вашему сайту sitemap ?

Sitemap - она же карта сайта в специальном формате для поисковых систем, с перечнем страниц сайта, которые нуждаются в индексировании. О sitemap написано в интернете очень много. Настолько много, что чуть ли не на каждом сайте сегодня встретишь этот самый sitemap. Некоторые даже вообще полагают, что сайт без sitemap - вообще не сайт. Sitemap, якобы, способствует быстрой индексации сайта, выводит страницы в топы, предотвращает кражу контента (за счет быстрой индексации), помогает ПС правильнее понимать структуру сайта, гарантирует включение страницы в индекс и т.д. и т.п. Увы, это всего лишь мифы!

Друзья. Sitemap - это прошлый век. О нем написано настолько много неправильного и противоречивого, что мне сегодня будет трудно переубедить вас в том, что сайтам сегодня не нужны sitemap.

ФАКТ 1. О необходимости использовать на сайте sitemap - нигде не сказано. Более того, вот что содержится в определении этого термина согласно Википедии (обратите внимание на слова жирным шрифтом):

Sitemaps может помочь поисковикам определить местонахождение страниц сайта, время их последнего обновления, частоту обновления и важность относительно других страниц сайта для того, чтобы поисковая машина смогла более разумно индексировать сайт. Использование протокола Sitemaps не является гарантией того, что веб-страницы будут проиндексированы поисковыми системами, это всего лишь дополнительная подсказка для сканеров, которые смогут выполнить более тщательное сканирование сайта.

Из этого определения не следует, что использование sitemap является обязательным атрибутом сайта и какой-либо интернетной панацеей. Так, sitemaps мог играть решающую роль лет 5-10 назад, когда сайты зачастую писались руками в html, без использования "хлебных крошек" и вообще, без использования "систем управления сайтом", которые сегодня автоматически поддерживают создание правильной структуры сайта (рубрики, метки, календарь и т.д.).

Указать поисковой системе на новые страницы посредством Sitemaps - еще ничего не значит, а порой таит в себе негативные последствия (о которых позднее). Сегодня ПС (эволюционирующие) не нуждаются в ваших подсказках при индексировании (вы думаете, они будут вести себя именно так, как вы это укажете в Sitemaps?), а повальное культивирование культа sitemaps (устаревшего) - скорее всего от незнания.

ФАКТ 2. Многие вебмастера замечали такой парадоксальный факт: новые страницы, которые вскармливались ПС через sitemap очень скоро теряют позиции в результатах поиска. Ответ простой: ПС не воспринимают всерьез страницы, на которых никто и нигде не ссылается (нет ни внешних, ни внутренних ссылок). Такие страницы могут влететь в индекс и тут же вылететь. Замечали такую ситуацию? Совершенно другая ситуация, когда на страницу, предлагающуюся к индексации, имеются ссылки с других страниц или сайтов! Вам также, наверное, знакома такая ситуация (быстрая индексация страницы посредством социальных лайков). Поэтому у вебмастеров, у которых перелинковка материалов не настроена должным образом - использование sitemap равносильно генерированию дорвеев.

ФАКТ 3. Sitemap содержит практически полную структуру сайта, что облегчает воровство контента, дублирование сайта, создание локальных копий. Если сайт большой (содержит много рубрик и тем), то получить, скажем, нужный перечень ссылок на нужные статьи на сайте без наличия sitemap - можно, но хлопотно. Совершенно другое дело если есть sitemap - содержащий, по сути, все пути на страницы сайта. Многие современные парсеры, нацеленные на воровство и сбор чужого контента, как правило, содержат функцию импорта материалов посредством sitemap. А многие горе-вебмастера даже и не прячут файл sitemap, порядочно размещая его в корне - http://www.example.com/sitemap.xml и даже прописывая расположение в файле robots.txt посредством директивы: Sitemap: <sitemap_location> (хотя он может располагаться где угодно и быть доступен ПС только по извещению через панели вебмастера).

ФАКТ 4. Sitemaps не ускоряет индексирование и не гарантирует включение страниц в индекс ПС. Об этом сказано везде! Так, при извещении Яндекса о наличии sitemap на сайте, он сразу предупреждает, что ему потребуется около 2-ух недель на знакомство с вашей "картой сайта". Более того, здесь же он предупреждает: "Как правило, робот обрабатывает файлы Sitemap не реже раза в две недели". И лишь только потом он принимает решение, подходит ли ему ваша страница или не подходит? На самом деле, sitemap никак не влияет на скорость и важность вашей страницы. Распространенное мнение - что sitemap ускоряет индексирование ("быстрее индексирует сайт") - всего лишь миф.

Нужно ли мне создавать файл Sitemap?

Этот вопрос есть в справочной документации Яндекса. Ответ на него гласит:

Обычно робот Яндекса узнаёт о страницах сайта, переходя по ссылкам со страницы на страницу. В большинстве случаев этого достаточно для полного индексирования сайтов. Однако, если ваш сайт содержит много динамически создаваемых страниц или страницы, для попадания на которые требуется много переходов по ссылкам, робот Яндекса может не найти некоторые из страниц сайта или неверно определить их важность. Файл Sitemap помогает решить эти проблемы.

А теперь задайтесь вопросом: нужен ли sitemap для вашего сайта? Вот-вот, конкретно, для вашего сайта он нужен? Насколько у вас сайт со сложной структурой, в которой Яндексу не разобраться своими силами? Большинство сайтов в интернете - редкообновляемые справочные ресурсы на какой-нибудь CMS (как у автора на WordPress), для которых sitemap - ни что иное как пятое колесо (несмотря на разнообразие свободнодоступных плагинов по этой теме, основная полезная работа которых - нагрузка на сервер.

Спасибо всем, кто дослушал до конца. Несогласных выслушаю в комментариях. Отсутствие у данного сайта sitemap - говорит о том, что я свято верю в то, что говорю.

Вконтакте

Google+

Загрузка...

Загрузка... seo-zona.ru

важное руководство для продвижения сайта — Semark

Содержание статьи

Как специалисту по продвижению и digital маркетингу, вероятно, Вам часто бывает необходимо, составить технические рекомендации Вашему клиенту. Чаще всего, это происходит после того, как клиент уже готов заказать seo аудит или в начале любой кампании. В результате можно получить подробную информацию о состояние ресурса, всех факторов влияющих на его ранжирование в поисковых системах, а также предоставить все необходимые рекомендации его владельцу. Фундаментом этого является — Технический SEO (поисковый) аудит сайта. Определение и формирование информации по большому числу технических факторов позволит составить план согласно всем шагам, что позволит продвинуть сайт в Яндекс и Google, а также быть более заметным в результатах выдачи и легкодоступными для посетителей.

Далее я распишу основные технические нюансы, которые считаются необходимой составляющей 2018 года, аспекты разных элементов и их влияние на функциональность.

Важность метаданных в SEO продвижение

Теги заголовков и мета описания (Meta Description) — это фрагменты HTML кода, которые являются двумя атрибутами, цель которых, информировать посетителей и поисковики о чем эта конкретная страница. Если правильно их оптимизировать, предоставленные сведения в них информация должна соответствовать запросам пользователя поисковой системы, что должно послужить увеличению количества переходов.

Чтобы сделать правильную оптимизацию, для каждого из элементов есть всего несколько рекомендаций, которые должны учитываться при проверке веб-сайта:

Теги заголовков (Title)

- Напишите релевантные основные ключи в начале заголовка

- С целью повысить внимание к бренду, добавьте название компании в конце, поддерживая общую модель для всего сайта

- Максимум для title-тега это — 50-60 символов. Чаще всего поисковики отрезают лишние символы, в результатах выдачи, если допустимая длина превышена.

- В основном, они должны быть неповторяющимися и привлекательными с целью роста их видимости и удобного пользовательского опыта.

Мета описания (Meta Description)

- 1-2 основных ключа обязаны быть добавлены и совместимы с теми, используемыми в тегах title, заголовках и в большинстве случаев ЧПУ

- Содержание обязано соответствовать основному контенту

- Наилучшая длина в символах — 150-160

- Обязаны быть уникальными

- Meta Description являются неотъемлемая частью рекламы, которая должна порождать интерес и стремление у посетителей переходить по гиперссылке

Влияние возможностей сканирования и индексация на SEO продвижение

Боты поисковиков обходят и сканируют странички веб-сайта, а далее хранят копии очищенных данных, а по каждому сайту и странице устанавливают рейтинг в учетом большого количества показателей и переменных. Сканирование (обход) страницы — это одна из многих движущих сил, которые определяют, какая адреса вернутся после обхода Яндексом или Google. Если поисковый «паук», не может сканировать ресурс или хоть одну часть должным образом, то в таком случае, конечно поисковая система, не сможет представить данную страничку посетителю, даже при идеальном соответствие контента запросам пользователя.

Боты поисковиков обходят и сканируют странички веб-сайта, а далее хранят копии очищенных данных, а по каждому сайту и странице устанавливают рейтинг в учетом большого количества показателей и переменных. Сканирование (обход) страницы — это одна из многих движущих сил, которые определяют, какая адреса вернутся после обхода Яндексом или Google. Если поисковый «паук», не может сканировать ресурс или хоть одну часть должным образом, то в таком случае, конечно поисковая система, не сможет представить данную страничку посетителю, даже при идеальном соответствие контента запросам пользователя.

Для того чтобы исключить подобные трудности, давайте посмотрим на 3 элемента, облегчающие распознавание и индексацию:

Sitemap в формате XML (XML карта сайта):

Этот документ представляет собой легко усваиваемую поисковыми системами карту сайту (меню из адресов), ориентированных на ценность информации и выбранных по Вашему усмотрению, чтобы сообщить поисковым системам и упростить процесс их обхода и индексации. Кроме того, это быстрый способ сообщить Google или Яндекс, когда были изменения на страничках или свежий контент был опубликован, в том числе какие части контента — оригиналы, что поможет улучшить их ранжирование.

Sitemap в формате HTML (HTML карта сайта):

Отличительной особенностью карты в формате HTML от формата XML, что они больше подходят для восприятия человеком, а не только поисковым системам. По этой причине, если посетитель оказался не способен найти определенную информацию, он может воспользоваться этой картой сайта. Тем самым, это плюс от поисковиков, которые считают, что она помогает улучшить пользовательский интерфейс.

Файл Robots.txt:

Данный документ располагается в корне Вашего веб-сайта и сообщает поисковым роботам о страницах, доступных для посещения и индексирования, а также о закрытых частях, которые посещать запрещено. Функциональное применение данного файла значимо не только лишь со стороны SEO, но и для скрытия и безопасности информации в определенных сегментах.

После ревизии файла robots.txt, Вам необходимо удостовериться, что адреса и правила соответствуют тому, какую информацию посетители будут видеть, при посещение сайта. К примеру, указание ‘disallow’, с которой надо быть очень осторожным, возможно применять для запрета как отдельных страниц, так и категорий или всего контента, а также к медиа-контенту, изображениям, в случае необходимости. Помимо этого, robots.txt обязан указывать поисковым роботам на карту сайта.

Конструкция URL для SEO

Конструкция URL адреса может помочь обрисовать страничку пользователям, а также поисковым системам, также, как это делает тег title. В связи с тем, в каком месте веб-сайта существует страница, маршрутизация URL-адреса обязана соответствовать навигации сайта и самой страницей (её контентом). Ниже приведены еще несколько советов:

Конструкция URL адреса может помочь обрисовать страничку пользователям, а также поисковым системам, также, как это делает тег title. В связи с тем, в каком месте веб-сайта существует страница, маршрутизация URL-адреса обязана соответствовать навигации сайта и самой страницей (её контентом). Ниже приведены еще несколько советов:

• Адреса страниц необходимо максимально сжать, отказываясь от излишнего применения подразделов, которые определяются знаком «/» в адресе• Добавить ключевики в url, лучше всего описывающие страницу, согласно и прошлому SEO также полезны• Каждое слово обязано быть разделено дефисом или нижним подчеркиванием• Необходимо удалить бесполезную пунктуацию• Остерегаться применения предлогов либо стоп-фраз• По возможности, избавиться от динамических составляющих, если это уместно

Если какие-то части сайта неверно представлены в их адресах URL, важно применить все без исключения советы, потому что, опыт Ваших посетителей может оказаться под угрозой, а следовательно и роботы могут запутаться во время фазы индексирования страниц.

Безопасный протокол HTTPS

C того момента, когда запущенная в 2014 году кампания от Google, HTTPS везде, популяризация этого лишь возросла. В 2016 году агенты Гугл сообщили, что обеспечение безопасности и защиты сайтов обязано находится во внимание веб разработчиков в ближайшие несколько лет. Данное попросту обозначает переход вашего веб-сайта с HTTP в HTTPS.

HTTP — это протокол передачи гипертекста, позволяющий передавать и принимать данные в Интернете. Данный протокол применяется на прикладном уровне, или как его еще называют, уровне приложения, что означает, передача информация не зависимости от используемого канала, который требуется.

Посредством протокола HTTPS, взаимообмен авторизацией и данными предохранен вспомогательным уровнем, знакомого всем, как SSL, используемого с целью передачи конфиденциальной информации.

Так как, Гугл стремится принудить пользоваться более надежным протоколом, они заявили, что наличие сертификата и правильно настроенный HTTPS они будут считать ранжирующим сигналом, но несмотря на всё, не слишком значительным.

Этим никак не меньше поисковые боты Гугл уже начали выделять первенствующий интерес к безопасным страницам, вместо тех, что не имеют HTTPS. Кодирование интернет-веб-сайта подтвердит его единство и достоверность. Криптографический протокол SSL подтвердит целостность и достоверность информации на сайте.

При сборе seo аудита удостоверьтесь, что данный компонент предусмотрен, или в рекомендации вы включите приобретение сертификата SSL и его настройку.

Влияние канонизация и переадресаций на SEO

Во время поискового SEO аудита, автоматизация процесса обхода по страницам сайта становится важным основополагающих шагом, помогающем двигаться вперед для проведения необходимых оценок всех факторов. Распространенной программой, используемой SEO специалистами, является — Screaming Frog. Она комплексно разбивает информацию о расширениях всех файлов, получает метаданные со страниц и http коды состояний, канонические адреса страниц и т.п. для всех страниц при обходе сайта.

Итак, давайте продолжим разбираться.

Канонизация URL

В случае, исследования поисковиком ряда страниц, в каковых по сути размещено одинаковое содержание, станет трудно установить, какая страница из двух вариантов может быть выбрана с целью предоставления в выдаче поисковых результатов в соответствие с запросами пользователей и, следовательно, может быть откажется от двух вариантов.

Ужаснее этого, в случае есть различный список источников ссылающихся на эти дубли, авторитет главной версии страницы будет размыт, а степень уверенности к этой странице будет снижен.

Удостоверьтесь, в случае, если сайт содержит ряд альтернативных страниц, все они без исключения указывают на единый адрес, который указывается с помощью rel=canonical. Некоторые случаи дублирующихся страниц перечислены далее:

- Странички с возможностью фильтрации

- С разбивкой или пагинацией по страницам

- Дубли в HTTPS и HTTP

- Дубли с www и без www

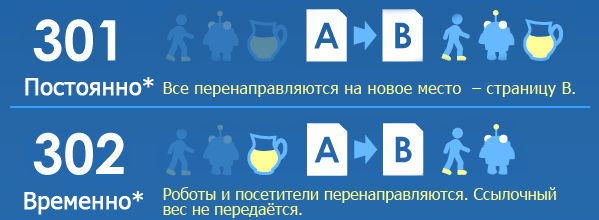

Редиректы или цепочки перенаправлений

Цепочка перенаправлений обуславливается, равно как серия перенаправлений, постоянно отправляющих один адрес на другой, вынуждая посетителей и поисковики ожидать, пока все лишние операции будут завершены до того, как они доберутся до своего предполагаемого url. Результатом этого, в таком случае считается, то что приблизительно 10% авторитета страницы пропадает у каждой переадресации.

Возможность, доступная в некоторых специализированных программах, дает возможность просто распознать всевозможные цепочки перенаправлений. В данной стадии отфильтруйте цепочки, требующие ликвидации, для того чтобы уже после обновления Вашими программистами, сайт получит удобство в опыте пользователей, лучшую индексацию и сократится время загрузки страниц сайта.

Как оптимизировать скорость загрузки сайта

Кроме первейшего представления, есть ряд элементов, способствующих эффективной скорости загрузки сайта. Различные девайсы имеют большую значимость в нашей производительности: на работе, учебе и даже дома. Cоответственно нужно, чтобы они реагировали как можно быстрее!

Кроме первейшего представления, есть ряд элементов, способствующих эффективной скорости загрузки сайта. Различные девайсы имеют большую значимость в нашей производительности: на работе, учебе и даже дома. Cоответственно нужно, чтобы они реагировали как можно быстрее!

Так как действия пользователей на прямую зависят от скорости загрузки, Яндекс и Google хотят, чтобы страницы загружались мгновенно. Они заявляют, что хорошая производительность ресурса даст Вам дополнительный плюс в ранжировании.

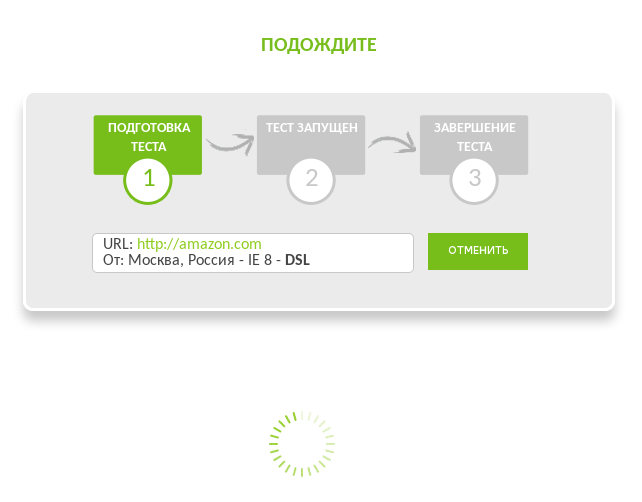

Есть много полезных программ и веб-приложений, помогающих определить скорость работы сайта. После быстрой проверки Вашего ресурса с помощью одной из них, появится возможность узнать, как поисковая система относится к скорости Вашего сайта, расставить приоритеты в областях, требующих особой чуткости, таких как снижение объемов загружаемых картинок, уменьшения их размеров, применение кеширования браузером, отсрочка загрузки JavaScript файлов и т.п.

Оценить факторы и получить рекомендации просто, поскольку в отчетах подробно рассматриваются точные файлы, которым надо уделить внимание.

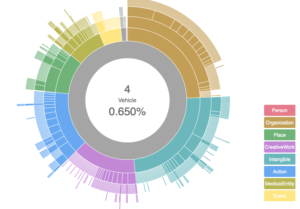

Микроразметка и Внедрение Структурированных Данных

Микроразметка — вид HTML разметки, добавляемый в определенных фрагментах HTML-кода, нужный для правильной интерпретации поисковиками полученной ими информации. Хотя гарантии на это поисковики не предоставляют, есть возможность появления богатых сниппетов в результатах выдачи, что увеличивает удобство пользователей. Как следствие увеличивается количество переходов и CTR.

Микроразметка — вид HTML разметки, добавляемый в определенных фрагментах HTML-кода, нужный для правильной интерпретации поисковиками полученной ими информации. Хотя гарантии на это поисковики не предоставляют, есть возможность появления богатых сниппетов в результатах выдачи, что увеличивает удобство пользователей. Как следствие увеличивается количество переходов и CTR.

Несколько из часто встречающихся типов микроразметок Schema:

- Organization

- LocalBusiness

- Corporation

- GovernmentOrganization

- EducationalOrganization

- Store

Подробный и полный ресурс, который предоставляет информацию об областях сайта, которые могут быть включены в разметку, можно найти здесь.

Чтобы определить правильно ли реализована микроразметка и структурированные данные, есть инструменты Google Rich Snippets Testing Tool и Валидатор микроразметки от Яндекса, являющиеся исчерпывающими ресурсами.

Теперь, когда вы укомплектованы самыми важными техническими компонентами, вы можете глубоко погрузиться в процесс аудита и продвижения сайта! Помните, что технический SEO аудит важен, из-за специальной экспертизы составленной при нем. Ни один элемент выявленный в исследование не должен быть упущен, независимо от того, насколько трудоемким, может быть процесс. После того, как Вы внедрите рекомендации или можете обратиться к нам и заказать поисковое продвижение и оптимизацию сайта со временем Вы увидите положительное влияние от проведенных изменений и результат, который они оказывают, создавая положительный опыт для Ваших пользователей, а также повышение рейтинга от поисковых систем

Cводка

Название статьи

SEO Аудит в 2018 году: важное руководство для продвижения сайта

Описание

Важное руководство по SEO аудиту и рекомендациями по продвижению сайта в 2018 году. Вы узнаете о наиболее значимых факторах, чему надо уделить внимание и как продвинуть сайт.

Автор

Oleg

Издатель

SEMark

Логотип

Рекомендованные статьи

semark.ru

Как файл robots.txt влияет на продвижение сайта

Привет 👋 Друзья! В этой стате мы поговорим о том, как файл robots.txt влияет на продвижение сайта. Итак поехали!

Как файл robots.txt влияет на продвижение сайта

Самым важным инструментом во внутреннем SEO-продвижении сайта является файл robots.txt.Многие веб-мастера недооценивают важность и значение этого файла и составляют его за несколько минут, не особо вникая в суть. И в итоге получают проблемы с индексацией сайта.

Поэтому вы должны уделить немного времени тому, чтобы разобраться, что это за файл, зачем он нужен и какие преимущества можно получить от его правильного заполнения.

Зачем нужен файл robots.txt

Самое главное, зачем составляют файл robots.txt — это более быстрая и полная индексация вашего сайта! Все дело в том, что в большинстве случаев на сайте существуют различные страницы, которые не должны попадать в индекс Яндекса и Google, но которые открыты для индексирования, и поисковым ботам ничего не остается, кроме как сканировать все эти страницы.

Вот пример подобных страниц, которые оказывают негативное влияние на индексацию всего вашего сайта в целом:

- Дубликаты страниц (например, это может быть одна и та же страница на вашем сайте, но доступная под разными url-адресами).

- Страницы с ошибкой 404 — если вы их не запретили, то поисковый бот может просканировать тысячи ненужных страниц.

- Низкокачественные и спамные страницы. Если вы знаете, что у вас на сайте есть подобные страницы, то их лучше запретить индексировать.

- Бесконечные страницы (простой пример — календарь. В нем может быть навигация по дням, неделям, месяцам, годам и т. д., и поисковый робот может просканировать тысячи ненужных страниц).

- Страницы поиска (например, если у вас есть несколько сотен материалов, то поисковые роботы могут начать индексировать все эти ненужные страницы с результатами поиска, что будет приводить к дублированию контента).

- Страницы корзины и оформления заказа. Это актуально исключительно для интернет-магазинов.

- Страницы с фильтрами, возможно даже страницы сравнения товаров — их может быть огромное количество (чем крупнее интернет-магазин, тем больше может существовать таких страниц) — от них нет никакой практической пользы, но все они по умолчанию индексируются поисковыми системами.

- Страницы с регистрацией и авторизацией. Их лучше запретить индексировать, потому что тем самым ваш сайт могут найти злоумышленники, для того чтобы попытаться его взломать.

- Версии для печати (если они существуют) содержат дублированный контент основного сайта, поэтому если у вас они есть, то их в обязательном порядке надо скрыть от индексации.

Естественно, что этот список ненужных страниц вы можете самостоятельно расширить, т. к. у вас на сайте, возможно, немного другая структура, и вы можете решить, что те или иные разделы поисковым роботам индексировать не нужно!

Файл robots.txt для wordpress

User-agent: * # общие правила для роботов, кроме Яндекса и Google, # т.к. для них правила ниже Disallow: /cgi-bin # папка на хостинге Disallow: /? # все параметры запроса на главной Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет, # правило можно удалить) Disallow: *?s= # поиск Disallow: *&s= # поиск Disallow: /search/ # поиск Disallow: /author/ # архив автора Disallow: /users/ # архив авторов Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой # ссылки на статью Disallow: */feed # все фиды Disallow: */rss # rss фид Disallow: */embed # все встраивания Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете, # правило можно удалить) Disallow: /xmlrpc.php # файл WordPress API Disallow: *utm= # ссылки с utm-метками Disallow: *openstat= # ссылки с метками openstat Allow: */uploads # открываем папку с файлами uploads User-agent: GoogleBot # правила для Google (комментарии не дублирую) Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: - для приоритета) Allow: - для приоритета) Allow: /wp-*.png # картинки в плагинах, cache папке и т.д. Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д. Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д. Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д. Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS User-agent: Yandex # правила для Яндекса (комментарии не дублирую) Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Allow: */uploads Allow: *.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать # от индексирования, а удалять параметры меток, # Google такие правила не поддерживает Clean-Param: openstat # аналогично # Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent # не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже. Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS # то пишем протокол, если нужно указать порт, указываем). Команду Host понимает # Яндекс и Mail.RU, Google не учитывает. Host: www.site.ruВажные моменты при составлении файла robots.txt

Важно помнить о том, что чем меньше мусорных страниц, тем выше скорость индексации основных (важных) страниц вашего сайта. Поэтому если вы избавитесь от всего мусора, то индексация всех новых страниц, статей, записей, карточек товаров значительно ускорится, и ваш сайт, возможно, даже поднимется в поисковой выдаче за счет попадания большего количества целевых страниц в поисковую выдачу.

Важно также в файле robots.txt прописать главное зеркало и ссылку на xml-карту сайта (sitemap), потому что это поможет многократно улучшить индексацию вашего сайта!

Естественно, что составить файл надо правильно: после того как вы составили файл robots.txt, нужно зайти в панель «Вебмастера» Яндекса или «Гугла» и проверить, индексируется ли ваш сайт (все основные страницы, например главная страница, рубрики, каталог товаров, статьи и так далее). Кроме того, вы должны здесь же (в «Вебмастере») проверить, что вы запретили индексацию всех мусорных страниц.

Если же какие-то поисковые боты (например, от поиска mail.ru) нагружают ваш сервер, делают тысячи ненужных вам переходов по страницам вашего сайта, но пользователи из этих поисковых систем приходят на ваш сайт редко, то можете запретить вообще индексацию для всех поисковых роботов, кроме Yandex и Google. Но это делать нужно только в крайнем случае, например чтобы защититься от парсинга собственного сайта, или если нагрузка на хостинг достигает критических отметок.

Так как этот файл очень важен, то постарайтесь максимально подробно изучить структуру его составления, чтобы нужные вам страницы остались в выдаче поисковых систем, а не были заблокированы из-за того, что вы допустили какую-то ошибку.

Помните также, что составление robots.txt зависит также и от того, на каком движке (CMS) работает ваш сайт. Например, для блога на WordPress файл robots.txt будет значительно отличаться от того же файла для интернет-магазина на движке «1С-Битрикс».

hozyindachi.ru

в чем разница и как создать [руководство]

Карта сайта представляет собой страницу sitemap.html (для посетителей, помогает упростить навигацию и найти любую страницу на большом сайте) или файл sitemap.xml (для поисковых систем), содержащие подробный список всех страниц веб-сайта.

Сайтмап позволяет сократить количество переходов при поиске нужной страницы на любом, даже самом большом сайте. Грамотно настроенная карта сайта способна повысить индексацию страниц веб-сайта.

Какие возможности дает карта сайта?

Поисковики способны просканировать все адреса сайта самостоятельно, но создание карты сайта поможет им узнать, как это лучше сделать.

Сайтмап позволяет:

- найти новые страницы на ресурсе и проиндексировать их;

- расставить приоритетность страниц;

- отследить свежие изменения на индексируемых страницах;

- запомнить частоту обновления индексируемых страниц.

Какие бывают карты сайта?

В общем случае существует два варианта сайтмапа — это веб-страница sitemap.html и файл sitemap.xml. Рассмотрим их поподробнее.

Что такое Sitemap.html?

Это статическая HTML страница, где перечислены ссылки на все основные страницы сайта. Такой формат сайтмапа ориентирован на посетителей сайта и позволяет в 1 клик перейти на любую из страниц.

Sitemap.html имеет структуру дерева с развернутыми разделами.

Ссылка на статическую карту сайта зачастую расположена в футере.

Пример ссылки на карту сайта на Tripadvisor.ru

Пример ссылки на карту сайта на Tripadvisor.ruУ сайтов с очень сложной структурой HTML карта сайта может состоять из страниц с дополнительным уровнем вложенности.Пример — карта сайта TripAdvisor.

Пример сложной HTML карты сайта Tripadvisor — уровень 1

Пример сложной HTML карты сайта Tripadvisor — уровень 1 Пример сложной HTML карты сайта Tripadvisor — уровень 2

Пример сложной HTML карты сайта Tripadvisor — уровень 2Что такое sitemap.xml?

Это файл, лежащий в корневой директории сайта, который читается всеми существующими поисковиками. Его роль — показать поисковым системам все адреса страниц, которые нужно проиндексировать; когда они появились или обновились; с какой регулярностью перепроверять страницы на обновление.

Пример файла — http://livepage.pro/sitemap.xml

Один файл sitemap.xml может включать в себя до 50 000 ссылок. При большем количестве ссылок таких файлов будет несколько. Дополнительные преимущества — возможность указать частоту обновления страниц и приоритет индексации. Правильная кодировка файла sitemap.xml должна быть UTF-8, а его размер ограничен 10 Мб.Приведем пример карты сайта в формате.xml:

<urlset xmlns=»http://www.sitemaps.org/schemas/sitemap/0.9″> <url> <loc>http://mysite.ru/</loc> <lastmod>2017-09-18T18:54:13+04:00</lastmod> <changefreq>always</changefreq> <priority>1.0</priority> </url> <url> <loc>http://mysite.ru/category/</loc> <lastmod>2017-09-18T18:57:09+04:00</lastmod> <changefreq>hourly</changefreq> <priority>0.8</priority> </url> <url> <loc>http://mysite.ru/page/</loc> <lastmod>2017-09-18T18:59:37+04:00</lastmod> <changefreq>daily</changefreq> <priority>0.6</priority> </url> </urlset>

Как создать карту сайта?

Существует ряд методов создать sitemap для вашего ресурса:

- Статически вручную. Этот способ подойдет продвинутым пользователям, которые имеют навык работы с основными тегами, а веб-сайт состоит из небольшого количества страниц.

- Через генератор карты сайта. Если вы не хотите выполнять кропотливую и нудную работу по генерации карты сайта вручную, к вашим услугам — программа для создания карты сайта. Есть платные и бесплатные варианты: GSiteCrawler, Google Webmaster Tools Sitemap Generator, SiteMap Generator и множество других.

- Плагин для CMS или средствами движка. Еще один хороший способ сгенерировать sitemap. Масса преимуществ в виде гибкой настройки под нужные параметры и максимума возможных адресов, а также серьезная экономия времени. Кроме того, при внесении изменений на страницу или создании новых страниц карта сайта будет обновляться автоматически, в отличие от сайтмапа, созданного другим способом. Для каждой системы существует свой плагин:

- для CMS WordPress разработаны seo-плагины с функцией создания сайтмапа;

- для Joomla существует Xmap;

- DLE — имеется встроенный модуль.

Полезный нюанс!

Если исключить из карты сайта страницы, которые не несут коммерческой или информационной пользы (например, какие-нибудь страницы, не являющиеся посадочными, какие-то вспомогательные, транзитные), то поисковой робот будет тратить меньше своих ресурсов на переобход сайта.

А так как ресурс ограничен, становится больше вероятность, что робот обойдет нужные нам страницы. Создавая sitemap через плагин, можно сразу исключить оттуда определенные типы страниц. Их потом можно добавить, если понадобится. Актуально для больших сайтов.

Как часто должна обновляться карта сайта?

Единого норматива по количеству обновлений нет. Все зависит от частоты создания новых страниц ресурса, изменения адресов или контента и связей уже существующих страниц.

При этом стоит помнить, что данные, указанные в карте сайта, поисковый робот воспринимает как рекомендательные: если установить частоту обновлений, к примеру, раз в год, робот будет приходить чаще, а если раз в час — робот не станет индексировать страницу так часто.

Как правильно указать ссылку на sitemap.xml в robots.txt

Для начала, xml карта сайта должна быть создана и загружена на сервер, и потом можно добавить указание о наличии файла.

Чтобы это сделать, пропишите в robots.txt следующую строку:

Sitemap: {url-файла-sitemap},где {url-файла-sitemap} — это полный URL вашего сайтмапа.

В итоге, robots.txt приобретет такой вид:

User-Agent: *Sitemap: httр://mysite.com/sitemap.xml.

Частые ошибки в карте сайта

Самые распространенные ошибки:

- битые ссылки;

- редиректы;

- некорректные даты публикации или обновления контента.

Ошибки не будут иметь критического влияния на отношение поисковых систем к вашему сайту. Однако их устранение позволит направить высвободившиеся ресурсы поискового робота на переобход важных страниц.

Как проверить корректность карты сайта

Чтобы проверить корректность карты сайта, разработаны многочисленные онлайн-сервисы, которые сделают это за вас автоматически и укажут на все допущенные ошибки: валидности файла, указание на url с другого домена, превышение размера файла, проведут онлайн-диагностику индексации. Такие программы бесплатны и работают со всеми крупными поисковиками (Google, Yandex, Yahoo).

Для проверки корректности необходимо открыть страницу сервиса, загрузить xml-файл или ввести в поле соответствующий URL и нажать на кнопку проверки. Если программа обнаружит ошибки, она подскажет, какие адреса дают некорректный ответ.

Протестируйте sitemap.xml в Яндекс * — https://webmaster.yandex.ru/tools/sitemap/Протестируйте с помощью сервиса Pixel Plus — https://webmaster.yandex.ru/tools/sitemap/Англоязычный сервис — https://sitemapkoala.com/

* — для теста в Яндекс, необходимо добавить сайт в Яндекс Вебмастер.

Итого

Карта сайта — удобный инструмент, призванный упростить передачу структуры основных страниц как посетителю так и поисковой системе.

Без нее можно обойтись. Поисковик и так рано или поздно доберется до большинства веб-страниц, но с сайтмапом переобход или индесация новых страниц будут более эффективными.

livepage.pro

sitemap xml важный инструмент при раскрутке сайта

Для того чтобы ваш ресурс стал популярен хорошей идеи, все же, не достаточно, не достаточно красивого дизайна и качественного контента. Если ваш сайт не увидят «могучие» глаза поисковиков, то, к сожалению весь труд может пойти насмарку. Человек создающий свой проект должен, нет, обязан постичь тайны сайтостроения.

Одним и единственным пунктом этой статьи будет sitemap xml. Именно файл с этими настройками будет являться сердцем вашего сайта, при умелом использовании которого он может превратиться в ящик Пандоры.Представьте, что sitemap xml – своего рода карта с кладом, а поисковик профессиональный кладоискатель. Кладом будет являться семантическое ядро вашего сайта. Ну, а ценность его уже зависит от вашего качества работы и количества вложенного труда. SEO-шники отмечают, что большинство людей забывают об этом, тем самым обрекая свои труды на крах. Ниже мы рассмотрим этот инструмент как основополагающий элемент нынешнего сайтостроения и продвижения.

Чтобы понять ее влияние на индексацию, достаточно сказать, что если поисковый робот попадает на сайт без такой карты, он начинает индексировать все, что попадает в его поле зрение, тем самым нанося больше вреда, чем пользы для сайта. Внутри самой карты сайта xml для этих роботов существуют четкие указания, какая именно информация с контентных страниц подходит для индексации, а что трогать совсем ненужно, это существенно улучшает продвижение ваших сайтов.

При составлении карты сайта xml нужно учитывать множество нюансов и общепринятых стандартов, иначе не факт что все, что будет в общем итоге проделано, принесет исключительно 100% пользу вашему ресурсу. Для того, чтобы индексация действительно начала проходить быстрее, стоит сообщить поисковикам, о наличии на вашем сайте карты xml, и если в нее вносятся какие-то существенные изменения, информацию об этом также стоит передавать поисковикам для более быстрого перестроения поисковых роботов под новые условия заданные в этой карте. Для этого существует множество возможностей, если вы пользователь WordPress, то задача существенно упрощается, ведь в нем встроен плагин «XML Sitemap Generator»( он запрограммирован автоматически создавать карту и постоянно сообщать поисковикам о новых публикациях, для ускорения посещения сайта роботами-поисковиками, что существенно влияет на раскрутку сайта).

Sitemap.xml в панели вебмастера

Сама карта по умолчанию находится в корне сайта, роботы об этом проинформированы и сразу ищут именно там, но существует возможность еще более все упростить, для этого нужно внести ее адрес в инструменты типа Яндекс.Вебмастер или Google Webmaster Tools. Это даст уверенность в том, что робот точно ничего не пропустит и всегда будет находить вашу карту.

Существует ряд довольно больших ошибок, которые не дают этой карте делать свое дело,тормозят индксацию и мешают проводить ранжирование(сортирование контента по степени важности и т.п):

1. Ссылки на несуществующие страницы в sitemap.xml -40% ( одна из самых популярных ошибок, которая существенно влияет на скорость индексации)

2. Отсутствие файла sitemap.xml -20%( логично, что при отсутствии такого файла, все выше описанное не имеет смысла)

3. Sitemap.xml не обновляется- 12% (не критично, но лучше этого не допускать)

4. В sitemap.xml указаны некоторые страницы, которые уже запрещены в robots.txt -14% (попросту роботы не смогут оптимально считывать важную информацию)

5. Присутствуют ссылки на различные картинки в sitemap.xml 4%

6. Все страницы заданы с одинаковым приоритетом в sitemap.xml -8% (важно расставлять приоритеты по степени важности контента и т.п)

7. В sitemap.xml частота обновления страницы указана не совсем верно

8. В sitemap.xml указана неверная дата обновления страницы -4%

rabotalegko.com

Что влияет на индексацию сайта в поисковых системах

Пришла пора признать, что мы — зависимы. Мы не можем пройти мимо полезной с практической стороны статьи о SEO (и уж тем более — SEO аудите), не поделившись с теми, кому она может реально пригодиться. Поэтому сегодня речь о старом, но с новыми фактами-паролями да явками.

Пришла пора признать, что мы — зависимы. Мы не можем пройти мимо полезной с практической стороны статьи о SEO (и уж тем более — SEO аудите), не поделившись с теми, кому она может реально пригодиться. Поэтому сегодня речь о старом, но с новыми фактами-паролями да явками. Анализ доступности ресурса

Мы настаиваем на том, чтобы все начинали свой путь с оценки общей работы и функциональности сайта. Если поисковые системы или ваши посетители не получают доступ на ресурс или в какие-то его части, то это тревожный сигнал к тому, что что-то пошло не так.

Вот, что мы проверяем в первую очередь, чтобы избежать таких стоп-моментов.

Robots.txt

Любимый всеми нами файл robots.txt используется для ограничения поисковых роботов в доступе к разделам вашего сайта.

Его довольно просто можно проверить и вручную, убедившись, что ограничения стоят правильно, не запрещая доступ всем и каждому к важным разделам сайта. Помочь с проверкой robots.txt вам сможет сервис Яндекса — Вебмастер.

Для этого нужно:

-

зайти в свой аккаунт

-

пройти путь «tools» - «robotstxt»

-

ввести в открывшееся окно исходный код файла

-

получить данные проверки и внести исправления

Проверка HTTP

Это следующий шаг проверки вашей доступности. И важен он потому, что хуже некуда для посетителя или поискового робота не попасть на страницу со злосчастными ошибками диапазона 4хх и 5хх (например, знаменитая программная ошибка 404).

Поэтому в ходе первичного аудита доступности сайта важно определить и исправить все URL-адреса страниц, которые выдают данные ошибки.

Если в ходе исправления вы настроили редирект, то не забывайте вот о чём. Дважды проверьте также код состояния 301 протокола HTTP, отвечающий за перемещение URL в новые места. Адрес нового месторасположения ресурса указывается в поле Location (в заголовке получаемого пакета протокола HTTP). И если вы указали его верно (и везде, где необходимо), поисковый робот найдёт перемещённые изменённые URL без каких-либо проблем.

XML Карта сайта

XML Карта вашего сайта обеспечивает поисковым роботам логичное и быстрое передвижение по вашему ресурсу. Это важно, так как в случае заминки оценка состояния вашего сайта будет происходить значительно медленнее, и это обязательно повлияет на его ранжирование.

Вот несколько важных вопросов, на которые стоит ответить, чтобы понять, в каком состоянии сейчас карта вашего сайта:

Представлена ли она в виде хорошо сформированного XML-документа?

Следует ли она Sitemap-протоколу?

Найдёте ли вы самостоятельно, без карты сайта страницы, которые в ней по какой-то причине не отображаются?

Есть ли в вашей карте сайта страницы, не принадлежащие к конкретному дочернему разделу или подразделу?

Почему мы спросили именно об этом? Всё просто.

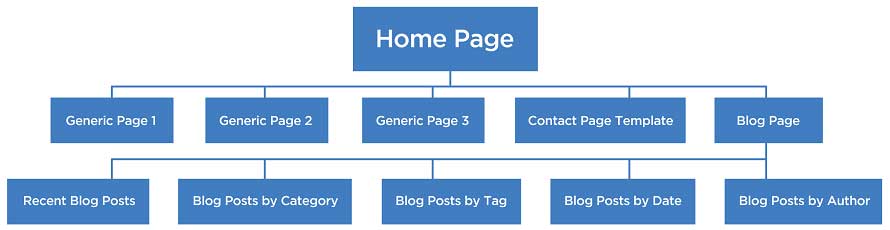

Поисковые роботы, проверяя ваш сайт и его структуру, подразумевают определённую модель карты сайта, не найдя которую, могут заблудиться и не совершить проверку надлежащим привычным и главное, полноценным, путём, осмотрев все закоулки.

Если в вашей карте есть страницы, у которых нет дочерних разделов — это осиротевшие ссылки, требующие заботы. Стоит найти для них место в архитектуре сайта и убедиться, что каждая обрела хотя бы одну внутреннюю ссылку.

Архитектура сайта

Архитектура сайта определяет его будущую структуру вдоль и поперёк: вертикальную глубину (количество уровней) и горизонтальное строение ресурса.

Главный критерий оценки качества архитектуры — подсчёт кликов, требующихся, чтобы добраться от главной страницы до остальных важных разделов.

Второй момент — это оценка иерархии сайта. Так как самые важные страницы обязательно должны иметь приоритет в архитектуре всего сайта.

В идеале нужно стремиться к более плоской архитектуре сайта, использующей одновременно вертикальные и горизонтальные элементы построения.

Но даже лучшие по структуре ресурсы могут быть негативно оценены поисковыми роботами, если их доверие подрывают навигационные элементы, блокирующие доступность сайта. Мы говорим сейчас о Flash и Jvascript.

Чтобы оценить, насколько пагубно эти навигации влияют на ваш ресурс, можно провести довольно простой тест: проанализировать сайт с включенной JavaScript и выключенной. Затем сравнить графы показателей, оценив, что при включении навигации перестаёт работать. И что влияет на производительность сайта, о которой мы поговорим ниже.

Производительность Сайта

Этот блок работ пропускать никак нельзя. Он должен финализировать проверку доступности вашего сайта, подсказав вам, какие показатели требуют улучшения.

Все пользователи ограничены в объёме внимания, которое они готовы уделить одному ресурсу. И если ваш сайт плохо подгружается, то риск потери клиентов становится максимальным. Хоть поисковые роботы не наделены человеческим понятием «терпение», они также имеют ограниченное количество времени на изучение одного ресурса в Интернете. Что значит — если ваш ресурс тормозит, это риск и посетителей потерять, и проверку от поисковых систем проходить реже.

Оценить производительность сайта можно с помощью десятков инструментов, более подробно мы писали об этом в нашем последнем материале о самостоятельном анализе сайтов. Вы можете обратиться, скажем, к ресурсу Sitespeed или его аналогам, но самое важное для вас будет после проверки - оценить ситуацию и степень её запущенности. Ну и, конечно, исправить то, о чём вам говорят показатели

Анализ индексации сайта в поисковых системах

Когда проверка доступности сайта останется позади — можете приступать к проверке индексации ресурса в поисковых системах, чтобы определить, какое количество страниц вам предстоит оптимизировать.Команда «site:»

Большинство поисковых систем используют данную команду для поиска контента на конкретном ресурсе.

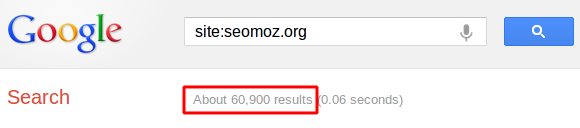

Вы можете использовать её, чтобы получить приблизительную оценку количества страниц, которые были проиндексированы в данной поисковой системе. Например, если мы ищем в Google оценку ресурсу seomoz.org, то мы видим, что поисковая машина проиндексировала примерно 60,900 страниц:

Разумеется, эта цифра приблизительная. Но даже приблизительная оценка порой бывает очень ценной. Ведь она даст вам понимание дальнейшего сценария, который может быть одним из трёх:

1. Индекс и фактические показатели примерно равнозначны — это идеальный сценарий, показывающий, что поисковики успешно индексируют все страницы вашего сайта.

2. Подсчёт индекса значительно меньше, чем фактическое количество страниц — этот сценарий свидетельствует нам о том, что поисковые системы по какой-то причине не проиндексировали целую кипу ваших страниц. В этом случае вам важно понять, опредилили ли вы проблему в ходе аудита доступности сайта — и если да, то исправлять её через полученные данные об ошибках. Если же нет — то придётся провести комплексный аудит сайта, определяя проблему и стоп-моменты в индексации. И начать с того, чтобы узнать, не попадает ли ряд страниц в бан или под наказание поисковых машин по какой-либо причине.

3. Подсчёт индекса значительно превышает фактическое число страниц — в этом случае, как правило, речь идёт о том, что ваш контент продублирован (например, одна страница доступна через несколько точек входа, либо две страницы имеют очень сходый контент).

Когда на вашем сайте появляется дублированный контент, поисковые роботы пытаются определить, какая из страниц является первоначальным источником, а какая — её дублем. И, увы, не может сделать это со 100% точностью, поэтому зачастую в поисковую выдачу попадает не та страница, которая потенциально важна для вас. К тому же, если на вашем сайте будет слишком много дублей, то поисковый робот может вскоре вообще прекратить посещать ваш сайт, не оценивая его контент как уникальный.

И конечно ещё одной проблемой появления дублей может стать кража вашего контента (надеемся, что не наоборот). И если у потенциального вора будет успешный, с точки зрения поисковых машин, ресурс, то увы и ах, но именно он может стать номером один, что повлияет в дальнейшем на ваши позиции в выдаче.

Как найти дубли в рамках своего ресурса?

Во-первых, вы всегда можете обратиться к Яндекс.Вебмастер или его аналогу в Google, пройдя простой путь: «Оптимизация» – «Оптимизация HTML».

Либо воспользуйтесь строкой поиска и командой «site:»

site: вашсайт.ru — покажет страницы сайта «вашегосайта.ru», находящиеся в индексе поисковой системе (общий индекс).

site: вашсвйт.ru/& — покажет страницы сайта «вашегосайта.ru», участвующие в поиске (основной индекс).

Таким образом, вы сможете увидеть и определить малоинформативные страницы и частичные дубли, которые не участвуют в поиске и могут мешать страницам из основного индекса ранжироваться выше.

Когда вы определите все дубли страниц, то сможете избавиться от них, откорректировав движок сайта или добавив тег «rel=canonical» в заголовки страниц, например: http://www.example.com/product.php?item=swedish-fish" />

Так поисковый робот сможет понять, что поймет, что все дубликаты ссылаются на канонический адрес, указанный в теге.

Что делать, если ваш сайт попал под наказание поисковиковов?

Мы очень надеемся, что данная участь вас минует и что вы вовремя успеете провести базовый самостоятельный аудит своего ресурса, либо обратиться за помощью к специалистам, например, к нашей команде аналитиков и SEO-специалистов.

Но если вдруг вы столкнулись с тем, что ваш ресурс всё-таки каким-то образом заработал предупреждение или даже штраф, то следуйте советам ниже.

Шаг 1: Убедитесь, что вы на самом деле были наказаны

В большинстве случаев ваше наказание и штраф будут очевидны. Ваши страницы будут находиться в открытом доступе, но при этом являться непроиндексированными (deindexed). И в ваш кабинет Яндекса или Google Вебмастер придёт оповещение о полученном наказании. Ещё один способ уловить наказание — вовремя заметить значительную потерю трафика на сайт.

Шаг 2: Определите причину(ы) наказания

Как только вы будете уверены, что сайт был наказан, вы должны установить причину для штрафа. Если вы получите официальное уведомление из поисковых систем, этот этап можно считать пройденным.

Но, к сожалению, если ваш сайт стал жертвой алгоритмического обновления поискового робота, то вам придётся поиграть в детектива. Так как в момент смены алгоритма поисковых систем многие сайты рискуют попасть под наказания, не ведая, что именно они сделали не так.

Шаг 3: исправляйте нарушения в поведении сайта

Конечно, проще сказать, чем сделать. Этот шаг довольно сложный, но не терпит промедлений.

После того как вы определили, почему ваш сайт был наказан, вы должны методично исправить нежелательное поведение и ошибки, за которые вас заблокировали. Причин может быть великое множество, к сожалению, мы не можем описать их все здесь и сейчас, так как сколько сайтов и ошибок — столько вытекающих ситуаций.

Но мы всегда готовы предложить свою помощь в консультации или исправлении нарушений, если вы осознаете, что не готовы пройти через это в одиночку.

Шаг 4: отправляйте запрос на пересмотр наказания

После того как вы исправили все проблемы, нужно требовать пересмотра от поисковых систем с целью снятия наказания. И делать это максимально оперативно, чтобы не потерять ещё больше очков в ранжировании.

Однако будьте внимательны: если ваш сайт по факту ничего не нарушил, а как мы предположили, стал жертвой обновления алгоритмов поисковых систем, то просьба о пересмотре решения будет неэфективной, так как вам в любом случае придётся ждать конца обновления.Подводя итоги

Каждый пункт является важным звеном общей цепи SEO аудита. Вы можете ещё раз пройтись по ним от и до в Азбуке SEO или в Инструкции по самостоятельной оптимизации сайта, чтобы проанализировать комплексно все стороны оптимизации.

Мы не призываем вас быть радикальными: бросать все виды деятельности и с головой нырять в исследование сайта, либо наоборот тут же оставлять заявки на аудит. Постарайтесь осознать, какие последствия влечёт за собой закрытие глаз на процесс аудита сайта. Оцените риски, потери клиентов и доходов, ухудшение отношения к вам поисковых машин, продвижения в поиске и Интернете в целом, затем оцените свои силы, инвестиции и время. И только после этого принимайте самое верное решение конкретно для вашей ситуации.

salesgeneration.ru