Содержание

Правильный robots.txt для WordPress | Как сделать robots.txt

Содержание:

-

Что такое robots.txt

-

Для чего нужен robots.txt

-

Как редактировать robots txt

-

Правильный robots.txt для CMS WordPress

-

Проверка robots.txt

Вебмастера и маркетологи знают насколько важна индексация сайта поисковыми системами. Именно поэтому они делают все возможное, чтобы помочь поисковикам типа Google и Yandex правильно сканировать и индексировать свои сайты.

Большое количество времени и ресурсов тратятся на внутреннюю и внешнюю оптимизацию, такую как контент, ссылки, теги, оптимизация изображений и структуры сайта.

Всё это играет огромную роль в продвижении. Однако если вы забыли сделать техническую оптимизацию сайта, если вы не слышали о файлах robots.txt и sitemap.xml могут возникнуть проблемы с правильным сканированием и индексацией вашего сайта.

В этой статье я объясню как правильно настраивать и использовать файл robots.txt и мета-тег robots. Итак, начнем!

к содержанию ↑

Что такое robots.txt

Robots.txt – это текстовый файл, который используется в качестве инструкции для роботов поисковых систем (также известных как сканеры, боты или пауки), как сканировать и индексировать страницы сайта.

Простыми словами, robots.txt говорит роботам, какие страницы или файлы сайта мы хотим видеть в поиске, а какие нет.

В идеале файл robots.txt размещается в корневом каталоге вашего веб-сайта (https://site.com/robots.txt), чтобы роботы могли сразу получить доступ к его инструкциям.

Если вы используете CMS WordPress, то вы сможете увидеть ваш файл по вышеуказанному адресу, однако вы не найдете сам файл в общей папке с вашим сайтом. Это потому что WordPress автоматически создает виртуальный файл robots.txt (с параметрами по-умолчанию), если не находит данный файл в корневом каталоге сайта.

Это потому что WordPress автоматически создает виртуальный файл robots.txt (с параметрами по-умолчанию), если не находит данный файл в корневом каталоге сайта.

Виртуальный файл robots.txt CMS WordPress не решает всех необходимых задач, в связи с этим крайне желательно написать свой.

к содержанию ↑

Для чего нужен robots.txt

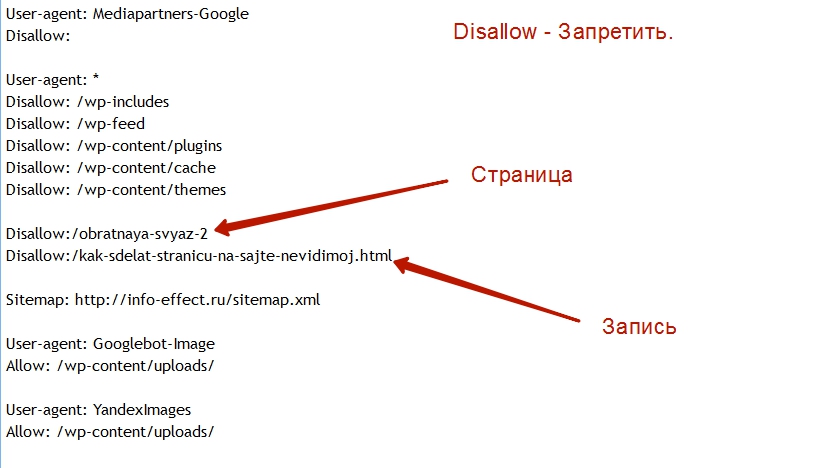

Файл robots.txt нужен, для того чтобы запретить поисковым роботам посещать определенные разделы вашего сайта, например:

- страницы пагинации;

- страницы с результатами поиска на сайте;

- административные файлы;

- служебные страницы;

- ссылки с utm-метками;

- данные о параметрах сортировки, фильтрации, сравнении;

- страница личного кабинета и т.п.

Важно! Файл robots.txt не является обязательным к исполнению поисковыми роботами. В связи с этим, если вы хотите на 100% быть уверенными в том что какая-либо из страниц вашего сайта не появится в поисковой выдаче – используйте мета-тег robots.

Согласно Cправке Google файл robots.txt не предназначен для того, чтобы запрещать показ веб-страниц в результатах поиска Google.

Если вы не хотите чтобы какая-то страница вашего сайта появилась в поиске вставьте в <head> страницы атрибут noindex:

<meta name=“robots” content=“noindex,nofollow”>

к содержанию ↑

Как редактировать robots txt

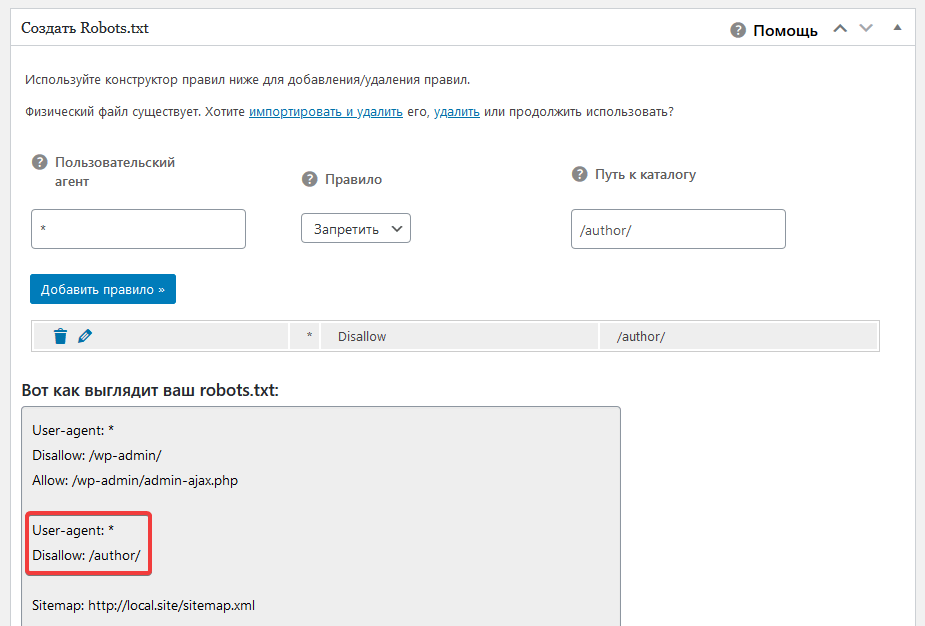

Редактировать файл robots.txt в CMS WordPress можно двумя способами. Добавить необходимый код в файл functions.php, или при помощи плагина.

В нашей компании мы предпочитаем второй способ.

Устанавливаем плагин Virtual Robots.txt из репозитория CMS WordPress, открываем его в админ. панеле во вкладке Настройки. В открывшееся поле плагина вносим необходимый код, жмем кнопку Save и вуаля – ваш файл robots.txt готов.

к содержанию ↑

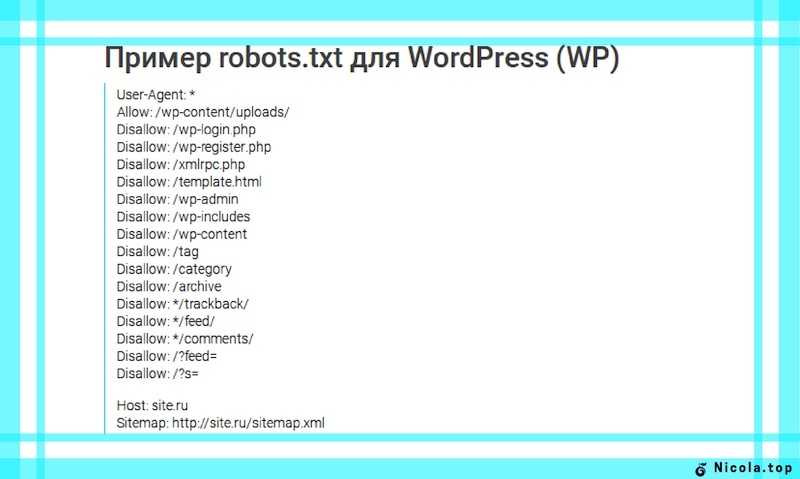

Правильный robots.txt для CMS WordPress

Взял с сайта seogio.ru и немного подкорректировал. Вот что получилось:

Вот что получилось:

User-agent: * # общие правила для роботов всех поисковых систем

Disallow: /cgi-bin # служебная папка для хранения серверных скриптов

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск по сайту

Disallow: *&s= # поиск по сайту

Disallow: /search/ # поиск по сайту

Disallow: /author/ # архив автора

Disallow: /users/ # архив пользователей

Disallow: */trackback # трекбеки, уведомления в комментариях о ссылке на веб-документ

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest. xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

Allow: /*/*.js # открываем файлы скриптов js

Allow: /*/*.css # открываем фалы css

Allow: /wp-*.png # разрешаем индексировать изображения

Allow: /wp-*.jpg # разрешаем индексировать изображения

Allow: /wp-*.jpeg # разрешаем индексировать изображения

Allow: /wp-*.gif # разрешаем индексировать гифки

Allow: /wp-admin/admin-ajax.php # разрешаем ajax

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.

xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

Allow: /*/*.js # открываем файлы скриптов js

Allow: /*/*.css # открываем фалы css

Allow: /wp-*.png # разрешаем индексировать изображения

Allow: /wp-*.jpg # разрешаем индексировать изображения

Allow: /wp-*.jpeg # разрешаем индексировать изображения

Allow: /wp-*.gif # разрешаем индексировать гифки

Allow: /wp-admin/admin-ajax.php # разрешаем ajax

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail. RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ru

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ru

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

к содержанию ↑

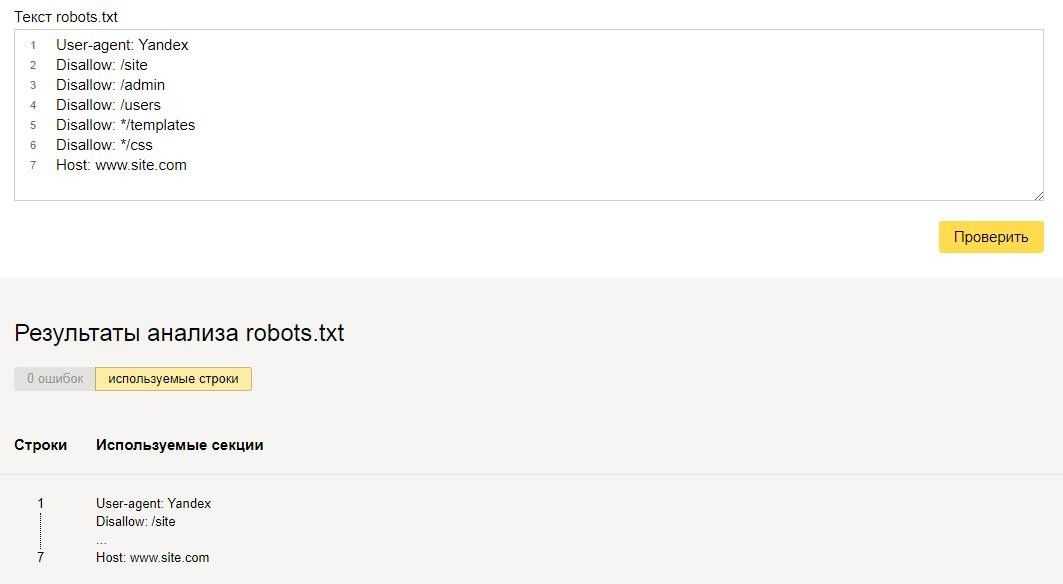

Проверка robots.txt

Если файл robots.txt настроен неправильно это может привести к множественным ошибкам в индексации сайта. Проверить правильность настройки вашего robots.txt можно с помощью бесплатного инструмента Google Robots Testing Tool

Выбираем наш сайт:

Вводим в строку путь к нашему файлу robots.txt и жмем кнопку Проверить:

В результате не должно быть ошибок и предупреждений и файл должен быть Доступен для роботов:

Если файл robots.txt настроен правильно, это значительно ускорит процесс индексации вашего сайта.

Розробка та Створення Сайтів | Веб Cтудія ESFIRUM

Esfirum

Довічна гарантія на наші сайти

Професійна розробка сайтів, створення унікально веб-дизайну, розробка мобільних додатків, інтернет-маркетинг (контекстна реклама, SEO, SMM).

Ви отримаєте сайт, який на 100% сподобається вам і вашим клієнтам!

Отримати консультацію

Esfirum

Studio

Наша веб-студія 5 років спеціалізується на розробці сайтів, мобільних додатків та інтернет-маркетингу. Створимо сайт виходячи з ваших потреб та побажань.

UI/UX дизайн сайтів

Детальніше

Наш унікальний веб-дизайн, з правильною архітектурою, допоможе не тільки залучати та утримувати відвідувачів на сайті, але й продавати більшу кількість продуктів. Ваш бізнес стане більш конкурентоспроможним та прибутковим.

Розробка сайтів

Детальніше

Створення веб-сайтів з інтеграцією в CMS WordPress. У роботі ми не використовуємо шаблони й темплейти. Завдяки цьому ваш сайт отримає високу швидкість завантаження та його легко можна буде просувати в пошукових системах.

Розробка додатків

Детальніше

Сьогодні мобільні пристрої використовують 80% людей по всьому світу. Ми надаємо послуги з розробки гібридних мобільних додатків для iOS і Android. Ви зможете взаємодіяти зі своїми клієнтами на їх улюблених мобільних пристроях.

Інтернет-маркетинг

Детальніше

Пошукове просування (SEO), SMM, контекстна реклама в Google Ads — напрямки в яких наша команда є експертами. Ми допоможемо вам залучити відвідувачів і клієнтів на сайт, збільшити продажі та поліпшити впізнаваність вашого бренду.

Переваги для клієнтів

Ставши клієнтом нашої веб-студії ви отримуєте не просто надійного партнера, а й додаткові, безкоштовні послуги від нашої команди

Отримати консультацію

Довічна гарантія

Довічна гарантія на наші сайти.

Ми перша веб-студія, яка дає довічну гарантію на свої веб-сайти. Ми впевнені в нашому продукті!

Ми впевнені в нашому продукті!

Домен і хостинг

Безкоштовно отримуєте домен і хостинг на 1 рік. Домен в будь-якій доменній зоні. Розміщення сайту на хостингу веб-студії Esfirum. Перенесення сайту в подарунок!

Сертифікат безпеки (SSL)

Безкоштовно надаємо сертифікат безпеки (SSL) для вашого сайту. На 40% підвищує довіру користувачів до сайту.

Підтримка сайту 24/7

Безкоштовна підтримка вашого сайту протягом 4 місяців. Це дозволить робити косметичні зміни на сайті, змінювати кольори, картинки, шрифти.

Наші технології

Ми експерти в веб-технологіях, яких достатньо для створення повного і максимально функціонального веб-сайту для вашого бізнесу.

Наші нагороди

Our experience is backed by the awards we have received

Нагороди Honourable Mention и Mobile Excellence від авторитетного порталу Awwwards

ТОП-5 серед веб-студій Львова за версією порталу CMS-Magazine

2-е місце серед веб-студій м. Львова, за версією порталу IT-Rating

Львова, за версією порталу IT-Rating

ТОП-10 серед PHP розробників за версією порталу Design Drizzle

Наша веб-студія на порталі goodfirms.com

Наша веб-студия на портале wadline.ru

Наша компанія є офіційним партнером модуля бронювання для готелів — Smart Planet

Наша гордість

Найкращі роботи

Дивитись все

клієнти про нас

Відгуки

шаблон WordPress robots.txt · GitHub

Этот файл содержит двунаправленный текст Unicode, который может быть интерпретирован или скомпилирован не так, как показано ниже. Для просмотра откройте файл в редакторе, который показывает скрытые символы Unicode.

Подробнее о двунаправленных символах Unicode

Показать скрытые символы

# Роботы рулят! — Иногда. .. # .. # | |

| Агент пользователя: * | |

| Разрешить: / | |

| # Запретить эти каталоги, типы URL и типы файлов | |

| Запретить: /trackback/ | |

| Запретить: /wp-admin/ | |

| Запретить: /wp-content/ | |

| Запретить: /wp-includes/ | |

| Запретить: /xmlrpc.php | |

| Запретить: /wp- | |

| Запретить: /cgi-bin | |

Запретить: /readme. html html | |

| Запретить: /license.txt | |

| Запретить: /*?* | |

| Запретить: /*.php$ | |

| Запретить: /*.js$ | |

| Запретить: /*.inc$ | |

| Запретить: /*.css$ | |

| Запретить: /*.gz$ | |

| Запретить: /*.wmv$ | |

| Запретить: /*.cgi$ | |

| Запретить: /*.xhtml$ | |

| Запретить: /*/wp-* | |

| Запретить: /*/канал/* | |

| Запретить: /*/*?s=* | |

Запретить: /*/*. js$ js$ | |

| Запретить: /*/*.inc$ | |

| Разрешить: /wp-content/uploads/ | |

| Агент пользователя: ia_archiver* | |

| Запретить: / | |

| Агент пользователя: duggmirror | |

| Запретить: / | |

| Карта сайта: http://yourdomain.com/sitemap.xml |

Что это такое и как его использовать

Вы когда-нибудь слышали термин robots. txt и задавались вопросом, как он применим к вашему веб-сайту? На большинстве веб-сайтов есть файл robots.txt, но это не значит, что большинство владельцев сайтов понимают его. В этом посте мы надеемся изменить это, предложив подробно изучить файл robots.txt WordPress, а также то, как он может контролировать и ограничивать доступ к вашему сайту.

txt и задавались вопросом, как он применим к вашему веб-сайту? На большинстве веб-сайтов есть файл robots.txt, но это не значит, что большинство владельцев сайтов понимают его. В этом посте мы надеемся изменить это, предложив подробно изучить файл robots.txt WordPress, а также то, как он может контролировать и ограничивать доступ к вашему сайту.

Нам предстоит многое рассказать, так что давайте начнем!

Что такое файл robots.txt WordPress?

Прежде чем мы поговорим о файле robots.txt WordPress, важно определить, что такое «робот» в данном случае. Роботы — это «боты» любого типа, которые посещают веб-сайты в Интернете. Наиболее распространенным примером являются сканеры поисковых систем. Эти боты «ползают» по сети, помогая таким поисковым системам, как Google, индексировать и ранжировать миллиарды страниц в Интернете.

Итак, боты есть, вообще , хорошая штука для интернета… ну или хотя бы нужная вещь. Но это не обязательно означает, что вы или другие владельцы сайтов хотите, чтобы боты свободно бегали. Желание контролировать взаимодействие веб-роботов с веб-сайтами привело к созданию 9Стандарт исключения роботов 0211 в середине 1990-х годов. Robots.txt является практической реализацией этого стандарта — . Он позволяет вам контролировать взаимодействие участвующих ботов с вашим сайтом . Вы можете полностью заблокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Желание контролировать взаимодействие веб-роботов с веб-сайтами привело к созданию 9Стандарт исключения роботов 0211 в середине 1990-х годов. Robots.txt является практической реализацией этого стандарта — . Он позволяет вам контролировать взаимодействие участвующих ботов с вашим сайтом . Вы можете полностью заблокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Однако эта часть «участия» важна. Robots.txt не может заставить бота следовать его указаниям. А вредоносные боты могут и будут игнорировать файл robots.txt. Кроме того, даже солидные организации игнорируют некоторые команд, которые вы можете поместить в robots.txt. Например, Google будет игнорировать любые правила, которые вы добавите в файл robots.txt о том, как часто его поисковые роботы посещают ваш сайт. Вы можете настроить скорость, с которой Google сканирует ваш веб-сайт, на странице настроек скорости сканирования вашего ресурса в Google Search Console.

Если у вас много проблем с ботами, может пригодиться защитное решение, такое как Cloudflare или Sucuri.

Как найти robots.txt?

Файл robots.txt находится в корне вашего веб-сайта, поэтому добавление /robots.txt после вашего домена должно загрузить файл (если он у вас есть). Например, https://kinsta.com /robots.txt .

Когда следует использовать файл robots.txt?

Для большинства владельцев сайтов преимущества хорошо структурированного файла robots.txt сводятся к двум категориям:

- Оптимизация ресурсов сканирования поисковых систем путем указания им не тратить время на страницы, которые вы не хотите индексировать . Это помогает поисковым системам сосредоточиться на сканировании наиболее важных для вас страниц.

- Оптимизация использования сервера путем блокировки ботов, которые тратят ресурсы впустую.

Robots.txt не предназначен конкретно для управления тем, какие страницы индексируются в поисковых системах

Robots. txt не является надежным способом контролировать, какие страницы индексируются поисковыми системами. Если вашей основной целью является предотвращение включения определенных страниц в результаты поисковой системы, правильным подходом является использование мета-тега noindex или защиты паролем.

txt не является надежным способом контролировать, какие страницы индексируются поисковыми системами. Если вашей основной целью является предотвращение включения определенных страниц в результаты поисковой системы, правильным подходом является использование мета-тега noindex или защиты паролем.

Это связано с тем, что файл robots.txt прямо не указывает поисковым системам не индексировать контент — он просто говорит им не сканировать его. Хотя Google не будет сканировать отмеченные области внутри вашего сайта, сам Google заявляет, что если внешний сайт ссылается на страницу, которую вы исключаете с помощью файла robots.txt, Google все равно может проиндексировать эту страницу.

Джон Мюллер, аналитик Google для веб-мастеров, также подтвердил, что если на страницу есть ссылки, указывающие на нее, даже если она заблокирована файлом robots.txt, она все равно может быть проиндексирована. Ниже приводится то, что он должен был сказать в видеовстрече Webmaster Central:

Здесь следует иметь в виду одну вещь: если эти страницы заблокированы robots.

txt, то теоретически может случиться так, что кто-то случайно ссылается на одну из этих страниц. . И если они это сделают, то может случиться так, что мы проиндексируем этот URL без какого-либо контента, потому что он заблокирован robots.txt. Таким образом, мы не знали бы, что вы не хотите, чтобы эти страницы действительно индексировались.

Принимая во внимание, что если они не заблокированы robots.txt, вы можете поместить на эти страницы метатег noindex. И если кто-то ссылается на них, и мы случайно просканируем эту ссылку и подумаем, что, может быть, здесь есть что-то полезное, тогда мы будем знать, что эти страницы не нужно индексировать, и мы можем просто полностью исключить их из индексации.

Итак, в этом отношении, если на этих страницах есть что-то, что вы не хотите индексировать, не запрещайте их, вместо этого используйте noindex .

Нужен ли мне файл robots.txt?

Важно помнить, что у вас нет файла robots. txt на вашем сайте. Если у вас нет проблем с тем, что все боты могут свободно сканировать все ваши страницы, вы можете не добавлять их, поскольку у вас нет реальных инструкций для сканеров.

txt на вашем сайте. Если у вас нет проблем с тем, что все боты могут свободно сканировать все ваши страницы, вы можете не добавлять их, поскольку у вас нет реальных инструкций для сканеров.

В некоторых случаях вы даже не сможете добавить файл robots.txt из-за ограничений используемой вами CMS. Это нормально, но есть и другие способы проинструктировать ботов о том, как сканировать ваши страницы без использования файла robots.txt.

Какой код состояния HTTP должен быть возвращен для файла robots.txt?

Файл robots.txt должен возвращать код состояния HTTP 200 OK, чтобы поисковые роботы могли получить к нему доступ.

Если у вас возникли проблемы с индексацией ваших страниц поисковыми системами, стоит дважды проверить код состояния, возвращенный для вашего файла robots.txt. Все, кроме кода состояния 200, может помешать поисковым роботам получить доступ к вашему сайту.

Некоторые владельцы сайтов сообщают о деиндексации страниц из-за того, что их файл robots. txt возвращает статус, отличный от 200. В марте 2022 года владелец веб-сайта спросил о проблеме с индексацией во время встречи Google SEO в рабочее время, и Джон Мюллер объяснил, что файл robots.txt должен либо возвращать статус 200, если они присутствуют, либо статус 4XX, если файл не существует. В этом случае возвращалась внутренняя ошибка сервера 500, которая, по словам Мюллера, могла привести к тому, что робот Googlebot исключил сайт из индексации.

txt возвращает статус, отличный от 200. В марте 2022 года владелец веб-сайта спросил о проблеме с индексацией во время встречи Google SEO в рабочее время, и Джон Мюллер объяснил, что файл robots.txt должен либо возвращать статус 200, если они присутствуют, либо статус 4XX, если файл не существует. В этом случае возвращалась внутренняя ошибка сервера 500, которая, по словам Мюллера, могла привести к тому, что робот Googlebot исключил сайт из индексации.

То же самое можно увидеть в этом твите, где владелец сайта сообщил, что весь его сайт деиндексирован из-за того, что файл robots.txt возвращает ошибку 500.

[Совет по поисковой оптимизации]

Если у вас возникли проблемы с индексированием, убедитесь, что ваш файл robots.txt возвращает либо 200, либо 404.

Если ваш файл возвращает 500, Google в конечном итоге деиндексирует ваш веб-сайт, как я видел в этом проекте. pic.twitter.com/8KiYLgDVRo

— Антуан Эрипрет (@antoineripret) 14 ноября 2022 г.

Можно ли использовать метатег Robots вместо файла robots.txt?

Нет. Метатег robots позволяет вам контролировать, какие страницы индексируются, а файл robots.txt позволяет вам контролировать, какие страницы сканируются. Боты должны сначала просканировать страницы, чтобы увидеть метатеги, поэтому вам следует избегать попыток использовать метатеги disallow и noindex, так как noindex не будет обнаружен.

Если ваша цель — исключить страницу из поисковых систем, метатег noindex обычно является лучшим вариантом.

Как создать и отредактировать файл robots.txt в WordPress

По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Так что, даже если вы и пальцем не пошевелите, на вашем сайте уже должен быть файл robots.txt по умолчанию. Вы можете проверить, так ли это, добавив «/robots.txt» в конец вашего доменного имени. Например, «https://kinsta.com/robots.txt» открывает файл robots.txt, который мы используем здесь, в Kinsta.

Пример файла robots.txt

Вот пример файла robots.txt компании Kinsta:

Пример файла robots.txt

В нем всем роботам указываются пути, которые следует игнорировать (например, путь wp-admin), с любыми исключениями (например, путь admin-ajax. php), а также расположение XML-карты сайта Kinsta.

Поскольку этот файл виртуальный, вы не можете его редактировать. Если вы хотите отредактировать файл robots.txt, вам нужно фактически создать физический файл на своем сервере, которым вы сможете манипулировать по мере необходимости. Вот три простых способа сделать это:

Как создать и отредактировать файл robots.txt в WordPress с помощью Yoast SEO

Если вы используете популярный плагин Yoast SEO, вы можете создать (а затем отредактировать) файл robots.txt прямо из интерфейса Yoast. Однако, прежде чем вы сможете получить к нему доступ, вам необходимо включить расширенные функции Yoast SEO, перейдя в SEO → Панель управления → Функции и переключив Страницы расширенных настроек :

Как включить расширенные функции Yoast

После активации вы можете идти. до SEO → Инструменты и нажмите Редактор файлов :

до SEO → Инструменты и нажмите Редактор файлов :

Как получить доступ к редактору файлов Yoast

Если у вас еще нет физического файла robots.txt, Yoast предложит вам Создать файл robots.txt :

Как создать robots.txt в Yoast

И как только вы нажмете эту кнопку, вы сможете редактировать содержимое вашего файла robots.txt прямо из того же интерфейса:

Как редактировать robots.txt в Yoast

Как вы читайте дальше, мы углубимся в то, какие типы директив следует помещать в файл robots.txt WordPress.

Как создать и отредактировать файл robots.txt с помощью All-in-One SEO

Если вы используете почти такой же популярный плагин Yoast All-in-One SEO Pack , вы также можете создавать и редактировать ваш файл WordPress robots.txt прямо из интерфейса плагина. Все, что вам нужно сделать, это перейти к All in One SEO → Инструменты :

Как перейти к robots.txt в All in One SEO

Затем переключите переключатель Enable Custom robots. txt , чтобы он был включен. Это позволит вам создавать собственные правила и добавлять их в файл robots.txt:

txt , чтобы он был включен. Это позволит вам создавать собственные правила и добавлять их в файл robots.txt:

Как добавить пользовательские правила в robots.txt в All-in-One SEO

Как создать и отредактировать файл robots.txt через FTP

Если вы не используете SEO-плагин, предлагающий функциональность robots.txt, и управляйте файлом robots.txt через SFTP. Сначала с помощью любого текстового редактора создайте пустой файл с именем «robots.txt»:

Как создать свой собственный файл Robots.txt

Затем подключитесь к своему сайту через SFTP и загрузите этот файл в корневую папку вашего сайта. . Вы можете внести дополнительные изменения в файл robots.txt, отредактировав его через SFTP или загрузив новые версии файла.

Что поместить в файл robots.txt

Хорошо, теперь у вас есть физический файл robots.txt на вашем сервере, который вы можете редактировать по мере необходимости. Но что вы на самом деле делаете с этим файлом? Что ж, как вы узнали из первого раздела, robots. txt позволяет вам контролировать, как роботы взаимодействуют с вашим сайтом. Вы делаете это с помощью двух основных команд:

txt позволяет вам контролировать, как роботы взаимодействуют с вашим сайтом. Вы делаете это с помощью двух основных команд:

- User-agent — это позволяет нацеливаться на определенных ботов. Пользовательские агенты — это то, что боты используют для идентификации себя. С ними можно было бы, например, создать правило, применимое к Bing, но не к Google.

- Запретить — позволяет запретить роботам доступ к определенным областям вашего сайта.

Также есть команда Разрешить , которую вы будете использовать в определенных ситуациях. По умолчанию все на вашем сайте помечено Разрешить , поэтому в 99% ситуаций нет необходимости использовать команду Разрешить . Но это удобно, когда вы хотите Запретить доступ к папке и ее дочерним папкам, но Разрешить доступ к одной конкретной дочерней папке.

Вы добавляете правила, сначала указав, к какому User-agent должно применяться правило, а затем перечислив, какие правила применять, используя Disallow и Allow . Существуют также некоторые другие команды, такие как Crawl-delay и Sitemap , но они либо:

Существуют также некоторые другие команды, такие как Crawl-delay и Sitemap , но они либо:

- Игнорируются большинством основных сканеров, либо интерпретируются совершенно по-разному (в случае задержки сканирования)

- Излишне использовать такие инструменты, как Google Search Console (для карт сайта)

Давайте рассмотрим некоторые конкретные варианты использования, чтобы показать вам, как все это сочетается.

Подпишитесь на информационный бюллетень

Хотите узнать, как мы увеличили трафик более чем на 1000%?

Присоединяйтесь к более чем 20 000 других людей, которые получают наш еженедельный информационный бюллетень с инсайдерскими советами по WordPress!

Подпишитесь сейчас

Как использовать Robots.txt Запретить все, чтобы заблокировать доступ ко всему вашему сайту

Допустим, вы хотите заблокировать все доступ сканера к вашему сайту. Это вряд ли произойдет на живом сайте, но пригодится для сайта разработки. Для этого вы должны добавить код robots.txt, запрещающий весь код, в файл robots.txt WordPress:

Это вряд ли произойдет на живом сайте, но пригодится для сайта разработки. Для этого вы должны добавить код robots.txt, запрещающий весь код, в файл robots.txt WordPress:

User-agent: * Disallow: /

Что происходит в этом коде?

Звездочка * рядом с User-agent означает «все пользовательские агенты». Звездочка — это подстановочный знак, означающий, что он применяется к каждому отдельному пользовательскому агенту. / косая черта рядом с Disallow говорит, что вы хотите запретить доступ к всем страницам , которые содержат «yourdomain.com/» (то есть каждая отдельная страница на вашем сайте).

Как использовать robots.txt, чтобы заблокировать доступ одного бота к вашему сайту

Давайте изменим ситуацию. В этом примере мы притворимся, что вам не нравится тот факт, что Bing сканирует ваши страницы. Вы все время являетесь командой Google и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы заблокировать только Bing от сканирования вашего сайта, вы должны заменить подстановочный знак *звездочка с Bingbot:

Чтобы заблокировать только Bing от сканирования вашего сайта, вы должны заменить подстановочный знак *звездочка с Bingbot:

Агент пользователя: Bingbot Disallow: /

По сути, приведенный выше код говорит , что только применяют правило Disallow к ботам с User-agent «Bingbot» . Теперь вы вряд ли захотите заблокировать доступ к Bing, но этот сценарий пригодится, если есть конкретный бот, которому вы не хотите получать доступ к своему сайту. На этом сайте есть хороший список имен большинства известных пользовательских агентов службы.

Как использовать robots.txt для блокировки доступа к определенной папке или файлу

В этом примере предположим, что вы хотите заблокировать доступ только к определенному файлу или папке (и ко всем подпапкам этой папки). Чтобы применить это к WordPress, допустим, вы хотите заблокировать:

- Всю папку wp-admin

- WP-логин.

php

php

Вы можете использовать следующие команды:

Агент пользователя: * Запретить: /wp-admin/ Disallow: /wp-login.php

Как использовать robots.txt Разрешить все, чтобы предоставить роботам полный доступ к вашему сайту

Если в настоящее время у вас нет причин блокировать доступ сканеров к любой из ваших страниц, вы можете добавить следующую команду.

Агент пользователя: * Разрешать: /

Или альтернативно:

User-agent: * Запретить:

Как использовать Robots.txt, чтобы разрешить доступ к определенному файлу в запрещенной папке

Хорошо, теперь предположим, что вы хотите заблокировать всю папку, но при этом разрешить доступ к определенному файлу внутри этой папки. Вот где 9Команда 0211 Разрешить пригодится. И это на самом деле очень применимо к WordPress. Фактически, виртуальный файл robots.txt WordPress прекрасно иллюстрирует этот пример:

User-agent: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php

Этот фрагмент блокирует доступ ко всей папке /wp-admin/ , кроме файла /wp-admin/admin-ajax.php .

Как использовать robots.txt, чтобы запретить ботам сканировать результаты поиска WordPress

Одна из настроек WordPress, которую вы, возможно, захотите сделать, — запретить поисковым роботам сканировать ваши страницы результатов поиска. По умолчанию WordPress использует параметр запроса «?s=». Итак, чтобы заблокировать доступ, все, что вам нужно сделать, это добавить следующее правило:

User-agent: * Запретить: /?s= Disallow: /search/

Это также может быть эффективным способом предотвращения программных ошибок 404, если вы их получаете. Обязательно прочитайте наше подробное руководство о том, как ускорить поиск в WordPress.

Как создать разные правила для разных ботов в robots.txt

До сих пор все примеры касались одного правила за раз. Но что, если вы хотите применить разные правила к разным ботам? Вам просто нужно добавить каждый набор правил в объявление User-agent для каждого бота. Например, если вы хотите, чтобы одно правило применялось ко всем ботам , а другое правило применялось бы только к Bingbot , вы можете сделать это следующим образом:

Например, если вы хотите, чтобы одно правило применялось ко всем ботам , а другое правило применялось бы только к Bingbot , вы можете сделать это следующим образом:

User-agent: * Запретить: /wp-admin/ Агент пользователя: Bingbot Запретить: /

В этом примере всем ботам будет заблокирован доступ к /wp-admin/, но Bingbot будет заблокирован доступ ко всему вашему сайту.

Проверка файла robots.txt

Чтобы убедиться, что файл robots.txt настроен правильно и работает должным образом, его следует тщательно протестировать. Один неуместный символ может иметь катастрофические последствия для производительности сайта в поисковых системах, поэтому тестирование может помочь избежать потенциальных проблем.

Тестер Google robots.txt

Инструмент Google robots.txt Tester (ранее входивший в состав Google Search Console) прост в использовании и выявляет потенциальные проблемы в вашем файле robots. txt.

txt.

Просто перейдите к инструменту и выберите свойство для сайта, который вы хотите протестировать, затем прокрутите страницу вниз и введите любой URL-адрес в поле, затем нажмите красную кнопку TEST :

Testing robots.txt files

Если все доступно для сканирования, вы увидите зеленый ответ Разрешено .

Вы также можете выбрать, с какой версией Googlebot вы хотите провести тест: Googlebot, Googlebot-News, Googlebot-Image, Googlebot-Video, Googlebot-Mobile, Mediapartners-Google или Adsbot-Google.

Вы также можете проверить каждый отдельный URL-адрес, который вы заблокировали, чтобы убедиться, что они действительно заблокированы и/или запрещены .

Остерегайтесь спецификации UTF-8

Спецификация означает метку порядка следования байтов и в основном является невидимым символом, который иногда добавляется в файлы старыми текстовыми редакторами и т.п. Если это произойдет с вашим файлом robots. txt, Google может неправильно его прочитать. Вот почему важно проверить файл на наличие ошибок. Например, как показано ниже, наш файл имел невидимый символ, и Google жалуется на непонимание синтаксиса. По сути, это делает первую строку нашего файла robots.txt недействительной, что нехорошо! У Гленна Гейба есть отличная статья о том, как UTF-8 Bom может убить ваш SEO.

txt, Google может неправильно его прочитать. Вот почему важно проверить файл на наличие ошибок. Например, как показано ниже, наш файл имел невидимый символ, и Google жалуется на непонимание синтаксиса. По сути, это делает первую строку нашего файла robots.txt недействительной, что нехорошо! У Гленна Гейба есть отличная статья о том, как UTF-8 Bom может убить ваш SEO.

Робот Google в основном базируется в США

Также важно не блокировать робота Googlebot из США, даже если вы ориентируетесь на локальный регион за пределами США. Иногда они выполняют локальное сканирование, но Googlebot в основном базируется в США .

Робот Google в основном базируется в США, но иногда мы также выполняем локальное сканирование. https://t.co/9KnmN4yXpe

— Google Search Central (@googlesearchc) 13 ноября 2017 г.

Что популярные сайты WordPress помещают в свой файл robots.

txt

txt

Чтобы на самом деле представить некоторый контекст для пунктов, перечисленных выше, вот как некоторые из самых популярных сайтов WordPress используют свои файлы robots.txt.

TechCrunch

TechCrunch Robots.txt File

Помимо ограничения доступа к ряду уникальных страниц, TechCrunch, в частности, запрещает поисковым роботам доступ к:

- /wp-admin/

- /wp-логин.php

Также установлены специальные ограничения на двух ботов:

- Swiftbot

- ИРЛбот

Если вам интересно, IRLbot — это поисковый робот из исследовательского проекта Техасского университета A&M. Это странно!

Фонд Обамы

Фонд Обамы Файл Robots.txt

Фонд Обамы не вносил особых дополнений, ограничивая доступ исключительно к /wp-admin/.

Angry Birds

Angry Birds Файл Robots.txt

Angry Birds имеет те же настройки по умолчанию, что и Фонд Обамы. Ничего особенного не добавляется.

Дрифт

Дрифт Robots. txt Файл

txt Файл

Наконец, Drift решает определить свои карты сайта в файле Robots.txt, но в остальном оставляет те же ограничения по умолчанию, что и The Obama Foundation и Angry Birds.

Правильно используйте Robots.txt

Завершая руководство по robots.txt, мы хотим еще раз напомнить вам, что использование команды Disallow в файле robots.txt не равнозначно использованию команды . тег noindex . Robots.txt блокирует сканирование, но не обязательно индексацию. Вы можете использовать его, чтобы добавить определенные правила, определяющие взаимодействие поисковых систем и других ботов с вашим сайтом, но он не будет явно контролировать, индексируется ли ваш контент или нет.

Большинству случайных пользователей WordPress нет необходимости в срочном изменении стандартного виртуального файла robots.txt. Но если у вас возникли проблемы с определенным ботом или вы хотите изменить способ взаимодействия поисковых систем с определенным плагином или темой, которую вы используете, вы можете добавить свои собственные правила.

xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

Allow: /*/*.js # открываем файлы скриптов js

Allow: /*/*.css # открываем фалы css

Allow: /wp-*.png # разрешаем индексировать изображения

Allow: /wp-*.jpg # разрешаем индексировать изображения

Allow: /wp-*.jpeg # разрешаем индексировать изображения

Allow: /wp-*.gif # разрешаем индексировать гифки

Allow: /wp-admin/admin-ajax.php # разрешаем ajax

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.

xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

Allow: /*/*.js # открываем файлы скриптов js

Allow: /*/*.css # открываем фалы css

Allow: /wp-*.png # разрешаем индексировать изображения

Allow: /wp-*.jpg # разрешаем индексировать изображения

Allow: /wp-*.jpeg # разрешаем индексировать изображения

Allow: /wp-*.gif # разрешаем индексировать гифки

Allow: /wp-admin/admin-ajax.php # разрешаем ajax

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail. RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ru

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ru

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

txt, то теоретически может случиться так, что кто-то случайно ссылается на одну из этих страниц. . И если они это сделают, то может случиться так, что мы проиндексируем этот URL без какого-либо контента, потому что он заблокирован robots.txt. Таким образом, мы не знали бы, что вы не хотите, чтобы эти страницы действительно индексировались.

txt, то теоретически может случиться так, что кто-то случайно ссылается на одну из этих страниц. . И если они это сделают, то может случиться так, что мы проиндексируем этот URL без какого-либо контента, потому что он заблокирован robots.txt. Таким образом, мы не знали бы, что вы не хотите, чтобы эти страницы действительно индексировались.

php

php php

php