Содержание

SEO-программисты. Кто это такие и зачем нужны

root

05.11.2013

2 комментария

Я SEO-специалист с 7-летним стажем, работающий в одном из крупных интернет-агентств Петербурга. Возможно, некоторые не знают, но сеошник это не тот, кто выгрузил семантическое ядро из wordstat, загрузил в ссылочный агрегатор и поднял сайт в топ. В работе над продвижением сайта около 40-50% времени уходит именно на внутреннюю оптимизацию сайта.

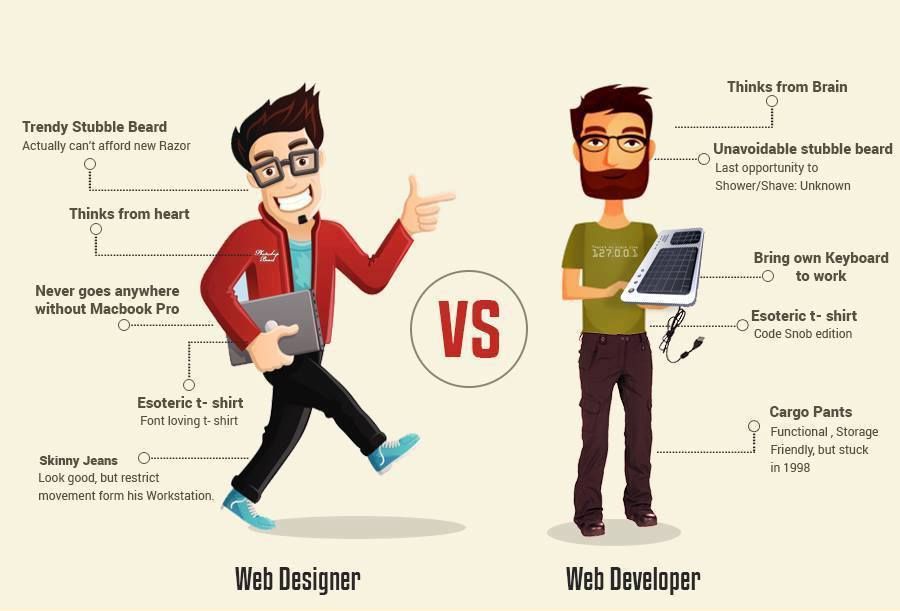

SEO-программист?

SEO-программист — относительно новое и редкое название специальности. Яндекс.Работа нашла только 12 открытых вакансий по всей России из нескольких сотен тысяч других.

Зачем нужен?

Обычно программированием под seo-задачи занимается либо сам сеошник, либо пишет задание обычному программисту. Но тут случаются некоторые проблемы: seo-специалист — либо программист с начальным уровнем знаний, либо, если сторонний программист не понимает смысла задачи и основ работы алгоритмов поисковых систем делает задачу не правильно или медленно (из-за затрат времени на понимание) или не оптимальный код или вообще отказывается выполнять задачу.

Для крупных проектов с десятками тысяч страниц и такой же суточной посещаемостью необходима автоматизация работы сайта. Уточню, что я говорю о задачах, которые направлены на улучшения сайта для посетителя или помощь поисковым системам индексировать сайт. Я против черных или серых методов продвижения. Всегда интереснее сделать реально полезный сайт, на который будут ссылаться, о нем будут говорить, на него будут возвращаться.

Зачем нужно пытаться управлять поисковыми роботами, они ведь сами сайт обойдут и тексты просканируют? Всегда нужно помнить, что поисковая система – это большой и медленный механизм, где многие процессы длятся месяцами и если нам этим грамотно не управлять, то и сайт будет также медленно получать своих клиентов. А в это время нас обгонят конкуренты. Задача любого бизнеса – получить прибыль и в максимально короткие сроки. Клиент нужен сейчас, а не через год. И нужно много, а не один в месяц.

Вот некоторые типичные примеры seo-задач:

- Генерация описаний к товарам, используя формулы, шаблоны и словари употребляемых слов.

- Генерация страниц под запросы или автоматические фильтры товаров.

- Генерация метатегов.

- Кластеризация запросов, по которым переходили на сайт.

- Расчет статического веса страниц и автоматическая перелинковка страниц.

- Анализ статистики истории покупок и построение товарных рекомендаций.

- Анализ логов сервера и построение графика статистики посещений поисковых роботов.

- Скрытие некоторых не нужных частей сайта и ссылок от поисковых роботов.

Варианты решить задачу. У seo-специалиста могут быть одновременно несколько проектов даже в рамках одной компании (не говоря об агентствах) и если он уйдет на месяц в разработку какого-либо модуля, то потонут остальные проекты. Поэтому данный путь не оптимален.

Второй вариант – написание ТЗ для обычного программиста. Но очень скоро наступит момент для вопросов: а что такое биграмма? Как провести сравнение по шинглам? По какому алгоритму работает технология SEO Hide? Дальше приходится рассказывать о матрикснет, алгоритме ВМ25, как рассчитывать Page Rank страниц, как сгенерировать текст, который не будет спамным и многое-многое другое. Если этого не рассказать, то обычно не достичь качественного результата.

Если этого не рассказать, то обычно не достичь качественного результата.

Отсюда на рынке появляется вопрос. Как оптимизировать работу по оптимизации не за счет временных затрат сеошника на программирование или обучение программиста? Ответ на него – нужно выращивать «заточенных» специалистов.

Что должен знать seo-программист?

Навыки программирования я перечислять не буду, считая их само собой разумеющиеся.

Во-первых, основы алгоритмов поиска. Это обязательный пункт, без мат. части никуда. Сюда входит BM25, TF-IDF, Page Rank.

Далее идут основы работ поисковых систем, в частности Яндекс и Гугл. Фильтры, алгоритмы. Что такое Яндекс Остров и как писать под него xml? Как пропарсить и проанализировать входящие ссылки на вероятность их спамности для Гугла?

В работе с внутренним кодом сайта уделяется внимание robots.txt, редиректам, sitemap, микроразметка. Конечно, прописать какие-то простые вещи не нужен специальный программист, но бывают задачи не всегда тривиальные. Например, в sitemap.xml расставлять приоритеты страниц в зависимости от того есть ли они в индексе обоих поисковых систем.

Например, в sitemap.xml расставлять приоритеты страниц в зависимости от того есть ли они в индексе обоих поисковых систем.

Особое внимание уделить изучению API различных сервисов, которые используются для сбора и анализа данных. Какие-то сервисы предоставляют информацию по конкурентам, какие-то помогают расширить семантическое ядро, какие-то сканируют входящие ссылки.

Основы лингвистики. Необходимо для вычленения словоформ, их склонения и группирования. Как отличить прилагательное от глагола или определить род существительного.

Текущая ситуация на рынке

Постепенно увеличивается спрос на seo-программистов. Это объясняется усложнением поисковых алгоритмов и повышением конкурентности в выдаче. Приходится искать новые решения и оптимального подхода.

Некоторые образовательные центры начинают прокачивать обычных программистов в seo-программистов.

Многие крупные веб-студии и интернет агентства «выращивают» внутренние кадры.

Помните когда начали появляться seo-копирайтеры из копирайтеров? Вот сейчас чем-то похожая ситуация.

Данное направление продолжит развиваться. При сотрудничестве сео-специалистов и программистов мы с вами посодействуем улучшению уровня качества сайтов, а также поможем поисковым системам показывать наиболее релевантные результаты, а сеошники не станут продолжать искать дыры в алгоритмах, которые так любят использовать в России.

+2

0

SEO

выводим сайт в топ поисковых систем

SEO для программиста важен не меньше, чем для контентщика. Поисковые системы учитывают не только наполнение сайта, но и теги, адаптивность, юзабилити, производительность и те показатели, которые на это влияют. Разберёмся, на что именно обращать внимание.

***

- Да, работал самостоятельно

- Да, работал по рекомендациям от SEO-специалиста

- Нет, ещё не приходилось

Формирование структуры сайта

Структура — это логическая схема расположения и взаимосвязей страниц сайта относительно друг друга, и первое, что вы должны сделать, это убедиться в правильности структуры. Почему? Просто дальнейшая работа с сайтом, у которого изначально неправильная структура, не имеет смысла: всё равно придётся возвращаться и перерабатывать

Почему? Просто дальнейшая работа с сайтом, у которого изначально неправильная структура, не имеет смысла: всё равно придётся возвращаться и перерабатывать

На что это влияет:

- Индексация — поисковые роботы лучше индексируют сайты с корректной структурой.

- Видимость — грамотно проработанная структура в связке с ключами и мета-тегами расширяет видимость сайта по целевым запросам.

- Юзабилити — удобная для пользователя структура делает навигацию по сайту простой и интуитивно понятной, что хорошо сказывается на поведенческих факторах.

Пример корректно составленной структуры:

Хоть немного знакомый с SEO программист знает, что чем выше в дереве сайта страница, тем лучше её видимость для поисковых ботов. Однако это не значит, что следует выносить все страницы на второй уровень (туда, где на схеме находятся разделы), так как в этом случае навигация станет сложной и запутанной.

С точки зрения юзабилити, также нежелательно злоупотреблять редиректами. Пример: кликнув на страницу из «Подраздела 1», пользователь внезапно оказывается на странице из «Подраздела 2».

Пример: кликнув на страницу из «Подраздела 1», пользователь внезапно оказывается на странице из «Подраздела 2».

Навигация

Дополнительными навигационными элементами являются меню, хлебные крошки, разделы с рекомендуемыми товарами или материалами, самые популярные темы, etc. Грубо говоря, это любые внутренние ссылки, которые в идеале должны закольцовываться. Что это значит? Допустим, на главной странице есть меню, которое содержит ссылку на «Раздел 1». Для лучшей индексации с «Раздела 1» также должна быть обратная ссылка на главную страницу, и чаще всего это ссылка в самом логотипе в шапке сайта: таким образом, каждая из страниц сайта также ведёт на главную страницу.

Технический аудит сайта

Это анализ, который позволяет выявить слабые места в технической составляющей сайта и выводится SEO-специалистами в формате отчёта. Тем не менее проанализировать сайт можно и самостоятельно.

Скорость загрузки сайта

Крайне важная метрика для SEO. Программист должен следить за скоростью работы сайта, ведь этот показатель учитывается при ранжировании поисковыми системами. В PageSpeed Insights можно проверить скорость загрузки сайта как с десктопа, так и с мобильных устройств:

В PageSpeed Insights можно проверить скорость загрузки сайта как с десктопа, так и с мобильных устройств:

Сервис также предоставляет доступ к таким показателям:

- FCP — первая отрисовка контента;

- LCP — отрисовка самого крупного контента;

- FID — задержка первого взаимодействия со страницей;

- CLS — совокупный сдвиг вёрстки (почитайте нашу статью о том, как улучшить CLS).

Микроразметка

Валидность кода — это соответствие исходного кода сайта нормам и правилам, описанным Консорциумом Всемирной Паутины, или сокращённо W3C. Валидный код позволяет поисковым системам эффективнее работать с веб-ресурсом, и при прочих равных условиях роботы поисковых систем отдают предпочтение сайту с валидным кодом, а значит этот сайт будет находиться выше в поисковой выдаче.

Проверьте сайт с помощью валидатора HTML и XHTML документов Markup Validation Service и учтите указанные в результатах недочёты.

Обратите отдельное внимание на такие теги, как title, description, подзаголовки h2, h3, h4 (например, подзаголовок h2 должен быть строго один на страницу) и alt картинок: все они должны быть оптимизированы в соответствии с подобранными ключевыми запросами для каждой отдельной страницы. Наиболее удобным инструментом для быстрой проверки мета-тегов является расширение Google Chrome SEO META in 1 CLICK.

Наиболее удобным инструментом для быстрой проверки мета-тегов является расширение Google Chrome SEO META in 1 CLICK.

Составляем файл robots.txt

robots.txt — это текстовый файл, который содержит параметры индексирования сайта для поисковых роботов. С помощью этого файла и специальных инструкций в нём (директив) можно управлять индексацией сайта. Грубо говоря, с robots.txt мы можем сообщать роботу поисковой системы, какие страницы можно индексировать, а какие нельзя.

Две директивы для данного файла обязательны: это User-agent и Allow либо Disallow. Необязательной, но часто встречающейся директивой является Sitemap. Разберём их чуть подробнее:

- В

User-agentуказывается поисковой робот, к которому относятся команды из файла. Примеры:User-agent: Yandex,User-agent: Googlebot,User-agent: *(включает все боты). - Disallow запрещает индексировать прописанные в нём отдельные страницы или целые разделы.

Примеры:

Примеры: Disallow: /catalog/,Disallow: /catalog/page.html. Allow, напротив, разрешает индексировать разделы и страницы сайта. Работает для всего сайта по умолчанию, если обратное не обозначено директивойDisallow. Чаще всегоAllowиспользуется в связке сDisallow, когда одну часть раздела нужно закрыть от индексации, а другую — открыть.Sitemapсодержит ссылку на карту сайта, где прописана вся его структура. Пример:Sitemap: sitemap.xml.

Пример составленного файла robots.txt для всех поисковых систем со всеми открытыми страницами и картой сайта:

User-agent: * Allow: / Sitemap: sitemap.xml

Sitemap

Обязательно проверьте, чтобы карта сайта была полной, страницы начинались с актуального для вашего ресурса протокола (чаще всего это https://), а важные для поисковых систем страницы были с кодом ответа сервера 200 и обязательно индексировались:

Обратите внимание на десктопную программу Screaming Frog SEO Spider для комплексного анализа сайта: с её помощью удобно проверять мета-теги, карту сайта, каноничность страниц, безопасность и многое другое.

Дополнительные рекомендации

- Все стили, используемые в макете, а также JavaScript-код свыше 15-20 строк выносите в отдельные файлы: так код станет легче, а сёрфинг по страницам — быстрее.

- Используйте единый формат адресов для ссылок — это относится к слэшам в конце, а также названиям страниц и разделов: везде должен быть или транслит, или перевод на английский.

- Добивайтесь кроссбраузерности и адаптации под мобильные устройства.

- Убирайте системные файлы из индексации.

- Проверьте корректность работы 404-страницы: она должна быть везде, где это необходимо.

- Прописывайте внешним ссылкам

target="_blank", чтобы они открывались с новой вкладки, не закрывая при этом вашу страницу (это напрямую влияет на поведенческие факторы). - Своевременно устраняйте битые ссылки и закрывайте незакрытые парные HTML-теги.

- SEO для программиста также включает размещение точек захвата — любых элементов для удержания пользователя, которые подталкивают его на дальнейшее взаимодействие с сайтом.

Остались вопросы по SEO-оптимизации? Задавайте в комментариях.

Реклама на Tproger: найдем для вас разработчиков нужного стека и уровня.

Подробнее

Реклама на tproger.ru

Загрузка

Что каждый программист должен знать о SEO — Кейт Мацудайра

За последние несколько лет, с тех пор как я начал уделять внимание SEO, я заметил много «руководств по SEO для разработчиков». В основном эти руководства написаны разработчиками, а не SEO-специалистами. На данный момент я не являюсь ни тем, ни другим, но, поскольку последние несколько лет я работал в компании, занимающейся инструментами для SEO, мне удалось накопить немало знаний по этой теме. Конечно, то, что мне нравится в SEO, мне нравится и в поиске: большие данные, высокая производительность и интересные алгоритмы. Ниже я собрал минимальное количество знаний о SEO, которое должен иметь разработчик, чтобы должным образом оптимизировать веб-сайт для обнаружения поисковыми системами (обратитесь за помощью к разработчикам веб-сайтов в Вегасе). Я в основном написал это для своей команды и нескольких других людей, которые спрашивали, но, надеюсь, вы найдете это полезным. О, и особая благодарность за этот пост Брайсу Ховарду — мне очень повезло, что есть такой блестящий человек, который помогает мне редактировать. ——————— Чтобы понять SEO, я думаю, полезно начать с основ:

Я в основном написал это для своей команды и нескольких других людей, которые спрашивали, но, надеюсь, вы найдете это полезным. О, и особая благодарность за этот пост Брайсу Ховарду — мне очень повезло, что есть такой блестящий человек, который помогает мне редактировать. ——————— Чтобы понять SEO, я думаю, полезно начать с основ:

Как работают поисковые системы?

Если у вас есть время, прочтите статью об архитектуре Google: http://infolab.stanford.edu/~backrub/google.html Среди нас есть читатели технического описания 🙂 И они определенно объясняют концепции более подробно, о которых я упоминаю лишь вскользь. Так что же происходит?

- Пользователь вводит запрос

- Запрос классифицирован (это нетривиальная проблема поиска информации, поскольку категория действительно имеет значение, вы можете прочитать немного больше здесь: http://en.wikipedia.org/wiki/Web_query_classification)

- Сканирует коллекцию документов, организованных аналогично инвертированным индексам (http://en.

wikipedia.org/wiki/Inverted_index), чтобы сопоставить запрос с набором соответствующих документов

wikipedia.org/wiki/Inverted_index), чтобы сопоставить запрос с набором соответствующих документов - Результаты возвращаются пользователю, отсортированные по релевантности (релевантность также является еще одной серьезной проблемой — http://en.wikipedia.org/wiki/Relevance_(information_retrieval) )

Но это только половина дела: еще до того, как вы приступите к вводу запроса, вам предстоит решить серьезную проблему с большими данными, чтобы как можно быстрее обнаружить, упорядочить и получить эти результаты.

- Поисковый робот должен просканировать ваш сайт (и любой другой сайт в сети)

- Индексирует все страницы (это означает, что поисковая система должна иметь возможность «анализировать» и сохранять содержимое каждой веб-страницы в Интернете)

- Организует проиндексированную коллекцию и сохраняет вместе с соответствующими метаданными, чтобы обеспечить чрезвычайно быстрые и релевантные результаты поиска (и на этом этапе есть две интересные проблемы — классификация документов (http://en.

wikipedia.org/wiki/Document_classification) и создание эффективный индекс поисковой системы (http://en.wikipedia.org/wiki/Index_(search_engine) )

wikipedia.org/wiki/Document_classification) и создание эффективный индекс поисковой системы (http://en.wikipedia.org/wiki/Index_(search_engine) )

Порядок, в котором возвращаются результаты, определяется степенью релевантности. Грубо говоря, релевантность — это произведение количества ключевых слов запроса, найденных на данной странице, и авторитетности домена этой страницы. Очевидно, что поисковая система заботится о том, что вы говорите на своем сайте, но еще больше им важно, что другие люди говорят о вас (или, другими словами, как они ссылаются на вас). Таким образом, авторитетность — это комбинация входящих ссылок с соответствующим анкорным текстом. PageRank (http://searchengineland.com/what-is-google-pagerank-a-guide-for-searchers-webmasters-11068 — определение) — еще одна важная часть. власти. В своей простейшей форме PageRank — это популярность, и каждый сайт, который ссылается на ваш сайт, считается голосом за вашу популярность. Чем популярнее сайт, тем больше его голос в рейтинге популярности. Конечно, такой алгоритм легко обыграть (например, с фермами ссылок, круговыми ссылками и т. д.), поэтому Google разработал факторы, влияющие на авторитет любого сайта, включая разнообразие доменов, насколько важны домены, которые ссылаются на ваш сайт, и т. д. Использование полномочий для фильтрации спама или вредоносных сайтов имеет большой смысл — трудно подделать сотни или тысячи ссылок, которые делают страницу релевантной для поиска. Якорный текст (http://www.seomoz.org/learn-seo/anchor-text), используемый для ссылки на сайт, является сильным сигналом о релевантности различным запросам (и это также помогает объяснить, почему наличие ключевого слова в название вашего сайта полезно для ранжирования по этому ключевому слову — поэтому большая часть входящего анкорного текста на ваш сайт будет использовать название вашего бренда или веб-сайта). на больше об этом, если вы заинтересованы.———————

Конечно, такой алгоритм легко обыграть (например, с фермами ссылок, круговыми ссылками и т. д.), поэтому Google разработал факторы, влияющие на авторитет любого сайта, включая разнообразие доменов, насколько важны домены, которые ссылаются на ваш сайт, и т. д. Использование полномочий для фильтрации спама или вредоносных сайтов имеет большой смысл — трудно подделать сотни или тысячи ссылок, которые делают страницу релевантной для поиска. Якорный текст (http://www.seomoz.org/learn-seo/anchor-text), используемый для ссылки на сайт, является сильным сигналом о релевантности различным запросам (и это также помогает объяснить, почему наличие ключевого слова в название вашего сайта полезно для ранжирования по этому ключевому слову — поэтому большая часть входящего анкорного текста на ваш сайт будет использовать название вашего бренда или веб-сайта). на больше об этом, если вы заинтересованы.———————

Основы

Как разработчик, когда вы думаете об основах SEO (или о том, что вам нужно знать о SEO, что в основном означает не облажаться), вы видите следующее:

Убедитесь, что ваш сайт доступен для сканирования.

Когда дело доходит до сканирования, необходимо учитывать два ключевых момента: сделать ваш сайт (и ваши страницы) доступными для обнаружения и убедиться, что ваш контент правильно проиндексирован (индексация). Это влечет за собой обеспечение доступности всех страниц для робота, и что, когда робот просматривает страницы, он видит все 9 страниц.0012 соответствующий контент. Убедитесь, что страницы отображаются без включенного JavaScript — просматривайте, как это делал бы сканер! Самое интересное во всех этих причудливых Ajax и JavaScript заключается в том, что вы можете выборочно отображать вещи и динамически генерировать контент — недостатком является то, что вам нужно убедиться, что вы делаете это правильно для людей (или, в данном случае, роботов) без JavaScript. Просматривайте свой сайт с отключенным JavaScript и убедитесь, что все ссылки и страницы доступны, а контент отображается (инструменты разработчика Firefox позволяют легко просматривать без JavaScript). сканеры, чтобы зарегистрировать вашу страницу как релевантную, вам нужно убедиться, что они могут видеть весь контент. Поэтому, если вы загружаете кучу текста динамически с помощью Ajax или JavaScript, создайте версию без JavaScript, которая будет отображать ту же информацию. как вы создаете ссылки и привязываете текст к внутренним страницам вашего сайта. Якорный текст является ключевой частью алгоритма поисковой системы, поэтому, если у вас нет других страниц в Интернете, ссылающихся на страницы вашего сайта (например, вы только что начали свой блог, и никто еще не ссылался на него и т. д.), тогда Лучшее, что вы можете сделать, это убедиться, что ваши собственные внутренние ссылки используют релевантные ключевые слова в якорном тексте. Используйте описательный якорный текст на страницах — даже на своем сайте. Часто это отличный случай для навигации по цепочкам — это помогает с анкорным текстом и предоставляет релевантные внутренние ссылки и анкорный текст на вашем сайте. Ограничение количества ссылок на странице (есть много мнений по этому поводу, но обычно, если у вас слишком много ссылок, ваш сайт может быть сочтен спамом поисковой системой).

сканеры, чтобы зарегистрировать вашу страницу как релевантную, вам нужно убедиться, что они могут видеть весь контент. Поэтому, если вы загружаете кучу текста динамически с помощью Ajax или JavaScript, создайте версию без JavaScript, которая будет отображать ту же информацию. как вы создаете ссылки и привязываете текст к внутренним страницам вашего сайта. Якорный текст является ключевой частью алгоритма поисковой системы, поэтому, если у вас нет других страниц в Интернете, ссылающихся на страницы вашего сайта (например, вы только что начали свой блог, и никто еще не ссылался на него и т. д.), тогда Лучшее, что вы можете сделать, это убедиться, что ваши собственные внутренние ссылки используют релевантные ключевые слова в якорном тексте. Используйте описательный якорный текст на страницах — даже на своем сайте. Часто это отличный случай для навигации по цепочкам — это помогает с анкорным текстом и предоставляет релевантные внутренние ссылки и анкорный текст на вашем сайте. Ограничение количества ссылок на странице (есть много мнений по этому поводу, но обычно, если у вас слишком много ссылок, ваш сайт может быть сочтен спамом поисковой системой). Сканер не может проиндексировать страницу, которую он не видит. Результаты поиска состоят из контента, связанного со страницей. Если вы используете Ajax, убедитесь, что содержимое каждой страницы вашего сайта имеет собственный URL. Иногда вы видите сайты Ajax, на которых пользователь может взаимодействовать и отображать страницу без появления нового URL-адреса — это может выглядеть потрясающе с точки зрения удобства использования, но это может реально помешать вашему рейтингу в поисковых системах, если вы не сделали версию, которая позволяет пользователю доступ ко всему этому контенту без Ajax. Следуйте рекомендациям по работе с URL. Если вы используете соглашения об URL «по-новому», это может повредить вашему SEO. Например, добавление # как часть URL-адреса, такого как «http://www.yourdomain.com/p#product7». Google рассматривает это как привязку, а не как уникальный URL-адрес, поэтому, если это уникальная страница, рассмотрите стандартный параметр запроса. .

Сканер не может проиндексировать страницу, которую он не видит. Результаты поиска состоят из контента, связанного со страницей. Если вы используете Ajax, убедитесь, что содержимое каждой страницы вашего сайта имеет собственный URL. Иногда вы видите сайты Ajax, на которых пользователь может взаимодействовать и отображать страницу без появления нового URL-адреса — это может выглядеть потрясающе с точки зрения удобства использования, но это может реально помешать вашему рейтингу в поисковых системах, если вы не сделали версию, которая позволяет пользователю доступ ко всему этому контенту без Ajax. Следуйте рекомендациям по работе с URL. Если вы используете соглашения об URL «по-новому», это может повредить вашему SEO. Например, добавление # как часть URL-адреса, такого как «http://www.yourdomain.com/p#product7». Google рассматривает это как привязку, а не как уникальный URL-адрес, поэтому, если это уникальная страница, рассмотрите стандартный параметр запроса. .

Используйте правильные ключевые слова во всех нужных местах

Есть много мест, которые перечисляют и охватывают их, но просто убедитесь, что вы попали во все основы:

- Поместите их в URL (и даже лучше, если в вашем доменном имени есть ваши ключевые слова)

- Название страницы

- Имейте тег h2 (и вы можете использовать CSS, чтобы сделать его меньше, чем ваш h3, если хотите)

- Добавляйте замещающий текст к изображениям (и другим объектам, таким как видео и т.

д.) и используйте описательные имена файлов изображений. Если вы сомневаетесь, посмотрите на стандарты доступности (http://www.w3.org/standards/webdesign/accessibility) — там, где есть альтернативный текст для программ чтения с экрана, есть альтернативный текст для поисковых систем (и это означает аудиозаписи, йоу!) .

д.) и используйте описательные имена файлов изображений. Если вы сомневаетесь, посмотрите на стандарты доступности (http://www.w3.org/standards/webdesign/accessibility) — там, где есть альтернативный текст для программ чтения с экрана, есть альтернативный текст для поисковых систем (и это означает аудиозаписи, йоу!) .

Наличие на странице контекстуально релевантного текстового контента. Если вы читали статьи о TFIDF (http://web4.cs.ucl.ac.uk/staff/jun.wang/blog/2009/07/08/tf-idf/) и LDA (http://www .cs.princeton.edu/~blei/papers/BleiNgJordan2003.pdf) вы можете немного узнать о некоторых алгоритмах, которые служат основой для алгоритмов, используемых для классификации вашего сайта. Если вы разбираетесь в этих документах, то важность наличия на ваших страницах хорошего текстового контента, читаемого роботом, должна быть очевидной. Просто убедитесь, что это не дублированный контент…. Говорят, что порядок слов имеет значение; поэтому размещайте наиболее релевантные из них впереди и вверху страницы. Вот почему хорошее SEO диктует «название страницы | имя сайта», а не наоборот для заголовков. И, наконец, последний вывод по этой теме — никогда не переусердствуйте; слишком много ключевых слов (или наполнение ключевыми словами) является сигналом спама, поэтому выберите что-то разумное.

Вот почему хорошее SEO диктует «название страницы | имя сайта», а не наоборот для заголовков. И, наконец, последний вывод по этой теме — никогда не переусердствуйте; слишком много ключевых слов (или наполнение ключевыми словами) является сигналом спама, поэтому выберите что-то разумное.

Избегайте дублирования контента

Google (и другие поисковые системы) с помощью алгоритмов обнаружения дубликатов, таких как shingling (подробнее об этом можно прочитать в этой главе учебника: http://infolab.stanford.edu/~ullman/mmds/ch4 .pdf ) Избегайте дублирования контента из Интернета (если только вы не объединяете его с большим количеством другого контента, чтобы он выглядел иначе, как мы делаем с заголовками и фрагментами новостей на страницах наших продуктов). Это, конечно, относится и к страницам вашего собственного сайта. Дублирование контента может сбить поисковую систему с толку относительно того, какая страница является авторитетной (это также может привести к штрафам, если вы просто вырезаете и вставляете контент других людей), и тогда вы можете иметь свои собственные страницы, конкурирующие друг с другом за ранжирование! дублируйте контент, используйте rel=canonical, чтобы поисковые системы знали, какой URL-адрес следует считать авторитетным. Но что, если ваша страница является копией другой, найденной в Интернете? Что ж, тогда начните придумывать некоторые стратегии, чтобы добавить больше текста и информации, чтобы выделить ваши страницы, потому что такой дублированный контент вряд ли будет хорошо ранжироваться.

Но что, если ваша страница является копией другой, найденной в Интернете? Что ж, тогда начните придумывать некоторые стратегии, чтобы добавить больше текста и информации, чтобы выделить ваши страницы, потому что такой дублированный контент вряд ли будет хорошо ранжироваться.

Используйте интеллектуальные мета-описания

Это небольшие фрагменты, которые отображаются на страницах результатов поиска под вашей ссылкой. На самом деле это не так важно для SEO, но очень важно, если вы хотите, чтобы пользователи на самом деле нажимали на ваши ссылки (и разве это не единственная причина, по которой вы все равно хотите иметь высокий рейтинг?). Правильные метаописания позволяют пользователю быстро определить, ваша страница действительно то, что они искали, что-то, что может значительно улучшить рейтинг кликов (и, следовательно, трафик) со страницы результатов поиска. Вот ссылка на некоторые рекомендации по мета-описаниям: http://www.seomoz. org/learn-seo/meta-descriptionДля опытных пользователей — попросите Google продемонстрировать навигацию по сайту: http://support. google.com/webmasters/bin/answer.py?hl=ru&answer=47334.

google.com/webmasters/bin/answer.py?hl=ru&answer=47334.

Свежесть!

Google чаще сканирует сайты, которые обновляются чаще (с качественным содержанием). Новые сайты также имеют более высокий рейтинг, поэтому убедитесь, что хотя бы часть вашего сайта регулярно обновляется; Корпоративный блог — отличный способ сделать это (к тому же он может дать вам место для добавления контекстно релевантного контента для ваших пользователей — ура!). Если вы ведете блог, старайтесь не показывать весь пост на странице. Почему? Ну, тогда на вашей странице есть дубликат сайта, пока эта страница не переместится в архивы (поэтому, если у вас есть возможность, покажите только отрывок на главной странице). Подробнее о новизне здесь: http://www.seomoz.org/blog /google-fresh-фактор

Быстро — скорость сайта

Google заявил, что скорость загрузки страницы имеет значение в их алгоритме, поэтому убедитесь, что вы настроили свой сайт и соблюдаете рекомендации, чтобы ускорить работу. http://searchengineland.com/google-now-counts-site-speed-as-ranking-factor-39708Это также полезно для вашего бизнеса: более быстрая загрузка страниц увеличивает количество конверсий.http://www. wordstream.com/blog/ws/2011/08/23/page-speed-conversion-rate-optimization (хорошая инфографика на эту тему по этой ссылке.)

http://searchengineland.com/google-now-counts-site-speed-as-ranking-factor-39708Это также полезно для вашего бизнеса: более быстрая загрузка страниц увеличивает количество конверсий.http://www. wordstream.com/blog/ws/2011/08/23/page-speed-conversion-rate-optimization (хорошая инфографика на эту тему по этой ссылке.)

301 против 302 и ошибки сайта (например, 404)

Как я упоминал ранее в этой статье, ссылки являются важной частью алгоритма любой поисковой системы. Вы хотите, чтобы любые имеющиеся у вас ссылки продолжали способствовать увеличению вашего трафика и рейтинга. Вам следует настроить учетную запись инструментов Google для веб-мастеров (https://www.google.com/webmasters/tools/home?hl=en) и погрузиться в нее. в раздел ошибок сканера. Если у вас есть сайт, который существует некоторое время, скорее всего, у вас может быть несколько ошибок 404. Например, это может часто случаться с коммерческими сайтами, на которых продукты приходят и уходят — старые страницы продуктов больше не актуальны, поэтому эти URL-адреса могут возвращать 404, когда пользователь их вводит (или нажимает на них в результатах поиска) для просмотра. продукт. Убедитесь, что вы правильно перенаправляете 301 все URL-адреса рейтинга, которые были перемещены (301 представляет собой постоянную переадресацию — http://support.google.com/webmasters/bin/answer.py?hl=ru&answer=9).3633) на другую релевантную страницу или, по крайней мере, на дружественную страницу, объясняющую, что URL-адрес больше недействителен (страница, которая возвращает сообщение OK со статусом 200). Таким образом, любые ссылки, входящие на старую страницу, будут перенаправлены, поэтому, надеюсь, пользователи лучший опыт, и вы сохраните любую карму SEO, которую вы создали для старой страницы. Здесь есть отличный ресурс по этому методу: http://www.seomoz.org/learn-seo/redirection, в том числе почему вы не должны использовать 302 (в большинстве случаев).

продукт. Убедитесь, что вы правильно перенаправляете 301 все URL-адреса рейтинга, которые были перемещены (301 представляет собой постоянную переадресацию — http://support.google.com/webmasters/bin/answer.py?hl=ru&answer=9).3633) на другую релевантную страницу или, по крайней мере, на дружественную страницу, объясняющую, что URL-адрес больше недействителен (страница, которая возвращает сообщение OK со статусом 200). Таким образом, любые ссылки, входящие на старую страницу, будут перенаправлены, поэтому, надеюсь, пользователи лучший опыт, и вы сохраните любую карму SEO, которую вы создали для старой страницы. Здесь есть отличный ресурс по этому методу: http://www.seomoz.org/learn-seo/redirection, в том числе почему вы не должны использовать 302 (в большинстве случаев).

Будьте терпеливы

Может потребоваться некоторое время, чтобы увидеть результаты ваших SEO-модификаций. Это имеет смысл, если учесть время, необходимое роботу Google для сканирования обновленных страниц, а затем обработки каждой страницы и обновления всех соответствующих индексов новыми контента. И это может занять довольно много времени, когда вы имеете дело с петабайтами контента. Только представьте, сколько времени уходит на создание веб-индекса, его обновление и сохранение нужных вещей в инвертированном индексе. в моей предыдущей компании мы сканировали Интернет, и даже несмотря на то, что мы оптимизировали всю нашу систему для повышения скорости, сканирование 10 миллиардов страниц все равно может занять больше недели, особенно если вы уважаете вежливость роботов (http://en.wikipedia.org/). wiki/Web_crawler#Politeness_policy) и экспоненциальный откат. Кроме того, поскольку Google хочет, чтобы поисковые запросы и результаты были быстрыми, все индексы предварительно вычисляются, а это занимает время, иногда много времени. И даже если ваш сайт был в индексе, вам нужно ждать, пока люди будут запрашивать эти ключевые слова, а затем переходить на ваш сайт — и, если вы еще не являетесь авторитетным, это может занять некоторое время! Иногда весь этот процесс может занять много времени.

И это может занять довольно много времени, когда вы имеете дело с петабайтами контента. Только представьте, сколько времени уходит на создание веб-индекса, его обновление и сохранение нужных вещей в инвертированном индексе. в моей предыдущей компании мы сканировали Интернет, и даже несмотря на то, что мы оптимизировали всю нашу систему для повышения скорости, сканирование 10 миллиардов страниц все равно может занять больше недели, особенно если вы уважаете вежливость роботов (http://en.wikipedia.org/). wiki/Web_crawler#Politeness_policy) и экспоненциальный откат. Кроме того, поскольку Google хочет, чтобы поисковые запросы и результаты были быстрыми, все индексы предварительно вычисляются, а это занимает время, иногда много времени. И даже если ваш сайт был в индексе, вам нужно ждать, пока люди будут запрашивать эти ключевые слова, а затем переходить на ваш сайт — и, если вы еще не являетесь авторитетным, это может занять некоторое время! Иногда весь этот процесс может занять много времени. месяц, так что наберитесь терпения.

месяц, так что наберитесь терпения.

Подбор ключевых слов

Существует множество стратегий и действий, которые можно использовать для подбора правильных ключевых слов — слишком много для объема этого поста. Тем не менее, вот некоторые ключевые моменты, на которые следует обратить внимание при выборе:

- Поймите, что на самом деле ищут ваши пользователи — каковы их намерения?

- Некоторые ключевые слова являются конкурентоспособными, найдите те, по которым вы сможете ранжироваться, лучше ориентируясь на наиболее релевантные ключевые слова или создавая ссылки с релевантным анкорным текстом

- Посмотрите на объем трафика — не стоит ориентироваться на ключевые слова, которые не конвертируются или не имеют достаточного объема. Вы можете получить эту информацию с помощью Google Analytics через раздел SEO-оптимизация и запросы или в Google Webmaster Tools. Вот ссылка с некоторыми другими стратегиями: http://www.seomoz.org/ugc/3-awesome-ways-to-leverage-google-analytics-in-ecommerce-seo

- Нацеливайте контент на ключевые слова (например, сообщения в блогах на определенные термины или вопросы, которые ваши целевые пользователи, скорее всего, будут вводить в поле поиска. Я знаю, что некоторые люди проверяют это количественно, покупая рекламу, хотя у меня самого меньше опыта в этой конкретной стратегии и некоторые оговорки — так что сделайте свое исследование.)

.

Если вы хотите узнать больше, вот несколько полезных ссылок: http://www.searchenginejournal.com/how-to-do-keyword-research-infographic/40437/http://www.searchengineguide.com/ lisa-barone/five-steps-to-efficient-keywor.phphttp://www.seospeedsight.com/seoforum/general-seo-discussion/how-to-build-increase-web-traffic-part-1-long- tail-keyword-strategy/http://www.prelovac.com/vladimir/how-to-do-clever-keyword-research

Создание ссылок

Поскольку ссылки и анкорный текст являются ключевой частью SEO, в какой-то момент вы можете подумать о том, чтобы получить больше ссылок на свой сайт. Как разработчик, вы, вероятно, не хотите разговаривать с кучей людей, чтобы получить ссылки (по крайней мере, я не хочу — я ненавижу взаимодействие любого рода, связанное с продажами). Типичное построение ссылок так же, как это звучит — вы делаете все возможное, чтобы получить ссылки, указывающие на ваш сайт — это может быть через сделки, партнерство, PR-презентации, обмен ссылками — даже оплата ссылок (хотя я бы не рекомендовал эту тактику). Хотя, как правило, поскольку поисковые системы пытаются удалить «хром» веб-сайтов, то, если ваша ссылка выглядит как рекламный баннер, это может иметь меньшее значение, поэтому «платный» не всегда лучшая стратегия. Как отметил один комментатор на Hacker News, лучшая стратегия для большинства сайтов, когда дело доходит до создания ссылок, — это создание интересного контента, на который люди захотят ссылаться. Хотя поиск дополнительных ссылок более выгоден, более релевантные ссылки могут помочь не меньше. Если у вас есть партнер по распространению вашего контента, или вы создаете виджет, или что-то еще, что люди будут размещать в Интернете, что ссылается на ваш сайт, — вы можете значительно повысить релевантность ссылок, убедившись, что все ссылки содержат оптимальные ключевые слова в якорном тексте.

Как разработчик, вы, вероятно, не хотите разговаривать с кучей людей, чтобы получить ссылки (по крайней мере, я не хочу — я ненавижу взаимодействие любого рода, связанное с продажами). Типичное построение ссылок так же, как это звучит — вы делаете все возможное, чтобы получить ссылки, указывающие на ваш сайт — это может быть через сделки, партнерство, PR-презентации, обмен ссылками — даже оплата ссылок (хотя я бы не рекомендовал эту тактику). Хотя, как правило, поскольку поисковые системы пытаются удалить «хром» веб-сайтов, то, если ваша ссылка выглядит как рекламный баннер, это может иметь меньшее значение, поэтому «платный» не всегда лучшая стратегия. Как отметил один комментатор на Hacker News, лучшая стратегия для большинства сайтов, когда дело доходит до создания ссылок, — это создание интересного контента, на который люди захотят ссылаться. Хотя поиск дополнительных ссылок более выгоден, более релевантные ссылки могут помочь не меньше. Если у вас есть партнер по распространению вашего контента, или вы создаете виджет, или что-то еще, что люди будут размещать в Интернете, что ссылается на ваш сайт, — вы можете значительно повысить релевантность ссылок, убедившись, что все ссылки содержат оптимальные ключевые слова в якорном тексте. . Вы также должны убедиться, что все ссылки на ваш сайт указывают на ваш основной домен (http://www.yourdomain.com, а не на поддомен, такой как http://widget.yourdomain.com). Кроме того, вы хотите, чтобы как можно больше ссылок содержали соответствующий альтернативный текст. Вы поняли идею. 🙂 Другой, возможно, менее очевидный способ создания ссылок (или, по крайней мере, трафика) — это использование социальных сетей. Так что настройте свои Facebook, Twitter и Google+ и, когда у вас появятся новые ссылки, обязательно поделитесь ими. Эти каналы также могут работать как эффективный канал для привлечения большего трафика на ваш сайт. [также смотрите комментарии, чтобы узнать больше мнений о линкбилдинге — есть много сильных мнений по этой теме, хотя в целом это тот вопрос, над которым у вас меньше всего контроля, поэтому я не тратил на него столько времени]

. Вы также должны убедиться, что все ссылки на ваш сайт указывают на ваш основной домен (http://www.yourdomain.com, а не на поддомен, такой как http://widget.yourdomain.com). Кроме того, вы хотите, чтобы как можно больше ссылок содержали соответствующий альтернативный текст. Вы поняли идею. 🙂 Другой, возможно, менее очевидный способ создания ссылок (или, по крайней мере, трафика) — это использование социальных сетей. Так что настройте свои Facebook, Twitter и Google+ и, когда у вас появятся новые ссылки, обязательно поделитесь ими. Эти каналы также могут работать как эффективный канал для привлечения большего трафика на ваш сайт. [также смотрите комментарии, чтобы узнать больше мнений о линкбилдинге — есть много сильных мнений по этой теме, хотя в целом это тот вопрос, над которым у вас меньше всего контроля, поэтому я не тратил на него столько времени]

В заключение

Алгоритмы современных поисковых систем были тщательно оптимизированы для обнаружения мошенников, спам-сайтов или других лиц, пытающихся злоупотребить системой, но, что наиболее важно, для предоставления пользователю только наиболее релевантных результатов. Взгляните на факторы ранжирования SEOmoz в поисковых системах, чтобы увидеть, сколько вещей учитывают системы в качестве входных данных для релевантности и авторитетности — http://www.semoz.org/article/search-ranking-factors. Например, многие SEO-специалисты говорят о важности наличия разных доменов, ссылающихся на ваш сайт, которые не находятся в одном и том же C-блоке IP-адресов, а другие скажут вам, что циклическая ссылка («вы ссылаетесь на меня, и я ссылка на вас») менее ценна. Конечно, это нюансы системы, так что на вашем месте я бы не стал тратить свою энергию на беспокойство по этому поводу, а вместо этого сосредоточился бы на создании отличного сайта с потрясающим контентом, если только вы не собираетесь заниматься поисковой оптимизацией на постоянной основе. это, вероятно, более эффективное использование ваших усилий (особенно если вы можете написать код для решения реальных проблем). По теме: Зачем вам нужно использовать специализированную поисковую оптимизацию, такую как поисковая оптимизация казино Godrank? Так что, конечно, есть много способов обмануть систему, но в целом вам лучше всего следовать передовым методам и тратить свою энергию на создание реальной ценности, отличного контента и продуктов.

Взгляните на факторы ранжирования SEOmoz в поисковых системах, чтобы увидеть, сколько вещей учитывают системы в качестве входных данных для релевантности и авторитетности — http://www.semoz.org/article/search-ranking-factors. Например, многие SEO-специалисты говорят о важности наличия разных доменов, ссылающихся на ваш сайт, которые не находятся в одном и том же C-блоке IP-адресов, а другие скажут вам, что циклическая ссылка («вы ссылаетесь на меня, и я ссылка на вас») менее ценна. Конечно, это нюансы системы, так что на вашем месте я бы не стал тратить свою энергию на беспокойство по этому поводу, а вместо этого сосредоточился бы на создании отличного сайта с потрясающим контентом, если только вы не собираетесь заниматься поисковой оптимизацией на постоянной основе. это, вероятно, более эффективное использование ваших усилий (особенно если вы можете написать код для решения реальных проблем). По теме: Зачем вам нужно использовать специализированную поисковую оптимизацию, такую как поисковая оптимизация казино Godrank? Так что, конечно, есть много способов обмануть систему, но в целом вам лучше всего следовать передовым методам и тратить свою энергию на создание реальной ценности, отличного контента и продуктов. Поисковые системы продолжают совершенствоваться, и требуется все больше и больше изощренности, чтобы обойти все проблемы и риск выпадения из индекса (http://www.seo.com/blog/black-hat-seo-infographic/). Но SEO — это не только создание отличного сайта, который можно сканировать и иметь правильный контент, — это еще и конвертация пользователей. Поэтому убедитесь, что у вас есть много метрик и вы знаете, как использовать такие вещи, как Google Analytics. Таким образом, вы можете отслеживать, что работает для вас, а что нет, и оптимизировать свои усилия. И если вы все это освоили, попробуйте Google Website Optimizer (это бесплатно) и улучшите цвета, текст и макет Поднимите конверсию еще на одну ступень. И, наконец, если вы правильно построили свой сайт и оптимизировали свои страницы, наиболее оправданной стратегией SEO являются ссылки, поэтому подумайте о способах получения виджетов или ссылок с других сайтов. Надеюсь, этого достаточно для начала! И если вам нужна дополнительная информация, есть немало отличных SEO-сайтов, где вы можете продолжить чтение.

Поисковые системы продолжают совершенствоваться, и требуется все больше и больше изощренности, чтобы обойти все проблемы и риск выпадения из индекса (http://www.seo.com/blog/black-hat-seo-infographic/). Но SEO — это не только создание отличного сайта, который можно сканировать и иметь правильный контент, — это еще и конвертация пользователей. Поэтому убедитесь, что у вас есть много метрик и вы знаете, как использовать такие вещи, как Google Analytics. Таким образом, вы можете отслеживать, что работает для вас, а что нет, и оптимизировать свои усилия. И если вы все это освоили, попробуйте Google Website Optimizer (это бесплатно) и улучшите цвета, текст и макет Поднимите конверсию еще на одну ступень. И, наконец, если вы правильно построили свой сайт и оптимизировали свои страницы, наиболее оправданной стратегией SEO являются ссылки, поэтому подумайте о способах получения виджетов или ссылок с других сайтов. Надеюсь, этого достаточно для начала! И если вам нужна дополнительная информация, есть немало отличных SEO-сайтов, где вы можете продолжить чтение. Видеообзоры Web 20 Ranker тоже могут оказаться полезными. P.S. У Google есть довольно хорошее руководство по основам SEO, которое вы также можете проверить — оно охватывает некоторые вещи, которые я здесь не упомянул, а именно rel=nofollow ссылки и robots.txt — две важные темы.

Видеообзоры Web 20 Ranker тоже могут оказаться полезными. P.S. У Google есть довольно хорошее руководство по основам SEO, которое вы также можете проверить — оно охватывает некоторые вещи, которые я здесь не упомянул, а именно rel=nofollow ссылки и robots.txt — две важные темы.

10 способов улучшить SEO-усилия с помощью навыков программирования

Навыки программирования не являются обязательным условием для SEO-компетентности, но дополнительные навыки всегда повышают эффективность.

Вот 10 способов, с помощью которых понимание кода может помочь превратить хорошее SEO в отличное.

1. Стандарты кодирования HTML и SEO идут рука об руку

Специалист по поисковой оптимизации, знакомый с HTML, понимает, как должен быть структурирован веб-документ, и знает о последствиях неправильного кодирования.

Важным строительным блоком веб-страницы являются HTML-элементы, которые для веб-страницы являются тем же, чем фундамент, дверь, пол и крыша для дома.

Поисковые системы могут быть не в состоянии правильно сканировать веб-страницу, если элементы HTML используются неправильно.

Официальные спецификации HTML ограничивают использование HTML-элементов в разделе

(расположение метаданных, которое видят только браузеры и боты) и HTML-элементов в разделе (сам документ, который видят пользователи).Но когда вы помещаете элементы

(например, илиЭта ошибка может возникнуть, если код пикселя Facebook размещен в неправильном месте в разделе

веб-страницы. Другим примером того, как недостаток знаний в области программирования влияет на SEO, является ответное сообщение об ошибке 400.

Некоторые SEO-специалисты считают, что код ошибки 400 — это плохо, потому что они видят слово «ошибка» и сразу же думают, что ее нужно исправить, потому что мы понимаем ошибки как то, что нужно исправить, особенно когда они отображаются в Google Search Console как ошибки.

Но специалист по поисковой оптимизации, знающий стандарты кодирования HTML, понимает, что код ответа об ошибке 400 означает только то, что ЗАПРОС страницы браузера ошибочен (поскольку страницы не существует).

В большинстве случаев это хорошо, так и должно быть, и тут нечего исправлять.

Знание стандартов HTML делает человека лучшим SEO-специалистом, потому что он может обнаружить даже больше проблем, чем SEO-специалист, которому не хватает знаний в области кодирования.

Они также лучше подготовлены к тому, чтобы отклонить распространенную дезинформацию SEO, которая возникает из-за отсутствия навыков кодирования.

2. Структурированные данные

Структурированные данные — это язык разметки, что означает, что код имеет правила, определяющие способ его написания.

Существует несколько различных способов представления структурированных данных Schema.org, но предпочтительный Google, структурированные данные JSON-LD, возможно, является самым простым для понимания, что упрощает устранение неполадок.

Как и HTML, JSON-LD имеет правила, определяющие способ его написания, с вложенной структурой, в которой у вас есть субъект структурированных данных (называемый типом), а затем атрибуты этого субъекта (называемые свойством).

Понять структурированные данные JSON-LD легко, независимо от того, знаете ли вы HTML или любой другой язык разметки.

Преимущества понимания того, как кодировать структурированные данные, невозможно переоценить.

Правильная разметка структурированных данных необходима для достижения многих желанных позиций расширенных результатов в верхней части страниц результатов поисковой системы Google (также известных как SERP).

Неправильная разметка структурированных данных сделает эту веб-страницу непригодной для расширенных результатов.

Можно положиться на средство проверки разметки структурированных данных Google, чтобы проверить, являются ли структурированные данные JSON-LD действительными и подходят ли они для расширенного результата.

Но то, что инструмент говорит, что код действителен, не означает, что он подходит для расширенных результатов. Именно здесь вступает в игру способность анализировать JSON-LD, чтобы исправить структурированные данные, чтобы получить расширенные результаты.

Возможность ручного устранения неполадок важна, потому что средство проверки структурированных данных Google сообщает вам, когда они повреждены, и дает общее представление о том, где они повреждены. Тем не менее, он не говорит вам, как это исправить.

Конечно, можно положиться на плагины. Есть преимущества в том, чтобы установить что-то и забыть об этом.

Но спецификации структурированных данных постоянно развиваются, и плагины не всегда успевают за ними достаточно быстро. Кроме того, они не всегда достаточно специфичны для каждой ситуации.

При высоком рейтинге в результатах поиска, как правило, лучше всего знать, как кодировать структурированные данные JSON-LD, чтобы получить максимальное преимущество перед конкурентами.

3. Лучше общаться с клиентами

Знание того, как кодировать, позволяет человеку упростить объяснение, чтобы клиент, не умеющий кодировать, мог понять причину конкретной проблемы и решения.

Нельзя объяснить то, чего они не понимают.

Например, знание того, как кодировать структурированные данные, позволяет специалисту по поисковой оптимизации не только объяснить, что объединение структурированных данных — это нормально, но и объяснить преимущества этого и то, как это сделать.

Знание того, как кодировать, позволяет объяснить, что клиенту нужно всего лишь добавить несколько строк кода в файл functions.php дочерней темы своего веб-сайта WordPress, чтобы избежать установки раздутого плагина, который делает то же самое.

Не говоря уже о том, что оптимизатор без навыков кодирования даже не знает о решении с файлом functions. php, человек, который кодирует и разбирается в PHP, может понять, когда лучше использовать плагин вместо решения для кодирования, а затем объяснить это пользователю. клиент.

php, человек, который кодирует и разбирается в PHP, может понять, когда лучше использовать плагин вместо решения для кодирования, а затем объяснить это пользователю. клиент.

Знание того, как кодировать, дает возможность смотреть на HTML-код и сосредотачиваться на том, почему сайт не индексируется должным образом или работает плохо.

Однажды я проводил аудит сайта электронной коммерции, который использовал сделанный на заказ шаблон и (плохо) отличался сумасшедшим уровнем некомпетентного кодирования. Простое исправление этих кодов по всему сайту позволило сайту точно индексировать свой контент.

Знание HTML позволило мне отловить ошибки, а затем объяснить клиенту, почему он не работает и как они могут это исправить.

4. .htaccess Знание — сила

.htaccess (на мой взгляд) сложный язык для изучения, но достаточно простой для понимания того, как его использовать.

Просто узнать о преимуществах .htaccess и о том, для чего он полезен, а затем о том, как добавить его в файл, может вообще далеко завести человека.

Например, вы можете использовать плагин для перенаправления HTTP на HTTPS, плагин для перенаправления определенных измененных страниц и плагин для исправления неверных URL-адресов на правильный URL-адрес.

Но все это можно сделать с помощью файла .htaccess.

Потратив время на изучение .htaccess, вы сможете понять, как улучшить веб-сайт, не прибегая к другому плагину.

Файл .htaccess также можно использовать для предотвращения ссылок других сайтов на ваши изображения и другие мультимедийные файлы (горячие ссылки).

Использование файла .htaccess может даже использоваться для предотвращения копирования вашего контента мошенническими ботами путем блокировки диапазонов IP-адресов вредоносных ботов, которые неоднократно обращаются к веб-сайту.

Делать что-то подобное с файлом .htaccess значительно лучше, чем использовать плагин или мод, который записывает IP-адреса в базу данных, потому что добавление десятков тысяч или миллионов IP-адресов в базу данных значительно замедлит работу вашего сайта.

5. Диагностика скрытых проблем

Как правило, проблемы, связанные с кодированием, скрыты от глаз в HTML-коде.

Поскольку большинство сайтов построены по шаблону, количество ошибок будет увеличиваться на каждой странице, которая использует шаблонную структуру. Научиться использовать валидатор HTML несложно, но понимание HTML важно для интерпретации результатов.

Ошибки кодирования могут быть бросающимися в глаза и очевидными, например пропуск закрывающей скобки (>).

Или это может быть незаметно, например, использование нестандартного символа в коде, например умная кавычка, фигурный тип кавычки ( » » ) вместо ожидаемой прямой формы кавычки (» » ).

Эта ошибка обычно возникает, когда кто-то копирует код с программного устройства, которое по умолчанию вставляет смарт-кавычки.

Проблема с фигурными кавычками может серьезно нарушить индексацию и анализ веб-страницы.

Это означает, что если вы используете что-то вроде этого в HTML-коде:

« robots » content= « noindex » >

Google не увидит его, потому что фигурные кавычки (умные кавычки) не позволяют ему видеть его как метатег robots и, следовательно, приступают к индексации контента.

Вот еще один пример.

Если кодировать ссылку следующим образом:

пример

Ссылка будет интерпретироваться так:

https://example.com/test.htm

Если же использовать фигурные кавычки для того же кода:

6. Кодирование может помочь выйти из тупика SEOСлово «пат» пришло из игры в шахматы.

Он описывает ситуацию, когда игровой процесс зашел в тупик, и ни одна из сторон не может двигаться к победе. По сути, это состояние, которое считается ничьей.

Та же ситуация происходит в конкурентных отраслях, где все используют одни и те же издательские платформы, одни и те же плагины оптимизации, одни и те же стратегии контента и одни и те же стратегии продвижения ссылок.

Конкуренция между сайтами в основном равная, ни один сайт не имеет явного преимущества перед другим.

Специалист по поисковой оптимизации с навыками кодирования может выйти из такого тупика.

Навыки кодирования позволяют оптимизатору внедрять решения, улучшающие шаблоны, CSS и JavaScript.

Например, многие шаблоны поставляются со свободным использованием заголовков для вещей, которые не требуют элемента заголовка, например навигации на боковой панели.

Обладая навыками программирования, легко создать дочернюю тему и исправить неправильные элементы заголовков, чтобы они использовали CSS, а не заголовки для оформления элементов на странице.

Я использовал свои навыки программирования, чтобы полностью изменить разделы шаблона, чтобы сделать его более удобным для пользователя, изменить цвета различных элементов на странице, чтобы они были более доступны для посетителей с дальтонизмом, и добавить динамические биты контента с помощью PHP для создания тегов заголовков, а также для удаления лишних частей веб-страницы.

Навыки программирования помогают повысить рейтинг любого сайта и могут быть использованы для улучшения взаимодействия с пользователем помимо того, что предлагает шаблон.

Это особенно важно в конкурентных нишах, где конкуренты максимально оптимизированы и где ценится выжимание преимущества.

7. Устранение неполадок со взломанным сайтом

Безопасность веб-сайта не кажется чем-то, о чем должен беспокоиться SEO-специалист.

Но становится совершенно ясно, что безопасность веб-сайта действительно является проблемой SEO, когда поисковые рейтинги взломанного сайта начинают исчезать.

Знание того, как кодировать, особенно с общим пониманием того, как файлы PHP работают в данной системе управления контентом (CMS), может помочь демистифицировать событие взлома.

Простое знание общих принципов работы PHP и того, как все части CMS работают вместе, поможет понять, что пошло не так и как исправить проблемы.

Знание JavaScript также полезно. Многие взломы основаны на загрузке файлов JavaScript или внедрении JavaScript в другие файлы.

Анализ недавно измененных файлов JavaScript может помочь подтвердить, что сайт был взломан. Более того, это может помочь определить, несет ли ответственность за взлом конкретный плагин или сам WordPress.

Некоторые уязвимости могут оставаться скрытыми месяцами или годами, прежде чем их обнаружат. WordPress 5.9.2 был выпущен для устранения уязвимостей межсайтового скриптинга, которые были в самом ядре WordPress.

В случае уязвимости WordPress проблема возникла из-за загадочной ошибки кодирования, когда порядок, в котором были закодированы процессы безопасности, создавал ситуацию, когда хакер мог обойти те же самые меры безопасности.

Он иллюстрирует, как ошибки могут проникнуть в легитимное программное обеспечение и не обязательно вовремя обнаруживаться, чтобы предотвратить взлом.

Google может уведомить владельца сайта через Google Search Console о взломанном сайте, но Google Search Console не исправит это за вас.

Некоторые знания о том, как работает HTML, JavaScript и/или PHP, могут иметь большое значение для уверенного устранения неполадок на взломанном сайте.

8. Знание того, как кодировать, обеспечивает контроль

При работе в корпоративной или образовательной среде, где шаблоны заблокированы, и никто не может подключить их, чтобы выбраться из затруднительного положения, знание того, как программировать, может ускорить в противном случае болезненный процесс публикации веб-страниц.

Независимо от того, работаете ли вы в среде Drupal или WordPress, возможность вести шпаргалку с фрагментами кода экономит много времени даже при таких тривиальных действиях, как изменение ссылки, без необходимости прохождения 10 шагов с использованием собственного интерфейса WYSIWYG и работы с ними.

со своеобразным кодом.

9. Оптимизация для скорости страницы

Предложения по улучшению скорости страницы, которые предлагает Google PageSpeed Insights, больше не будут загадочными, как только вы научитесь программировать.

Также не нужно учиться программировать весь веб-сайт с нуля.

Все, что требуется, — это общее понимание JavaScript, CSS и HTML, чтобы понять, что нужно делать, чтобы веб-сайт работал быстрее.

Такие концепции, как встраивание CSS, комбинирование JavaScript и минимизация JavaScript, становятся более понятными, если вы понимаете, как серверы доставляют веб-страницы, а браузеры отображают данные для посетителей сайта.

10. Master Python

Python — это язык программирования, который можно использовать для автоматизации широкого круга задач SEO, таких как сканирование, анализ данных, обработка естественного языка (NLP) и многое другое.

Одна из замечательных особенностей Python заключается в том, что может не быть необходимости кодировать инструмент с нуля, потому что существует множество скриптов Python SEO, которые можно загрузить в Интернете.

Самое замечательное в Python то, что не нужно писать скрипты для всех необходимых SEO-задач. Многие из этих сценариев доступны в виде загружаемых библиотек Python, содержащих соответствующие модули.

Библиотека Python — это набор модулей. Модули Python — это сами файлы.

Согласно Рут Эверетт в ее Введении в Python, вот несколько полезных библиотек Python:

- «Панды: используется для обработки и анализа данных.

- NumPy: полезно для научных вычислений.

- SciPy: используется для научных и технических вычислений.

- SciKit Learn: машинное обучение для извлечения и анализа данных.

- SpaCy: отличная библиотека для обработки естественного языка.

- Requests: библиотека для создания HTTP-запросов.

- Beautiful Soup: используется для извлечения данных из файлов HTML и XML.

- Matplotlib: для создания визуализаций из данных».

Еще одной важной библиотекой Python является TensorFlow, бесплатная библиотека с открытым исходным кодом, которую можно использовать для создания приложений машинного обучения.

Примеры:

Примеры:

wikipedia.org/wiki/Inverted_index), чтобы сопоставить запрос с набором соответствующих документов

wikipedia.org/wiki/Inverted_index), чтобы сопоставить запрос с набором соответствующих документов wikipedia.org/wiki/Document_classification) и создание эффективный индекс поисковой системы (http://en.wikipedia.org/wiki/Index_(search_engine) )

wikipedia.org/wiki/Document_classification) и создание эффективный индекс поисковой системы (http://en.wikipedia.org/wiki/Index_(search_engine) ) д.) и используйте описательные имена файлов изображений. Если вы сомневаетесь, посмотрите на стандарты доступности (http://www.w3.org/standards/webdesign/accessibility) — там, где есть альтернативный текст для программ чтения с экрана, есть альтернативный текст для поисковых систем (и это означает аудиозаписи, йоу!) .

д.) и используйте описательные имена файлов изображений. Если вы сомневаетесь, посмотрите на стандарты доступности (http://www.w3.org/standards/webdesign/accessibility) — там, где есть альтернативный текст для программ чтения с экрана, есть альтернативный текст для поисковых систем (и это означает аудиозаписи, йоу!) . Он описывает ситуацию, когда игровой процесс зашел в тупик, и ни одна из сторон не может двигаться к победе. По сути, это состояние, которое считается ничьей.

Он описывает ситуацию, когда игровой процесс зашел в тупик, и ни одна из сторон не может двигаться к победе. По сути, это состояние, которое считается ничьей.

со своеобразным кодом.

со своеобразным кодом.