Содержание

Почему страницы сайта выпадают из индекса — Маркетинг на vc.ru

В этой статье специалист Mello затронет следующие вопросы:

3423

просмотров

- Как проверить индексацию страницы сайта в Яндексе и в Google

- С помощью каких сервисов можно проверить информацию об исключенных URL

- Причины выпадения страниц из индекса и что делать в такой ситуации

Одиночное выпадение страниц из индекса поисковых систем

Вебмастер может заметить, что трафик, присутствовавший на некогда популярной странице услуги, исчез, звонки прекратились, а продажи упали до нуля. В этом случае следует проверить – не выпала ли данная страница из индекса поисковых систем, особенно если единственным каналом продвижения этой услуги в интернете был органический поиск.

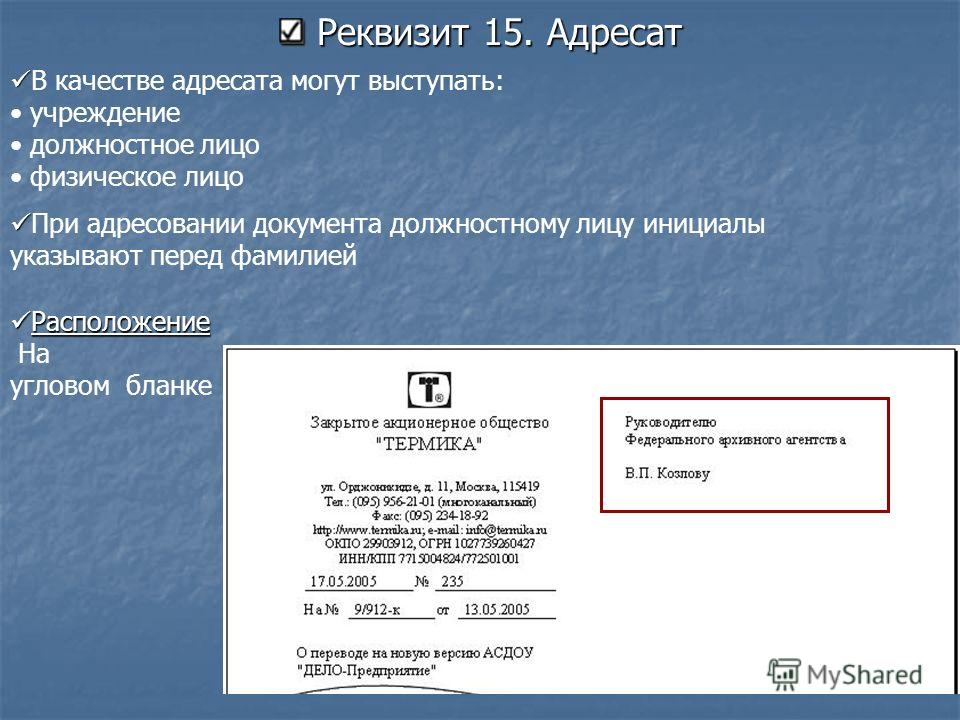

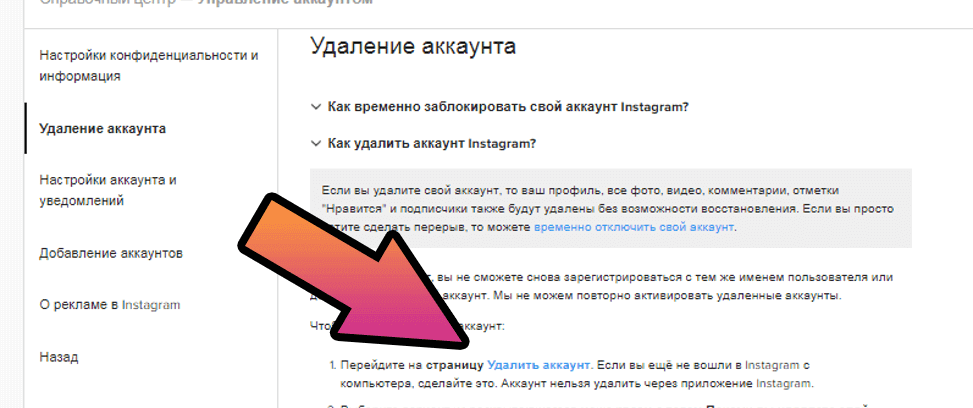

Как проверить не выпала ли страница из индекса Яндекса:

В Яндекс Вебмастере. Вкладка «Индексирование — Проверить статус URL». Вводим URL нужной страницы, нажимаем кнопку “Проверить” и ждём. Если в результате написано, что страница обходится роботом и находится в поиске, значит все хорошо:

Вводим URL нужной страницы, нажимаем кнопку “Проверить” и ждём. Если в результате написано, что страница обходится роботом и находится в поиске, значит все хорошо:

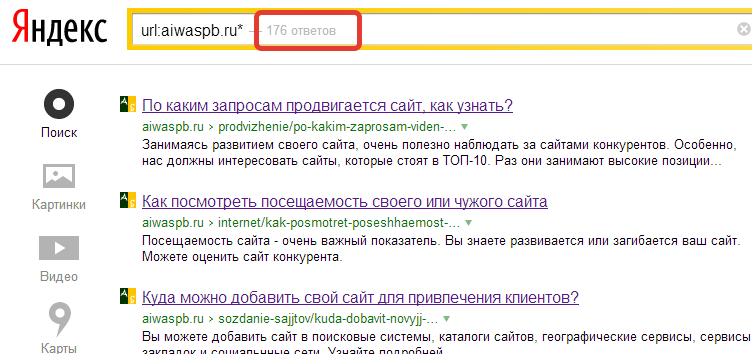

Через оператор url. В поисковой строке Яндекса вводим запрос по формуле [url:URL_документа]. Пример:

Если страница присутствует в индексе, Яндекс ее выведет.

Пример с отсутствующим в поиске URL:

Как проверить не выпала ли страница из индекса Google:

Проверить индексацию страницы в Гугле можно через сервис Google Search Console. Вставляем URL в строку проверки, нажимаем Enter:

Выводится информация о странице. В данном случае нас интересует информация о том, что URL присутствует в индексе Google.

Массовое выпадение страниц из индекса поисковых систем

Необходимо регулярно проверять свой сайт на количество исключенных из поиска страниц, так как целевые страницы могут выпасть из индекса в любой момент.

Как проверить информацию об исключенных страниц в Яндексе:

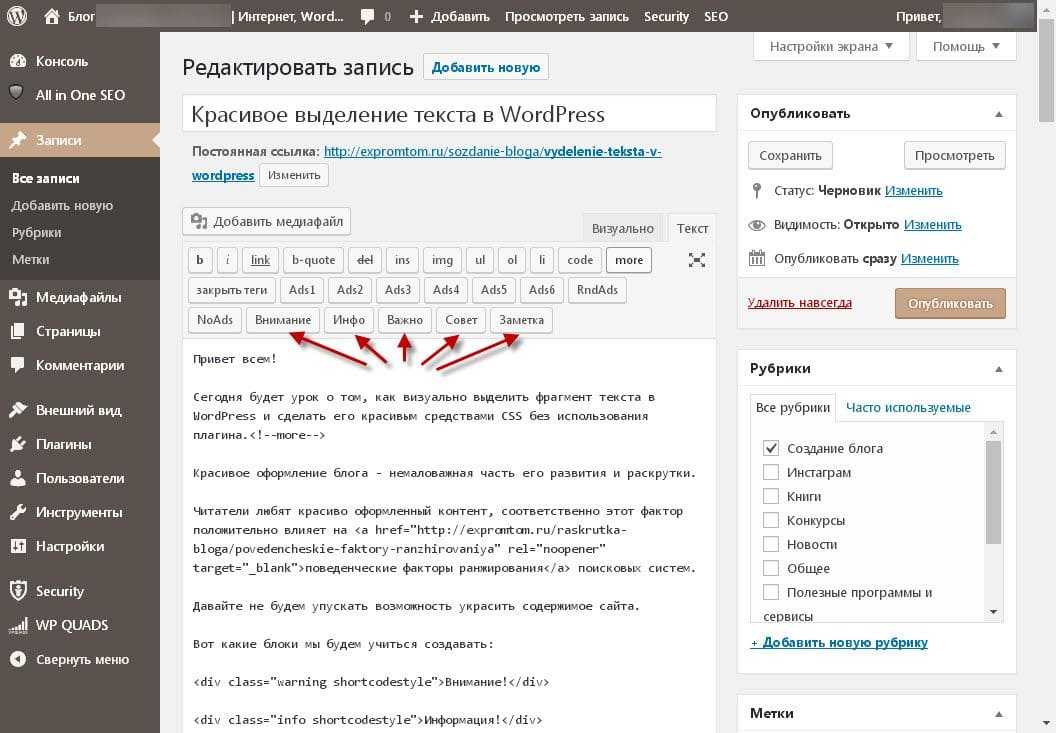

С помощью Вебмастера Яндекса можно узнать всю необходимую информацию об индексации страниц. Вкладка «Индексирование -> Страницы в поиске».

Вкладка «Индексирование -> Страницы в поиске».

Всегда проверяйте исключенные URL, особенно если видите, что раньше страниц в поиске было заметно больше. Здесь вы можете увидеть информацию о дате и причине исключения URL из индекса.

Как проверить информацию об исключенных страницах в Google:

В Google Search Console также можно посмотреть информацию об исключенных URL. Для этого перейдем во вкладку «Покрытие»:

Здесь нам показывают:

- Страницы с ошибками – Google не смог их проиндексировать

- Без ошибок, есть проблемы — проиндексированные страницы, но, возможно, имеющие ошибку с нашей стороны (например запрещены нужные нам URL в файле robots.txt)

- Без ошибок

- Исключенные

По каким причинам страницы выпадают из индекса

Причин, по которым страницы могут исключить из индекса, целое множество. Мы разделим их на две группы: технические причины и причины, зависящие от контента.

Технические причины

Редиректы

Поисковые системы исключают из индекса страницы, которые перенаправляют пользователя на другие страницы. При этом сама конечная страница (на которую идет перенаправление) зачастую не исключается (если нет другой причины).

Типичный пример исключения страницы, перенаправляющей пользователя на другую страницу (301 редирект):

Конечная страница осталась в поиске:

Так как конечная страница остается в поиске, то ничего страшного в данной ситуации нет, но желательно минимизировать кол-во ненужных 301 редиректов на сайте, если есть такая возможность.

404

Страницы с 404 ошибками также выпадают из индекса:

Если страница удалена по ошибке, то конечно необходимо ее восстановить. Если страница больше не нужна, то нужно удалить все ссылки на сайте, ведущие на нее.

Файл Robots.txt и мета-тег Robots

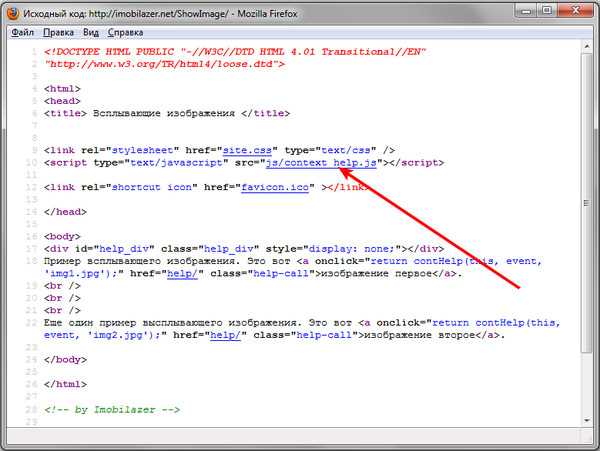

Вебмастер может рекомендовать поисковым системам не включать в индекс нужные ему URL с помощью файла robots. txt или с помощью мета-тега Robots:

txt или с помощью мета-тега Robots:

Проверьте файл robots.txt, нет ли там нужных вам страниц. Также проверьте мета-тег Robots. Если вы видите, что у атрибута “name” задано значение “robots”, а у атрибута “content” присутствует значение “noindex”, это означает, что сканирование страницы запрещено для всех поисковых роботов:

Более подробно про данный мета-тег можете почитать в справке Google.

Страница обнаружена, но не проиндексирована

В Google Search Console есть исключенные из индекса URL со статусом «Страница просканирована, но пока не проиндексирована»:

Это означает, что поисковый робот нашел вашу страницу, но не добавил ее в индекс. В данном случае нужно просто подождать и страница будет добавлена в поиск.

Причины, зависящие от контента

Дубли

Страницы полностью или частично дублирующие другие могут быть исключены из поиска.

Если страницы-дубли не нужны, то лучшим решением будет их удалить. Если нужны, то можно установить тег “rel=canonical” в этих страниц.

Если нужны, то можно установить тег “rel=canonical” в этих страниц.

Например:

Также можно настроить 301 редирект со страницы-дубля на каноническую страницу.

Если обе похожие друг на друга страницы должны присутствовать не только на сайте, но и в поиске (например, две страницы карточек товара), то их нужно сделать уникальными (изменить мета-теги, текст на странице, фото и т.д.).

Недостаточно качественные страницы

Сюда относятся страницы, несоответствующие запросу и неcпособные удовлетворить потребности пользователя.

Необходимо сделать страницу более качественной. Если это страница блога, то сделать уникальный и полезный читателю контент. Если это страница карточки товара в интернет-магазине, то товар должен быть в наличии (или должна присутствовать возможность заказать со склада), содержать описание, краткие характеристики товара и т.д.

Переоптимизированный контент

Тексты, сделанные для поисковиков, а не для людей. Их отличает большое количество вхождений ключевых слов. В случае, если у вас на сайте много переоптимизированного контента, поисковики могут наложить фильтр на сайт и целое множество страниц выпадет из индекса.

Их отличает большое количество вхождений ключевых слов. В случае, если у вас на сайте много переоптимизированного контента, поисковики могут наложить фильтр на сайт и целое множество страниц выпадет из индекса.

Как написано выше — делайте контент в первую очередь для пользователей. И не забывайте про фактор переоптимизации.

Накрутка поведенческих факторов

Поисковые системы накладывают санкции за использование различных методов так называемого «черного» SEO. Одним из таких методов и является попытка накрутить поведенческие факторы искусственным путем.

Не стоит использовать в своей работе сомнительные сервисы и программы по накрутке поведенческих факторов.

Неестественный ссылочный профиль

Если на сайте расположено множество покупных ссылок, а естественных ссылок очень мало, на него может наложиться фильтр поисковых систем (Минусинск у Яндекса и Пингвин у Гугла).

Аффилированность

Если два сайта одной компании борются за место в выдаче, то поисковые системы показывают страницу только одного сайта (как правило показывается наиболее подходящий запросу).

Как проверить находится ли сайт под фильтром

В Яндексе

Зайдите в раздел «Диагностика -> Безопасность и нарушения» в Яндекс Вебмастере:

Если ваш сайт получил фильтр, то информация об этом отобразится в данном разделе.

В Google

В Google Search Console это можно проверить в разделах «Меры принятые вручную» и «Проблемы безопасности»:

Вывод

Если вы попали ситуацию с кучей выпавших из индекса URL, проанализируйте:

- Заказывали ли вы ссылки, какие и сколько

- Все ли тексты на вашем сайте качественные и уникальные

- Удобен ли ваш сайт для пользователя, нет ли там излишней рекламы

- Какие страницы запрещены с помощью файла Robots.txt и мета-тега robots

- Присутствуют ли на сайте страницы-дубли

и исходя из итогов анализа устраните причину.

Если же вам не удалось установить причину исключения URL из индекса, или вы устранили все возможные ошибки, а страницы так и не попали в поиск, попробуйте обратиться в техподдержку поисковой системы.

Автор: специалист SEO- отдела в Mello, Павел Шевченко.

Почему не индексируется сайт? Причины по которым Google не индексирует ваш сайт

4250

| SEO | – Читать 19 минут |

Прочитать позже

Анастасия Сотула

Редактор блога Serpstat

Если вы занимаетесь продвижением бизнеса в интернете, первое, что нужно отслеживать — индексацию страниц сайта. Здесь возникает несколько вопросов: «Зачем нужна эта индексация сайта?» (спойлер: чтобы у пользователей была возможность найти ваш сайт в поисковой выдаче), «Где проверить сайт на индексацию» и «Что делать, если сайт не индексируется?». Ответы на них мы и разберем в данной статье.

Содержание

Как проверить индексацию сайта

Google пока не нашел ваш сайт

— Как добавить сайт в Гугл вебмастер (Google Search Console)?

Сайт или страницы закрыты в robots.txt

Включены приватные настройки

Сайт закрыт от индексации в noindex в метатегах

Ошибки сканирования

Сайт заблокирован в . htaccess

htaccess

Хостинг или сервер работает нестабильно

Проблемы с AJAX/JavaScript

У вас на сайте много дублированного контента

Очень медленная скорость загрузки сайта

Ваш домен ранее был забанен

У вас нет sitemap на сайте

FAQ

Выводы

Как проверить индексацию сайта

Перед тем, как поднять сайт в поисковиках, нужно оценить его видимость в популярных поисковых системах. Узнать видимость сайта можно с помощью специализированных ресурсов, например, Serpstat.

Чтобы узнать, насколько ваш сайт «виден» поисковикам, достаточно ввести адрес домена в поисковую строку и нажать «Поиск». Данный показатель относительный и его нужно смотреть в сравнении с основными конкурентами.

Проверка видимости сайта в Serpstat

Если показатель видимости низкий, необходимо проверить индексацию вашего веб-ресурса и добавить информацию про него в базу данных поисковиков.

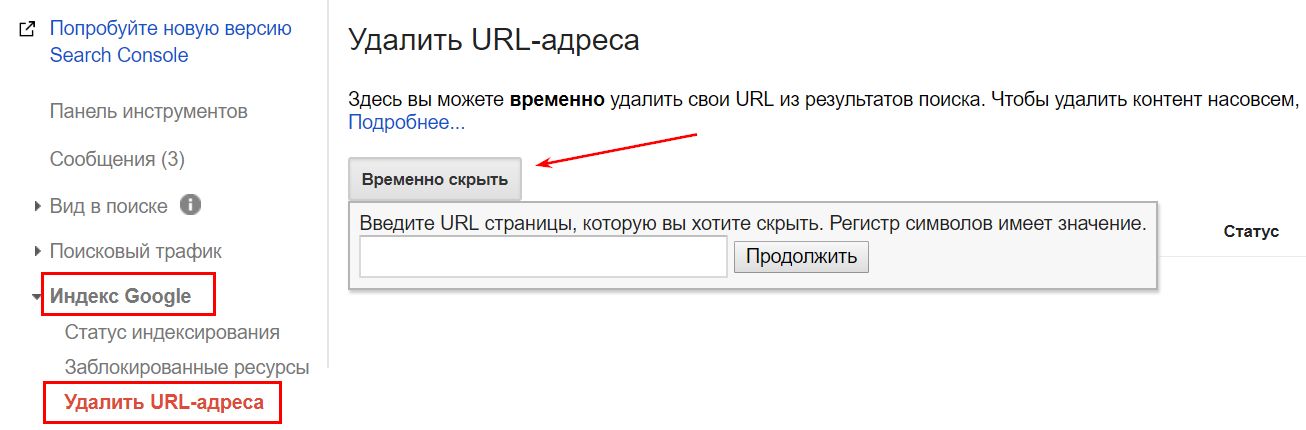

Самый простой способ узнать, индексируется ли ваш сайт, – воспользоваться панелью вебмастера. Для этого нужно иметь к ней доступ (почта в Google, регистрация-идентификация). Если доступ получен, то заходим в Панель, находим меню Search Console, достаем вкладку Индекс Google. В ней выбираем и смотрим Статус индексирования.

Статус индексации сайта в Search Console

Индексация сайта – это работа бота поисковой системы. Бот бесконечно сканирует тексты, изображения, видео, а потом добавляет информацию про веб-страницу или веб-ресурс в базу поисковой системы. Благодаря этой работе по накоплению базы пользователь получает релевантный ответ на свой запрос. Благодаря собранной ботом информации происходит ранжирование сайтов в конкретной поисковой системе.

А теперь подробнее разберемся в причинах того, почему поисковые системы могут не индексировать ваш сайт.

Google пока не нашел ваш сайт

Иногда Google просто «не видит» ваш сайт. Особенно это характерно для молодых площадок. Дело в том, что молодые сайты попадают в так называемую Песочницу – эдакий отстойник для веб-ресурсов, пока поисковая система не разберется, что это за сайт – какой он, чем дышит и для кого он предназначен.

Особенно это характерно для молодых площадок. Дело в том, что молодые сайты попадают в так называемую Песочницу – эдакий отстойник для веб-ресурсов, пока поисковая система не разберется, что это за сайт – какой он, чем дышит и для кого он предназначен.

Если сайту больше 6 месяцев (максимальное время зависания в Песочнице), то его «видимость» могут сдерживать фильтры поисковых систем. Потому что им не нравится, если контент на сайте не уникальный (стыренный у других авторов), а его содержание выходит за рамки морали, пропагандирует насилие или не имеет подтвержденной экспертизы. Пример: на сайте про лечебные средства отсутствуют имена и биографии авторов, которые их рекомендуют.

Если сайт не молодой, и с контентом все в порядке, то в теории нужно дать поисковым системам время на индексирование сайта в Гугле – минимум 2 недели.

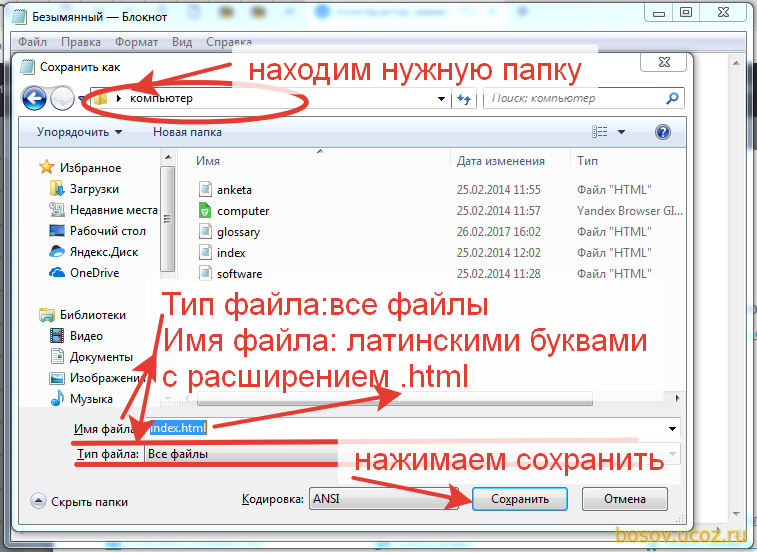

Правда, процесс можно ускорить, чтобы поисковики быстрее увидели сайт, его нужно вручную добавить в поисковую систему (Add url), а также в Google Search Console.

Запрос на индексирование url вручную

Как проиндексировать сайт в Гугл? Для этого нужно постоянно обновлять контент (в этом случае в преимущественном положении находятся сайты-новостники), создавать новые страницы (преимущество имеют блогеры и интернет-магазины с растущим ассортиментом), а также осуществлять внутреннюю перелинковку страниц в комплексе со ссылками с авторитетных внешних ресурсов.

Как добавить сайт в Гугл вебмастер (Google Search Console)?

Правда, есть еще возможность проиндексировать сайт в Google быстро. Для этого выполняем 5 элементарных операций:

- Открываем Google Search Console – раз!

- Переходим в Инструмент проверки URL – два.

- Вставляем в строку поиска URL, который нужно сделать видимым в индексе Google – три.

- Ожидаем, пока Google проверяет адрес – четыре.

- Нажимаем кнопку «Запросить индексирование» – пять!

Мы подготовили для вас самую подробную инструкцию, как добавить сайт в Google Search Console.

Сайт или страницы закрыты в robots.txt

Файл robots.txt — запретный инструмент Гугла. В нем содержатся инструкции для поисковых роботов: какие страницы они могут обрабатывать на вашем сайте. С помощью файла robots.txt можно искусственно ограничить количество запросов на сканирование. Это поможет снизить нагрузку на сервер. Актуально для неважной или повторяющейся информации. Для этого на веб-страницу сайта, которую нужно убрать из поля видимости Гугла, нужно добавить директиву noindex.

Важно! Даже если запретить индексацию в robot txt для какой-то веб-страницы, то она все равно может быть проиндексирована роботом Googlebot, при условии, что на нее есть ссылки с других сайтов. Это относится только к контенту в формате HTML. А вот заблокированные файлы PDF, изображения или видео будут надежно спрятаны от Google. Чтобы гарантированно исключить индексацию страницы с контентом в формате HTML в Гугле, нужно использовать директиву noindex в мета теге или HTTP-заголовке ответа.

А теперь, внимание, рассказываем, как задать в robots.txt директивы для роботов Google. Чтобы индексировать сайт в Гугл, необходимо в файле robots.txt позволить агентам роботов Googlebot, AdsBot-Google, Googlebot-Image позволить сканировать веб-ресурс. Для этого нужно добавить в файл robots.txt следующие строки:

- User-agent: Googlebot

Disallow:

- User-agent: AdsBot-Google

Disallow:

- User-agent: Googlebot-Image

Disallow:

Включены приватные настройки

Иногда сайт не индексируется Гуглом по самой банальной причине – в CMS включены приватные настройки. CMS – это движок сайта, например WordPress, Joomla, OpenCart. CMS — это набор скриптов, которые позволяют создавать, редактировать и управлять контентом на website.Чтобы индексация страницы состоялась, нужно проверить настройки страницы в конкретной CMS.

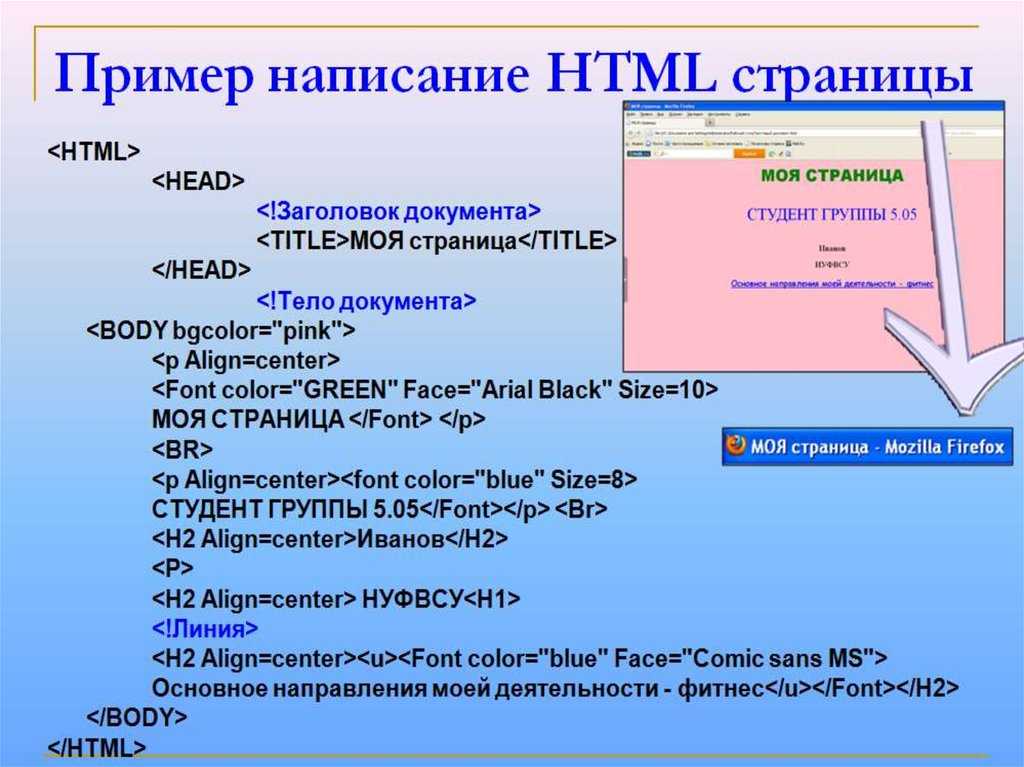

Сайт закрыт от индексации в noindex в метатегах

Мета-теги (HTML) нужны для того, чтобы структурировать содержимое веб-страницы. Как правило, мета-теги указываются в заголовке HTML-документа. Обязательным является атрибут content, а уже к нему добавляются остальные.

Появление meta noindex nofollow означает, что интернет-боты не должны трогать (индексировать) эту страницу. Причина запрета может быть в том, что страница имеет временное содержимое, быть версией для печати или содержать приватную информацию. Детальную инструкцию, какие страницы нужно закрыть от индексации, смотрите на нашем сайте.

Вот как meta noindex выглядит в HTML-документе, блокируя этим бота Google:

<meta name="googlebot" content="noindex">

Чтобы заблокировать видимость веб-страницы в глазах бота MSN’s bot, пишем «волшебные слова»:

<meta name="msnbot" content="noindex">

Чтобы отключить индексацию целой страницы убираем слово «noindex» из кода.

Наличие метатега robots в коде страницы в сочетании со словом noindex показывает поисковым роботам запрет на индексирование сайта в Гугл.

Выглядит robots txt noindex в HTML-документе вот так:

<meta name="robots" content="noindex">

Где искать информацию про robots noindex? Заходим в Google Search Console. Открываем отчет «Индекс», выбираем «Покрытие», переходим во вкладку «Исключено». Если там написано, что индексирование страницы запрещено тегом rel noindex, то становится понятным, почему веб-ресурс закрыт от индексации. Ах, да, и не забудьте снять запрет, если ищете способ, как как проиндексировать страницу в Гугл.

Ошибки сканирования

Ошибки сканирования также останавливают индексацию в Гугл, ранжирование сайта в выдаче, а также отношение посетителей к веб-ресурсу. Эксперты выделяют три группы причин ошибок сканирования:

- Ошибки в настройках сервера (серверов).

- Сбои CMS (система управления контентом).

- Изменение структуры URL.

Ошибки сканирования можно найти в инструментах Google Search Console. Для этого потребуется зайти в статистику сканирования web-ресурса. Если вы вычислили «свою» ошибку, то рядом должно быть объяснение для вебмастера – причина ее появления и способы ликвидации. Но, мы тоже подготовили для вас текст, как устранить ошибки сканирования. Пользуйтесь!

Важно! Информация в Search Console попадает с небольшой оттяжкой во времени. Поэтому ошибки могут быть уже устранены, а в консоли по-прежнему будет отображаться их наличие.

Сайт заблокирован в .htaccess

Сайт может быть заблокирован в .htaccess. Это делается для того, чтобы лишить случайных посетителей доступа к какому-то файлу, папке, админ-панели сайта. Пароль на эти структурные элементы владелец ставить не хочет, но и непрошенных гостей здесь не ждет. Для этого в папке с инкогнито нужно создать 1 файл с именем htaccess.

В коде запрет доступа по IP адресу к файлу file.php выглядит вот так:

<Files file.php> Order Deny,Allow Deny from all Allow from Ваш IP адрес </Files>

После этого все обращения к указанному файлу с чужого IP будет давать ответ 403 «Access denied». Если владелец ресурса хочет ограничить доступ ко всем файлам с одним расширением, то первую строчку делают вот такой <Files «*.conf»>. Если расширений несколько, то они пишутся через разделитель <Files ~ «\.(inc|conf|cfg)$»>.

Чтобы проверить, находим на сервере файл .htaccess. Высматриваем в коде, не были ли когда-то закрыт сайт или его часть. Редко кто думает в этом направлении, но этот вариант обязательно нужно проверить, когда ищешь причины, почему сайт закрыт от поисковика.

Хостинг или сервер работает нестабильно

Если хостинг или сервер работают с перебоями, то это может стать причиной того, что индексация не состоялась. Представьте себе ситуацию: поисковый бот пришел на сайт (заглянул в гости) проиндексировать страницы, а там никого нет. Поэтому задача владельца ресурса — озаботиться тем, чтобы сервер был качественным, а хостинг — стабильным.

Представьте себе ситуацию: поисковый бот пришел на сайт (заглянул в гости) проиндексировать страницы, а там никого нет. Поэтому задача владельца ресурса — озаботиться тем, чтобы сервер был качественным, а хостинг — стабильным.

Контроль за состоянием доступа к сайту ведем с помощью множества сервисов. Подбираем их в поисковиках по запросу uptime checker – получаем множество вариантов сервисов, которые позволяют отследить стабильность работы хостинга. А также читаем нашу статью, как выбрать надежный хостинг для сайта, если услуга доказано некачественная.

Проблемы с AJAX/JavaScript

Google также индексирует AJAX и JavaScript, но делает это не так просто, как HTML. Поэтому разработчик должен вручную настроить все для поиска AJAX и JavaScript, чтобы «насильственно» заставить Гугл проиндексировать сайт и нужные вам страницы. Если интересно, то вот мнение экспертов про то, как устранить проблемы с видимостью сайтов на JavaScript-движках.

У вас на сайте много дублированного контента

Дублированный контент в 2021-2022 году после появления фильтров и, особенно, Панды, может стать одной из ключевых причин, почему на сайт накладывают санкции, а задача, как поднять сайт в поисковике, начинает «выедать» время и финансы. Правда, господа-сеошники уже давно разработали несколько действенных технологий, как избежать фильтров поисковиков за контент сайта без ущерба для этой самой оптимизации.

Правда, господа-сеошники уже давно разработали несколько действенных технологий, как избежать фильтров поисковиков за контент сайта без ущерба для этой самой оптимизации.

Дублированный контент может быть в страницах, а может и в метатегах. Чтобы исключить дублированный контент, нужно сначала отыскать все дубликаты страниц на сайте, а потом удалить их или закрыть от индексации. Читайте, нашу статью про то, как найти и удалить дубли страниц на сайте, чтобы зря не злить поисковых роботов.

Очень медленная скорость загрузки сайта

Скорость загрузки сайта является одним из факторов ранжирования и попадания в первую десятку топ-выдачи. В это понятие входит запрос к стороннему серверу, его ответ, загрузка скриптов/стилей/изображений, а также компиляция страницы – ее отрисовка на стороне пользователя. Доказано, что большинство пользователей говорит сайту «досвидос», если нужная им страница грузится больше, чем 3 секунды.

Поэтому скорость загрузки сайта прямо влияет на конверсию, снижает количество отказов, увеличивает глубину просмотра страниц, поэтому косвенно дает рост среднего чека и выручки. В общем, если сайт грузится долго, а страницы открываются удручающе медленно, то и индексироваться поисковиками он нормально тоже не будет.

В общем, если сайт грузится долго, а страницы открываются удручающе медленно, то и индексироваться поисковиками он нормально тоже не будет.

Чтобы уменьшить размер страниц на сайте, нужно сократить объем графики, убрать лишние изображения, сократить объем загружаемых страницы путем сжатия gzip, кэшировать данные, сократить размер кода CSS и JavaScript.

Одновременно с этим можно озаботиться тем, как увеличить скорость загрузки сайта. Для этого проводятся исследования скорости загрузки страниц. Потом находятся слабые места и устраняются поштучно. Считается, что ускорение загрузки страниц сайта даже на 0,5 секунд дает отличные результаты в 80% случаев.

На всякий случай ловите 8 основных способов, как ускорить загрузку сайта, с примерами и картинками. А также абсолютно уникальный мануал про то, как ускорить загрузку верхней части страницы сайта – header.

Ваш домен ранее был забанен

Иногда вебмастер делает хороший сайт, регистрирует для него хороший и звучный домен, заказывает отличный дизайн, наполняет его уникальным, экспертным контентом, проводит перелинковку, выстраивает систему обратных ссылок, а поисковые системы не видят этот веб-ресурс принципиально. Как сделать чтобы сайт отображался в поисковике? Причина нелюбви Гугла может быть в домене, который ранее был забанен.

Как сделать чтобы сайт отображался в поисковике? Причина нелюбви Гугла может быть в домене, который ранее был забанен.

Чтобы решить эту задачу нужно:

- Продолжать развивать проект.

- Написать в Google, на форум, чтобы выяснить причину блокировки, а потом ее устранять.

- Развивать проект на другом домене, чтобы сэкономить время и деньги.

У вас нет sitemap на сайте

Одной из возможных причин того, что вам потребуется проверка факта индексации сайта, может быть отсутствие на нем sitemap (список веб-страниц в пределах домена). Поисковые боты, которые заходят на сайт, рандомно индексируют несколько страниц, а потом, удовлетворенные этим, уходят. Поэтому сайтмап нужно сделать. Вот одна из лучших инструкций, как создать и настроить карту сайта (sitemap.xml) для Google, а уже потом добавить ее в Google Search Console.

Полезно! Если хотите, то ту же инструкцию, как создать XML карту сайта, можно посмотреть для видео.

Это отдельный, масштабный, как пирамида Хеопса и Великая Китайская стена взятые вместе, кусок работы по созданию карты сайта для новостей или другого динамического информационного контента. Для блока новостей делают собственную XML карту сайта, потом отправляют запрос в Новости Google и добавляют ее в news.google.com, чтобы поисковые роботы находили и индексировали такой контент еще быстрее.

Кроме того, собственная карта сайта – Image sitemap XML создается для изображений. Она нужна, чтобы обеспечить быстрое, правильное, естественное индексирование картинок. Ловите детальный мануал, как создать XML карту сайта для изображений.

Хотите узнать, как с помощью Serpstat оптимизировать сайт?

Нажимайте на космонавта и заказывайте бесплатную персональную демонстрацию сервиса! Наши специалисты вам все расскажут! 😉

Почему сайт не индексируется в Гугле?

Первейшая причина – поисковая система Гугл просто «не видит» ваш сайт. Ей нужно помочь – вручную проиндексировать сайт. Кроме того, возможны ошибки сканирования поисковыми роботами, неприятие Гуглом языков AJAX/JavaScript, наличие на сайте дублированного контента или забаненный ранее домен.

Ей нужно помочь – вручную проиндексировать сайт. Кроме того, возможны ошибки сканирования поисковыми роботами, неприятие Гуглом языков AJAX/JavaScript, наличие на сайте дублированного контента или забаненный ранее домен.

Почему не индексируются страницы сайта?

Одна из самых распространенных причин — страницы сайта закрыты в robots.txt.

Как часто Гугл индексирует сайт?

Google проводит индексацию постоянно – поисковые роботы загружают страницы сайта, а потом выкладывают их в обновленный индекс.

Выводы

Индексация сайта — один из первейших моментов в деле поискового продвижения сайта. Если сайт поисковики не видят, то ищем причину, а потом ее устраняем. В идеале, лучше не допускать проблем с индексацией сайта вообще.

Финальный чек-лист, почему сайт не индексируется в Гугле?

- Google пока не нашел ваш сайт.

Ждем, пока увидят, или вручную ускоряем процесс индексации.

Ждем, пока увидят, или вручную ускоряем процесс индексации. - Сайт или страницы закрыты в robots.txt. Открываем.

- Включены приватные настройки в CMS. Открываем.

- Сайт закрыт от индексации в noindex в метатегах. Убираем noindex из метатегов.

- Ошибки сканирования. Ищем одну из трех известных ошибок сканирования: ошибки в настройках сервера, сбои CMS, изменение структуры URL. Устраняем.

- Сайт заблокирован в .htaccess — проверяем файл .htaccess., удаляем из него страницы и папки, которые нуждаются в индексации.

- Хостинг или сервер работает нестабильно — отслеживаем проблему, меняем хостинг.

- Проблемы с AJAX/JavaScript – вручную настраиваем все для поиска AJAX и JavaScript и уговариваем Гугл проиндексировать сайт (страницы).

- У вас на сайте много дублированного контента, находим и удаляем дубли.

- Очень медленная скорость загрузки сайта, облегчаем (сжимаем) контент.

- Ваш домен ранее был забанен – пишем запрос на апелляцию или развиваем ресурс на другом, чистом, домене.

- Сайт лишен sitemap – нужно сделать и добавить сайтмап в Search Console.

Чтобы быть в курсе всех новостей блога Serpstat, подписывайтесь рассылку. А также вступайте в чат любителей Серпстатить и подписывайтесь на наш канал в Telegram.

Мнение авторов гостевого поста может не совпадать с позицией редакции и специалистов компании Serpstat.

Оцените статью по 5-бальной шкале

5 из 5 на основе 3 оценок

Нашли ошибку? Выделите её и нажмите Ctrl + Enter, чтобы сообщить нам.

Рекомендуемые статьи

SEO

Анастасия Сотула

Как оптимизировать плотность ключевых слов

SEO

Инна Arsa

Голосовой поиск: как получать больше трафика из мобильной выдачи

SEO +1

Анастасия Сотула

Топ-20 SEO-мифов и заблуждений

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.

Поделитесь статьей с вашими друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылок.

Сообщить об ошибке

Отменить

14 главных причин, почему Google не индексирует ваш сайт

Google не будет индексировать ваш сайт? Ты не один. Существует множество потенциальных проблем, которые могут помешать Google индексировать веб-страницы, и в этой статье рассматриваются 14 из них.

Если вы хотите знать, что делать, если ваш сайт не оптимизирован для мобильных устройств или вы столкнулись со сложными проблемами индексации, у нас есть информация, которая вам нужна.

Узнайте, как устранить эти распространенные проблемы, чтобы Google снова начал индексировать ваши страницы.

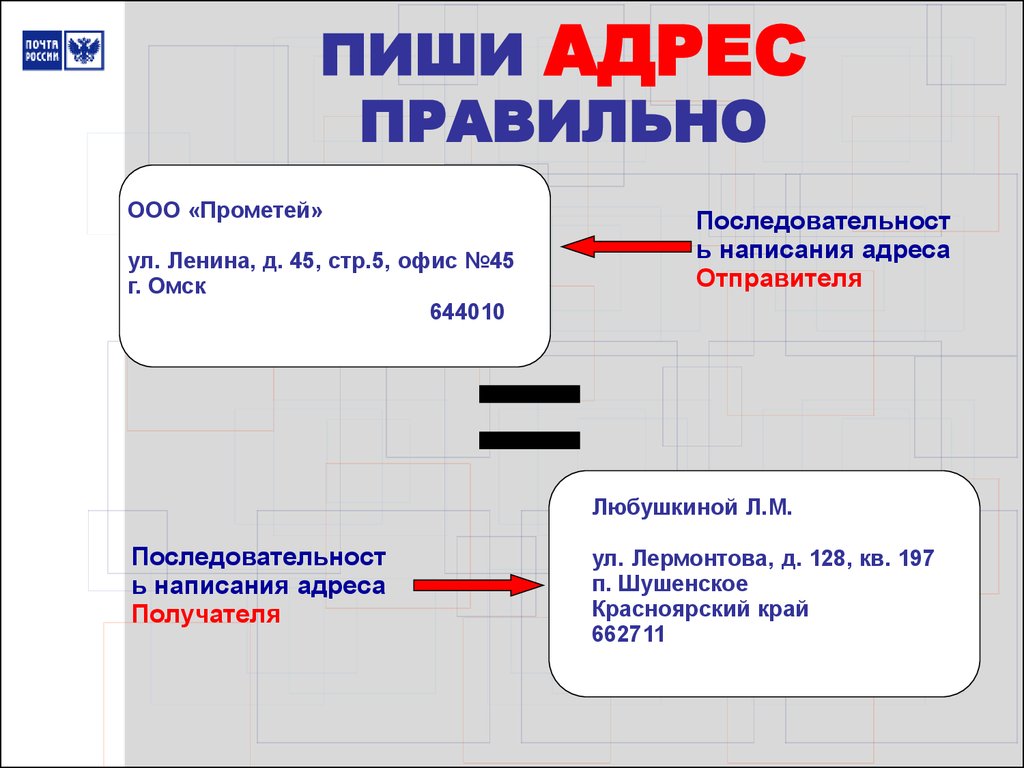

1. У вас нет доменного имени

Первая причина, по которой Google не будет индексировать ваш сайт, заключается в том, что у вас нет доменного имени. Это может быть связано с тем, что вы используете неправильный URL-адрес для контента или он неправильно настроен в WordPress.

Это может быть связано с тем, что вы используете неправильный URL-адрес для контента или он неправильно настроен в WordPress.

Если это происходит с вами, есть несколько простых решений.

Проверьте, не начинается ли ваш веб-адрес с «https://XXX.XXX…», что означает, что кто-то может вводить IP-адрес вместо имени домена и перенаправляться на ваш веб-сайт.

Кроме того, возможно, неправильно настроено перенаправление вашего IP-адреса.

Один из способов решить эту проблему — добавить переадресацию 301 с WWW-версий страниц обратно на соответствующие домены. Если люди перенаправляются сюда, когда пытаются найти что-то вроде [yoursitehere], мы хотим, чтобы они попали на ваше физическое доменное имя.

Важно убедиться, что у вас есть доменное имя. Это не подлежит обсуждению, если вы хотите занимать высокие позиции и быть конкурентоспособными в Google.

2. Ваш сайт не оптимизирован для мобильных устройств

Веб-сайт, адаптированный для мобильных устройств, имеет решающее значение для индексации вашего сайта Google, поскольку он ввел индексирование Mobile-First.

Независимо от того, насколько хорош контент на вашем веб-сайте, если он не оптимизирован для просмотра на смартфоне или планшете, вы потеряете рейтинг и трафик.

Оптимизация для мобильных устройств не должна быть сложной — простое добавление принципов адаптивного дизайна, таких как плавающие сетки и CSS Media Queries, может значительно помочь пользователям найти то, что им нужно, без каких-либо проблем с навигацией.

Первое, что я рекомендую сделать с этой проблемой, — запустить ваш сайт с помощью Google Mobile-Friendly Testing Tool.

Если вы не получили «пройдено чтение», вам нужно проделать некоторую работу, чтобы сделать ваш сайт удобным для мобильных устройств.

3. Вы используете язык кодирования слишком сложным для Google способом

Google не будет индексировать ваш сайт, если вы используете язык кодирования сложным образом. Неважно, какой язык — он может быть старым или даже обновленным, как JavaScript — если настройки неверны и вызывают проблемы со сканированием и индексированием.

Если это проблема для вас, я рекомендую запустить Google Mobile-Friendly Testing Tool, чтобы увидеть, насколько ваш сайт действительно удобен для мобильных устройств (и внести любые исправления, которые могут потребоваться).

Если ваш веб-сайт еще не соответствует их стандартам, они предлагают множество ресурсов с рекомендациями по всевозможным причудам дизайна, которые могут возникнуть при разработке адаптивной веб-страницы.

4. Ваш сайт загружается медленно

Сайты с медленной загрузкой снижают вероятность того, что Google захочет, чтобы они отображались в верхних результатах индекса. Если ваш сайт долго загружается, это может быть связано со многими различными факторами.

Возможно даже, что у вас слишком много контента на странице для браузера пользователя, или если вы используете старомодный сервер с ограниченными ресурсами.

Решения:

- Используйте Google Page Speed Insights . Это один из моих любимых инструментов, который я нашел за последние годы, и он помогает мне определить, какие разделы веб-сайта требуют срочного внимания при повышении его скорости.

Инструмент анализирует вашу веб-страницу в соответствии с пятью лучшими рекомендациями по производительности (которые имеют решающее значение для более быстрой загрузки сайтов), такими как минимизация подключений, уменьшение размера полезной нагрузки, использование кэширования браузера и т. д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт.

Инструмент анализирует вашу веб-страницу в соответствии с пятью лучшими рекомендациями по производительности (которые имеют решающее значение для более быстрой загрузки сайтов), такими как минимизация подключений, уменьшение размера полезной нагрузки, использование кэширования браузера и т. д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт. - Используйте такой инструмент, как webpagetest.org . Этот инструмент сообщит вам, загружается ли ваш сайт достаточно быстро. Это также позволит вам подробно увидеть конкретные элементы на вашем сайте, которые вызывают у вас проблемы. Их водопад может помочь вам определить серьезные проблемы со скоростью страницы до того, как они вызовут серьезные проблемы.

- Снова используйте аналитику Google Page Speed — Посмотрите, где можно улучшить время загрузки сайта. Например, возможно, стоит изучить новый план хостинга с большим количеством ресурсов (чистые выделенные серверы намного лучше, чем общие) или использовать службу CDN, которая будет обслуживать статический контент из своего кеша в нескольких местах по всему миру.

В идеале, убедитесь, что скорость вашей страницы достигает 70 или выше. В идеале как можно ближе к 100.

Если у вас есть какие-либо вопросы относительно скорости страницы, вы можете ознакомиться с электронной книгой SEJ о Core Web Vitals.

5. На вашем сайте минимум хорошо написанного контента

Хорошо написанный контент имеет решающее значение для успеха в Google. Если у вас есть минимальный контент, который, по крайней мере, не соответствует уровню ваших конкурентов, у вас могут быть серьезные проблемы даже с попаданием в топ-50.

По нашему опыту, контент, содержащий менее 1000 слов, не так эффективен, как контент, содержащий более 1000 слов.

Являемся ли мы компанией по написанию контента? Нет, мы не. Является ли количество слов фактором ранжирования? Также нет.

Но когда вы решаете, что делать в контексте конкурса, убедитесь, что ваш контент хорошо написан, это ключ к успеху.

Содержание вашего сайта должно быть качественным и информативным. Он должен отвечать на вопросы, предоставлять информацию или иметь точку зрения, которая достаточно отличается от других сайтов в той же нише, что и ваша.

Он должен отвечать на вопросы, предоставлять информацию или иметь точку зрения, которая достаточно отличается от других сайтов в той же нише, что и ваша.

Если он не соответствует этим стандартам, Google, скорее всего, найдет другой сайт с более качественным контентом, который им соответствует.

Если вам интересно, почему ваш веб-сайт не занимает высокие позиции в результатах поиска Google по некоторым ключевым словам, несмотря на то, что он следует рекомендациям SEO, таким как добавление релевантных ключевых слов по всему тексту (Подсказка: ваш контент), тогда одним из виновников могут быть тонкие страницы, где на странице действительно должно быть больше 100 слов!

Тонкие страницы могут вызвать проблемы с индексацией, поскольку они не содержат много уникального контента и не соответствуют минимальным уровням качества по сравнению с вашими конкурентами.

6. Ваш сайт не удобен для пользователя и не привлекателен для посетителей

Наличие удобного и привлекательного сайта имеет решающее значение для хорошего SEO. Google повысит рейтинг вашего сайта в результатах поиска, если посетителям будет легко находить то, что они ищут, и перемещаться по веб-сайту, не чувствуя разочарования или раздражения.

Google повысит рейтинг вашего сайта в результатах поиска, если посетителям будет легко находить то, что они ищут, и перемещаться по веб-сайту, не чувствуя разочарования или раздражения.

Google не хочет, чтобы пользователи проводили слишком много времени на странице, которая либо долго загружается, либо имеет запутанную навигацию, либо просто неудобна в использовании, потому что слишком много отвлекающих факторов (например, реклама в верхней части страницы).

Если в каждой категории указан только один продукт вместо нескольких, возможно, именно поэтому ваш контент плохо ранжируется в Google! Важно не только настроить таргетинг на ключевые слова в каждом сообщении, но и убедиться, что все связанные сообщения ссылаются на другие соответствующие статьи/страницы по теме.

Нравится ли людям делиться вашим блогом? Читатели поражены вашим контентом? Если нет, то это может быть причиной того, что Google перестал индексировать ваш сайт.

Если кто-то ссылается непосредственно на одну конкретную страницу продукта, а не использует относительные ключевые слова, такие как «купить», «купить» и т. д., возможно, что-то не так с тем, как другие страницы ссылаются на этот конкретный продукт.

д., возможно, что-то не так с тем, как другие страницы ссылаются на этот конкретный продукт.

Убедитесь, что все продукты, перечисленные на страницах категорий, также существуют в каждой соответствующей подкатегории, чтобы пользователи могли легко совершать покупки без необходимости перемещаться по сложной иерархии ссылок.

7. У вас есть цикл перенаправления

Циклы перенаправления — еще одна распространенная проблема, препятствующая индексации. Обычно они вызваны распространенной опечаткой и могут быть исправлены с помощью следующих шагов:

Найдите страницу, вызывающую цикл перенаправления. Если вы используете WordPress, найдите исходный HTML-код одного из ваших сообщений на этой странице или в файле .htaccess и найдите «Перенаправление 301», чтобы увидеть, с какой страницы он пытается направить трафик. Также стоит исправить все перенаправления 302 и убедиться, что они установлены на 301.

Используйте «найти» в проводнике Windows (или Command + F, если Mac) для поиска во всех файлах, содержащих «перенаправление», пока не обнаружите, в чем проблема.

Исправьте любые опечатки, чтобы дублирующийся URL-адрес не указывал на себя, а затем используйте код перенаправления, как показано ниже:

Коды состояния, такие как 404, не всегда отображаются в Google Search Console. Используя внешний сканер, такой как Screaming Frog, вы можете найти коды состояния для 404 и других ошибок.

Если все выглядит хорошо, используйте Google Search Console на месте, чтобы снова просканировать сайт и повторно отправить его на индексацию. Подождите неделю или около того, прежде чем снова зайти в Google Search Console, если появятся какие-либо новые предупреждения, требующие внимания.

У Google нет времени обновлять свои индексы каждый день, но они делают это каждые несколько часов, что означает, что иногда ваш контент может отображаться не сразу, даже если вы знаете, что он был обновлен. Потерпи! Вскоре он должен быть проиндексирован.

8. Вы используете плагины, которые блокируют сканирование вашего сайта роботом Googlebot

Одним из примеров такого плагина является плагин robots. txt. Если с помощью этого плагина вы установите для файла robots.txt запрет на индексирование своего сайта, робот Googlebot не сможет его просканировать.

txt. Если с помощью этого плагина вы установите для файла robots.txt запрет на индексирование своего сайта, робот Googlebot не сможет его просканировать.

Настройте файл robots.txt и выполните следующие действия:

При создании сделайте его общедоступным, чтобы поисковые роботы могли получить к нему доступ без ограничений.

Убедитесь, что в файле robots.txt нет следующих строк:

User-agent: * Disallow: /

Слэш означает, что файл robots.txt блокирует все страницы из корневой папки сайта. Вы хотите убедиться, что ваш файл robots.txt выглядит примерно так:

User-agent: * Запретить:

Если строка запрета пуста, это означает, что поисковые роботы могут сканировать и индексировать каждую страницу вашего сайта без ограничений (при условии, что у вас нет определенных страниц, помеченных как не индексируемые).

9. Ваш сайт использует JavaScript для Render Content

Использование JavaScript само по себе не всегда является сложной проблемой, которая вызывает проблемы с индексацией. Не существует единого правила, которое говорит, что JS — это единственное, что вызывает проблемы. Вы должны смотреть на отдельный сайт и диагностировать проблемы, чтобы определить если это проблема

Не существует единого правила, которое говорит, что JS — это единственное, что вызывает проблемы. Вы должны смотреть на отдельный сайт и диагностировать проблемы, чтобы определить если это проблема

Когда JS вступает в игру как проблема, это когда JS предотвращает сканирование, выполняя сомнительные действия — методы, которые могут быть похожи на маскировку.

Если вы создали обработанный HTML, а не необработанный HTML, и у вас есть ссылка в необработанном HTML, которой нет в обработанном HTML, Google не может сканировать или индексировать эту ссылку. Определение проблем отображаемого HTML и необработанного HTML имеет решающее значение из-за ошибок такого типа.

Если вы хотите скрыть файлы JS и CSS, не делайте этого. Google упомянул, что хочет видеть все ваши файлы JS и CSS при сканировании.

Google хочет, чтобы вы сохранили возможность сканирования всех JS и CSS. Если какие-либо из этих файлов у вас заблокированы, вы можете разблокировать их и разрешить полное сканирование, чтобы предоставить Google нужное представление о вашем сайте.

10. Вы не добавили все свойства домена в Google Search Console

Если у вас более одного варианта домена, особенно в ситуации, когда вы мигрировали с http:// на https://, вы должны все варианты вашего домена добавлены и проверены в Google Search Console.

Важно убедиться, что вы не пропустили ни один из вариантов домена при их добавлении в GSC.

Добавьте их в GSC и убедитесь, что вы подтвердили право собственности на все свойства домена, чтобы убедиться, что вы отслеживаете правильные.

Для новых сайтов, которые только начинают свою работу, это, скорее всего, не будет проблемой.

11. Ваши метатеги установлены на Noindex, Nofollow

Иногда, по чистой случайности, метатеги установлены на noindex, nofollow. Например, на вашем сайте может быть ссылка или страница, которая была проиндексирована поисковым роботом Google, а затем удалена до перехода на noindex, nofollow был правильно настроен в серверной части вашего сайта.

В результате эта страница, возможно, не была повторно проиндексирована, и если вы используете плагин для блокировки Google от сканирования вашего сайта, эта страница может больше никогда не быть проиндексирована.

Решение простое: измените любые метатеги со словами noindex,nofollow, чтобы они читались как index, вместо этого следуйте.

Однако, если у вас есть тысячи подобных страниц, вам, возможно, предстоит тяжелая битва. Это один из тех моментов, когда вы должны стиснуть зубы и двигаться вперед с трудом.

В конце концов, производительность вашего сайта скажет вам спасибо.

12. Вы не используете карту сайта

Вам необходимо использовать карту сайта!

Карта сайта — это список всех страниц вашего сайта, а также один из способов для Google узнать, какой у вас контент. Этот инструмент поможет гарантировать, что каждая страница будет просканирована и проиндексирована консолью поиска Google.

Если у вас нет карты сайта, Google работает вслепую, если только все ваши страницы в настоящее время не проиндексированы и не получают трафик.

Однако важно отметить, что файлы Sitemap в формате HTML устарели в Google Search Console. В настоящее время предпочтительным форматом файлов Sitemap являются XML Sitemaps.

Вы хотите использовать свою карту сайта, чтобы сообщить Google, какие страницы вашего сайта являются важными, и вы хотите регулярно отправлять ее для сканирования и индексации.

13. Вы были наказаны Google в прошлом и до сих пор не исправили свои действия

Google неоднократно заявлял, что штрафы могут последовать за вами.

Если у вас уже был штраф и вы не исправили свой поступок, то Google не будет индексировать ваш сайт.

Ответ на этот вопрос довольно прост: если Google наказывает за это, они, возможно, ничего не смогут с этим поделать, потому что штрафы следуют за вами повсюду, как незваный друг, который волочит ноги по ковру, проходя через каждую комнату. твой дом.

Если вам интересно, зачем вам по-прежнему исключать некоторую информацию со своего веб-сайта, если у вас уже есть проблемы с поисковыми системами?

Дело в том, что несмотря на то, что есть способы избежать наказания, многие люди не знают, или уже не могут вносить эти изменения по каким-либо причинам (возможно, они продали свою компанию). Некоторые также думают, что простое удаление страниц и добавление старого контента на новый сайт будет работать так же хорошо (это не так).

Некоторые также думают, что простое удаление страниц и добавление старого контента на новый сайт будет работать так же хорошо (это не так).

Если вас оштрафовали, самый безопасный путь — полностью исправить свой поступок. У вас должен быть совершенно новый контент, и вы должны перестроить домен с нуля или провести полную перестройку контента. Google объясняет, что они ожидают, что вам потребуется столько же времени, чтобы уйти от штрафа, сколько потребовалось, чтобы вы попали в него.

14. Ваше техническое SEO ужасно

Не заблуждайтесь: покупка технического SEO на Fiverr.com похожа на покупку Lamborghini в магазине за доллар: вы, скорее всего, получите подделку, а не настоящую вещь.

Правильное техническое SEO того стоит: Google и ваши пользователи полюбят вас.

Давайте рассмотрим некоторые распространенные проблемы и решения, а также то, где вам может помочь техническое SEO.

Проблема: Ваш сайт не достигает показателей Core Web Vitals

Решение: Техническая поисковая оптимизация поможет вам определить проблемы с основными показателями работы сети и предоставит вам путь к их устранению. Не полагайтесь только на стратегический аудит — он не всегда поможет вам в этих областях. Вам нужен полный технический SEO-аудит, чтобы выявить некоторые из этих проблем, потому что они могут варьироваться от совершенно простых до невероятно сложных.

Не полагайтесь только на стратегический аудит — он не всегда поможет вам в этих областях. Вам нужен полный технический SEO-аудит, чтобы выявить некоторые из этих проблем, потому что они могут варьироваться от совершенно простых до невероятно сложных.

Проблема: Проблемы со сканированием и индексированием вашего сайта

Решение: Они могут быть невероятно сложными, и для их обнаружения и исправления требуется опытный специалист по технической оптимизации. Вы должны определить их, если обнаружите, что у вас нулевая тяга или вы не получаете никакой производительности от своего сайта.

Также убедитесь, что вы случайно не поставили галочку в поле «запрещать поисковым системам индексировать ваш сайт» в WordPress.

Проблема: Файл robots.txt вашего сайта каким-то образом непреднамеренно блокирует доступ поисковых роботов к важным файлам

Решение: Опять же, техническое SEO здесь, чтобы спасти вас из бездны. Некоторые сайты находятся в таком глубоком упадке, что вы не видите другого выхода, кроме как удалить сайт и начать заново. Ядерный вариант не всегда лучший вариант. Именно здесь опытный технический SEO-специалист на вес золота.

Некоторые сайты находятся в таком глубоком упадке, что вы не видите другого выхода, кроме как удалить сайт и начать заново. Ядерный вариант не всегда лучший вариант. Именно здесь опытный технический SEO-специалист на вес золота.

Выявление проблем с индексацией веб-сайта — сложная задача, но ее стоит решить

Контент, техническое SEO и ссылки — все это важно для поддержания траектории производительности вашего сайта. Но если у вашего сайта есть проблемы с индексацией, другие элементы SEO не помогут вам.

Не забудьте поставить галочки во всех полях и убедиться, что вы действительно продвигаете свой сайт самым правильным образом.

И не забудьте оптимизировать каждую страницу вашего сайта по релевантным ключевым словам! Также стоит убедиться, что ваше техническое SEO на должном уровне, потому что чем лучше Google сможет сканировать, индексировать и ранжировать ваш сайт, тем лучше будут ваши результаты.

Google (и трафик вашего сайта) будут вам благодарны.

Дополнительные ресурсы:

- 11 SEO-советов и приемов для улучшения индексации

- Как поисковые системы сканируют и индексируют: все, что вам нужно знать

- Как работают поисковые системы

Рекомендуемое изображение: Shutterstock/Sammby

Категория

SEO

Почему Google не индексирует мою страницу Контрольный список из 11 шагов

Мы составили контрольный список, в котором перечислены несколько простых шагов для проверки статуса индексации вашей страницы или веб-сайта, а также способы определения (и устранения ) некоторые из наиболее распространенных проблем, которые могут препятствовать индексации вашего контента.

Подробный контрольный список того, почему ваша страница не индексируется Google. чтобы пройти через все это, чтобы вернуть ваши страницы на путь индексации.

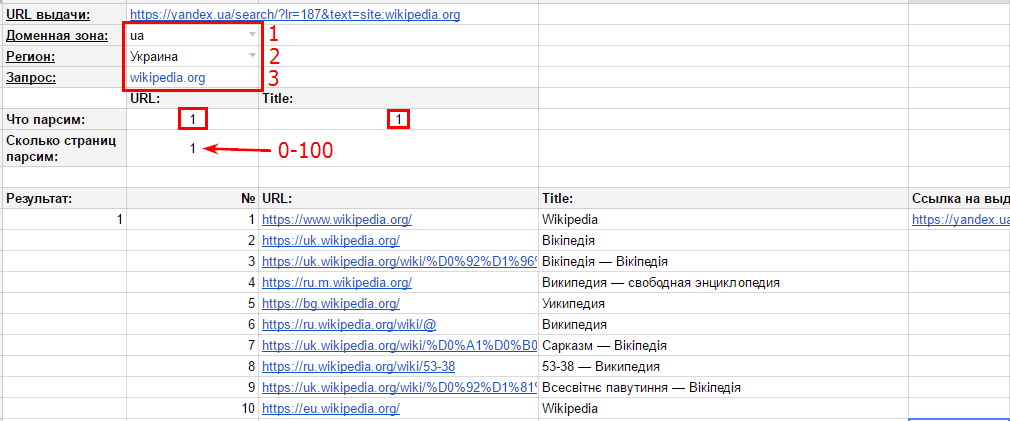

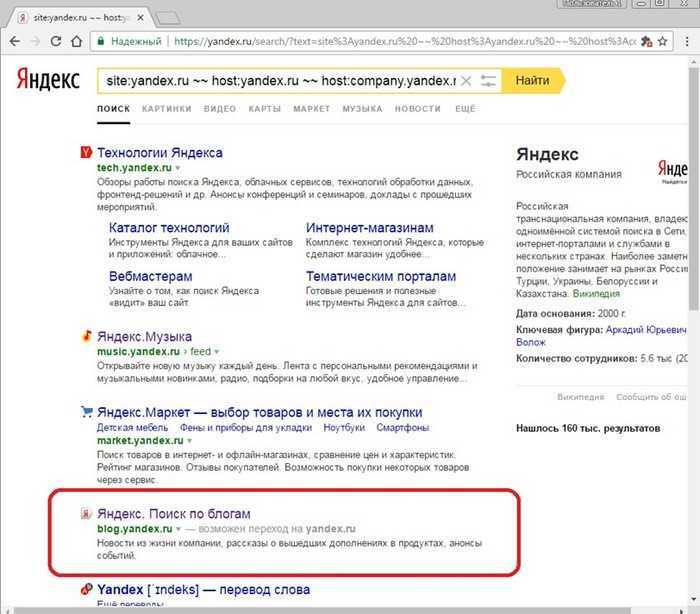

Шаг 1. Проверьте, отображается ли ваша страница в индексе

Первое, что нужно проверить, это убедиться, что ваша страница или веб-сайт еще не включены в индекс. Самый быстрый способ проверить это с помощью поисковых операторов . Это поисковые запросы, которые вы можете использовать в поиске Google, чтобы помочь пользователю найти более конкретные результаты поиска.

Самый быстрый способ проверить это с помощью поисковых операторов . Это поисковые запросы, которые вы можете использовать в поиске Google, чтобы помочь пользователю найти более конкретные результаты поиска.

Например: используйте оператор «site:» для проверки индексации всего сайта:

site:domain.com

Вы также можете использовать тот же оператор для проверки отдельной страницы:

site:domain.com/ page-name

Если вы видите подобный результат, это означает, что ваша страница в данный момент не находится в индексе:

Существует множество других поисковых операторов с различными вариантами использования, но это основной, который вам понадобится. для проверки индексации.

Как Botify упрощает просмотр индексируемости?

Хотя Botify не является прямым отражением того, что Google проиндексировал или не проиндексировал, он позволяет очень легко проверить не только индексируемость страницы, но и индексируемость любой группы страниц, включая:

- Типы страниц /сегментация/общая структура URL

- Панировочные сухари

- Страницы, имеющие какие-либо общие черты в HTML

Щелкните приведенные выше ссылки, чтобы узнать больше о каждой разбивке, доступной для сканирования, журнала и консоли поиска Google. Для отдельных URL-адресов это так же просто, как выполнить быстрый поиск в нашем проводнике URL-адресов.

Для отдельных URL-адресов это так же просто, как выполнить быстрый поиск в нашем проводнике URL-адресов.

Шаг 2. Проверьте консоль поиска Google на наличие информации

Следующее место для проверки — консоль поиска Google. Перейдите к отчету о покрытии, чтобы просмотреть статус индексации вашего сайта:

Две вкладки, на которых показаны страницы, которые не были проиндексированы, — это вкладка «ошибка» и вкладка «исключено».

Если ваша страница была просканирована и Google решил не индексировать ее, она будет в отчете «Исключено».

Если ваша страница не может быть просканирована и/или не может быть проиндексирована по какой-либо причине, она появится в отчете «Ошибка». Стоит отметить, что затронутых URL-адресов более 1 тыс., здесь будет доступен только образец из 1 тыс. — не обязательно тот конкретный URL, который ищет пользователь.

Если ваша страница появляется в одном из этих отчетов, вы сможете определить, в чем проблема, щелкнув этот URL-адрес и выбрав опцию «Проверить URL-адрес». Это хороший начальный шаг или первое место для проверки состояния индекса (по сравнению с отчетами о покрытии выше, которые предоставляют ограниченные выборки).

Это хороший начальный шаг или первое место для проверки состояния индекса (по сравнению с отчетами о покрытии выше, которые предоставляют ограниченные выборки).

Вы также можете выбрать «Проверить активный URL-адрес», который может предоставить дополнительную информацию:

В зависимости от размера вашего веб-сайта вы можете не найти нужный URL-адрес в отчете о покрытии. Эти отчеты содержат до 1000 «примеров» URL-адресов для каждого типа ошибки. Вместо этого вы также можете просто использовать панель поиска в верхней части страницы, чтобы напрямую проверить URL-адрес:

Шаг 3. Проверьте, не блокируют ли элементы страницы индексацию

В отчетах об ошибках может быть указано, что страницы блокируются метатегом robots noindex («Отправленный URL-адрес с пометкой «noindex»»). Чтобы проверить эту проблему, вы можете перейти непосредственно на страницу и открыть исходный код HTML-страницы. (Если вы не знаете, как это сделать, просто добавьте «view-source:» перед полным URL-адресом).

Когда вы просматриваете исходный код, найдите на странице «noindex», и вы сможете увидеть, блокирует ли вашу страницу тег noindex.

Ваша страница также может иметь HTTP-заголовок X-Robots-Tag, например:

HTTP/1.1 200 OK

Дата: вторник, 25 мая 2010 г., 21:42:43 по Гринвичу

(…)

X- Robots-Tag: noindex

(…)

Вы можете использовать подобный инструмент для проверки HTTP-заголовка вашей страницы.

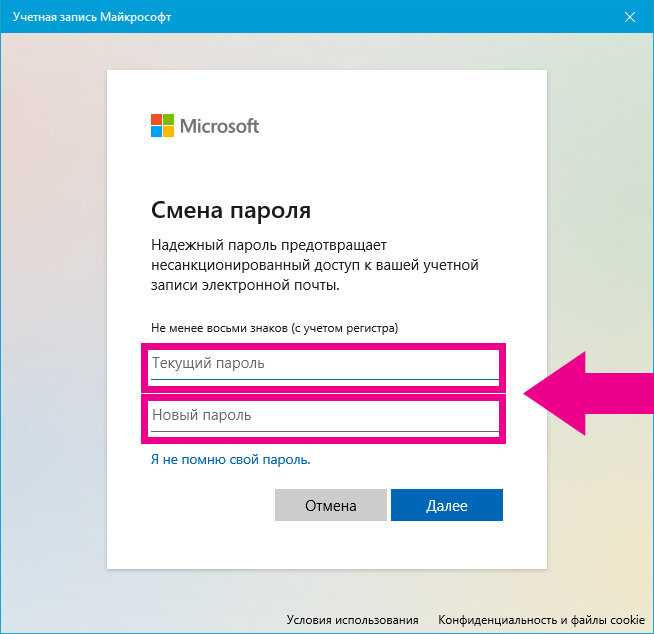

Если у вас есть веб-сайт WordPress, возможно, вы случайно установили в настройках конфиденциальности значение «Попросить поисковые системы не индексировать этот сайт». Просто измените этот параметр на «Разрешить поисковым системам индексировать этот сайт».

Примечание. Инструмент Inspect URL также помечает, если на странице есть директива noindex.

Шаг 4. Проверьте файл robots.txt

Другим местом, где ваша страница может быть заблокирована директивой robots, является файл robots. txt.

txt.

Вы можете быстро проверить это с помощью инструмента Google для проверки robots.txt или проверить файл самостоятельно, перейдя в /robots.txt в своем домене.

Шаг 5. Убедитесь, что вашу страницу можно найти

Чтобы страница была проиндексирована, она должна быть обнаружена поисковым роботом. Есть несколько способов, которыми вы можете помешать поисковым роботам обнаружить вашу страницу (и которые вы можете использовать, чтобы гарантировать, что они смогут ее найти).

Если на вашу страницу не ссылаются откуда-то еще, или если на нее есть ссылка из малоизвестной части сайта, поисковые роботы могут не найти ссылку и, следовательно, не смогут найти страницу. Убедитесь, что вы включили внутренние ссылки на свой сайт, которые указывают на страницу, если вы хотите, чтобы поисковые системы могли получить к ней доступ и проиндексировали ее.

Одним из лучших мест для включения ссылки на страницу является карта сайта XML. Если ваша страница не включена в XML-карту сайта, Google может счесть ее менее ценной или просто будет сложнее найти ее. Чтобы избежать этого, не забудьте включить все страницы, которые важны для сканирования и индексации, в карту сайта XML.

Чтобы избежать этого, не забудьте включить все страницы, которые важны для сканирования и индексации, в карту сайта XML.

Шаг 6. Убедитесь, что ваша страница работает (даже с отключенным Javascript)

Даже если ваша страница будет обнаружена поисковыми роботами, она не будет проиндексирована, если доступ к содержимому недоступен. Убедитесь, что ваша страница:

- обслуживает код состояния 200

- отображает важный контент и имеет кликабельные ссылки даже при отключенном Javascript

Если у вашего веб-сайта часто возникают проблемы с простоями, это также может вызвать проблемы с индексацией.

Шаг 7. Проверка на наличие дублирующегося или малоценного контента

Цель Google — показать наиболее релевантный контент для данного запроса. Таким образом, он обесценивает контент, который слишком похож на другой контент, который уже находится в индексе.

Некоторые из способов создания дублированного контента включают:

- параметры: если вы используете параметры, у вас может быть несколько версий одной и той же страницы с разными URL-адресами

- фасеты/страницы тегов: если вы используете фасетную навигацию или категоризацию, например страницы блога/тегов/, содержимое может быть очень похожим, если не дублироваться по нескольким тегам или категориям

- локализация: страницы для конкретных городов или страницы, ориентированные на комбинации страны/языка, могут иметь одинаковое содержание и требовать большей дифференциации (или для международных вариантов использование аннотаций hreflang)

- внешнее дублирование: если вы синдицируете контент из другого источника, очищаете контент или иным образом повторно публикуете что-то, что уже было опубликовано, оно, скорее всего, будет рассматриваться как дубликат (и если вы делаете слишком много этого, это может послать сигнал о низком качестве контента)

Также следует убедиться, что на странице нет тега rel=canonical, указывающего на другой URL-адрес в качестве основной версии. Вы можете проверить это с помощью инструмента «Проверить URL» в Google Search Console:

Вы можете проверить это с помощью инструмента «Проверить URL» в Google Search Console:

или в исходном коде страницы, выполнив поиск в коде «rel=canonical»:

Шаг 8. Проверьте файл .htaccess вашего сайта

Файл .htaccess представляет собой файл конфигурации сервера. Его можно использовать для создания перенаправлений (и случайных циклов перенаправления), перезаписи некрасивых строк URL-адресов в более чистые версии и даже для блокировки страниц от сканеров. Если ваш сайт или страница не заблокированы в robots.txt или с помощью директив на странице, таких как тег noindex, но недоступны для сканеров, они могут быть заблокированы через .htaccess.

Шаг 9. Проверьте время загрузки вашего сайта

Несмотря на то, что немного медленный сайт не принесет вам никакой пользы в Google, он, как правило, не помешает индексации вашего контента (хотя это может повредить вашей способности ранжироваться). Но если ваша страница регулярно занимает гораздо больше времени, чем обычные отраслевые стандарты, особенно если загрузка занимает так много времени, что истекает время ожидания, это может быть расценено поисковыми системами как плохой пользовательский опыт, и они могут решить не индексировать эту страницу. В этом случае они также могут просто не иметь доступа к контенту.

В этом случае они также могут просто не иметь доступа к контенту.

Шаг 10. Убедитесь, что ваш контент доступен на мобильных устройствах

Поскольку индексирование с приоритетом мобильных устройств становится распространенным (а вскоре и единственным) методом индексации, поисковые роботы могут видеть ваш контент только в том случае, если он доступен для мобильных устройств. гусеницы. Убедитесь, что любой контент, который вы хотите проиндексировать, доступен в мобильной версии вашего веб-сайта (и, конечно же, эта мобильная версия является быстрой и удобной для пользователя).

Шаг 11. Проверьте себя (также известный как «Может ли это быть наказание?»)

Если вы баловались серыми или черными методами, которые противоречат рекомендациям Google, возможно, вы столкнулись с ручным действием. Они также известны как «штрафы» и происходят, когда команда Google вручную наказывает веб-сайт за поведение и тактику, которые они считают спамом.

Эти приемы включают:

- неестественные ссылки на ваш сайт или с вашего сайта

- взломанный сайт

- тонкое содержимое

- чистый спам

- пользовательский спам

- маскировка и скрытая переадресация

- скрытые изображения

- наполнение скрытым текстом и ключевыми словами

- свободные от спама хосты

- Несоответствие содержимого AMP

- скрытая мобильная переадресация

- спам, разметка структурированных данных

Если вы подверглись ручному действию, вы должны получить уведомление в отчете о ручных действиях в Google Search Console. Как правило, это уведомление будет содержать подробную информацию о проблеме и рекомендуемые действия по ее устранению. После того, как все затронутые страницы будут исправлены, вам нужно будет отправить запрос на проверку из отчета.

Отправка вашей страницы на индексацию

После того, как вы проверили все эти элементы и устранили все обнаруженные проблемы, вы можете (повторно) отправить свою страницу в Google для сканирования.

Ждем, пока увидят, или вручную ускоряем процесс индексации.

Ждем, пока увидят, или вручную ускоряем процесс индексации.

Инструмент анализирует вашу веб-страницу в соответствии с пятью лучшими рекомендациями по производительности (которые имеют решающее значение для более быстрой загрузки сайтов), такими как минимизация подключений, уменьшение размера полезной нагрузки, использование кэширования браузера и т. д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт.

Инструмент анализирует вашу веб-страницу в соответствии с пятью лучшими рекомендациями по производительности (которые имеют решающее значение для более быстрой загрузки сайтов), такими как минимизация подключений, уменьшение размера полезной нагрузки, использование кэширования браузера и т. д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт.