Содержание

Почему страницы сайта выпадают из индекса — Маркетинг на vc.ru

В этой статье специалист Mello затронет следующие вопросы:

2568

просмотров

- Как проверить индексацию страницы сайта в Яндексе и в Google

- С помощью каких сервисов можно проверить информацию об исключенных URL

- Причины выпадения страниц из индекса и что делать в такой ситуации

Одиночное выпадение страниц из индекса поисковых систем

Вебмастер может заметить, что трафик, присутствовавший на некогда популярной странице услуги, исчез, звонки прекратились, а продажи упали до нуля. В этом случае следует проверить – не выпала ли данная страница из индекса поисковых систем, особенно если единственным каналом продвижения этой услуги в интернете был органический поиск.

Как проверить не выпала ли страница из индекса Яндекса:

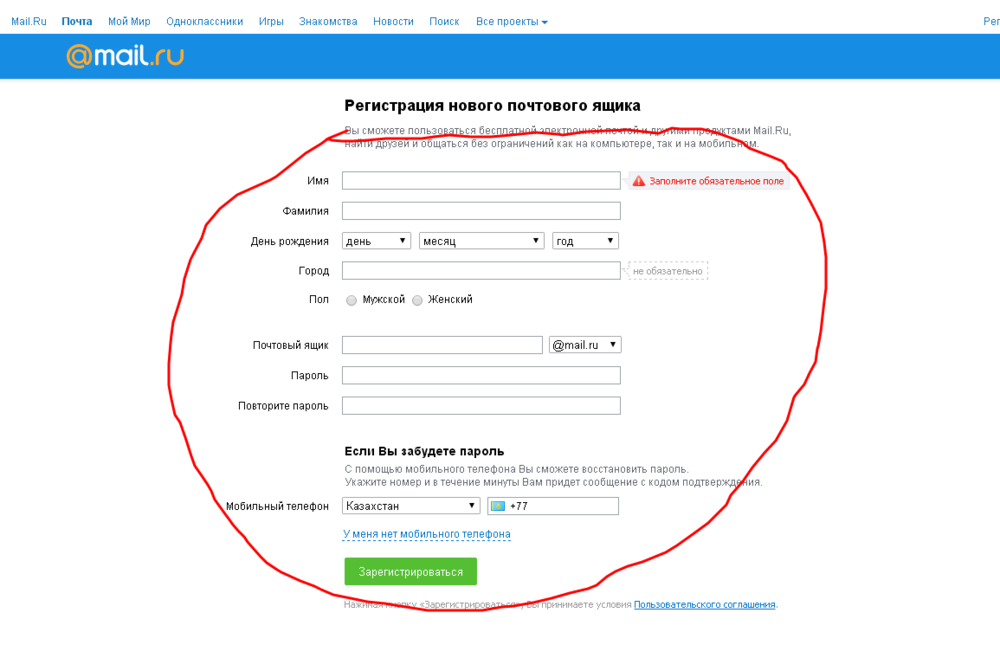

В Яндекс Вебмастере. Вкладка «Индексирование — Проверить статус URL». Вводим URL нужной страницы, нажимаем кнопку “Проверить” и ждём. Если в результате написано, что страница обходится роботом и находится в поиске, значит все хорошо:

Вводим URL нужной страницы, нажимаем кнопку “Проверить” и ждём. Если в результате написано, что страница обходится роботом и находится в поиске, значит все хорошо:

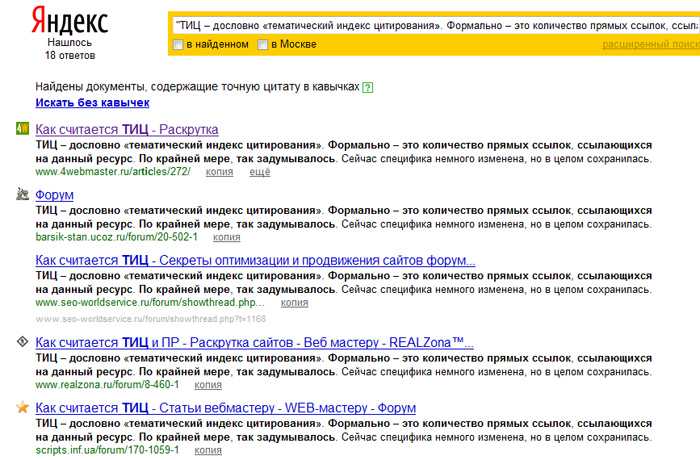

Через оператор url. В поисковой строке Яндекса вводим запрос по формуле [url:URL_документа]. Пример:

Если страница присутствует в индексе, Яндекс ее выведет.

Пример с отсутствующим в поиске URL:

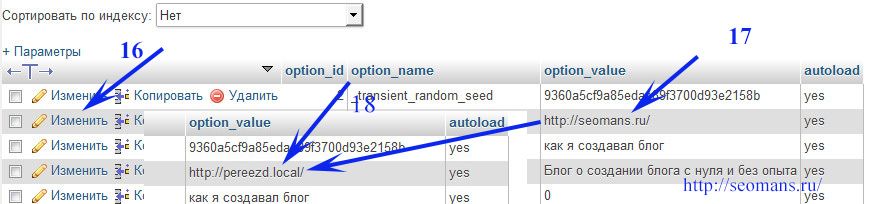

Как проверить не выпала ли страница из индекса Google:

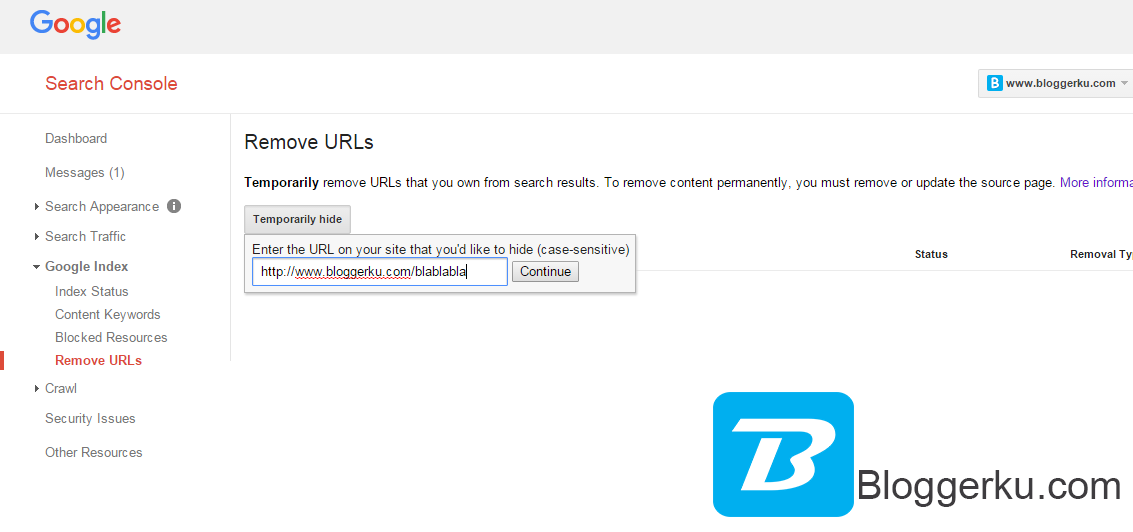

Проверить индексацию страницы в Гугле можно через сервис Google Search Console. Вставляем URL в строку проверки, нажимаем Enter:

Выводится информация о странице. В данном случае нас интересует информация о том, что URL присутствует в индексе Google.

Массовое выпадение страниц из индекса поисковых систем

Необходимо регулярно проверять свой сайт на количество исключенных из поиска страниц, так как целевые страницы могут выпасть из индекса в любой момент.

Как проверить информацию об исключенных страниц в Яндексе:

С помощью Вебмастера Яндекса можно узнать всю необходимую информацию об индексации страниц. Вкладка «Индексирование -> Страницы в поиске».

Вкладка «Индексирование -> Страницы в поиске».

Всегда проверяйте исключенные URL, особенно если видите, что раньше страниц в поиске было заметно больше. Здесь вы можете увидеть информацию о дате и причине исключения URL из индекса.

Как проверить информацию об исключенных страницах в Google:

В Google Search Console также можно посмотреть информацию об исключенных URL. Для этого перейдем во вкладку «Покрытие»:

Здесь нам показывают:

- Страницы с ошибками – Google не смог их проиндексировать

- Без ошибок, есть проблемы — проиндексированные страницы, но, возможно, имеющие ошибку с нашей стороны (например запрещены нужные нам URL в файле robots.txt)

- Без ошибок

- Исключенные

По каким причинам страницы выпадают из индекса

Причин, по которым страницы могут исключить из индекса, целое множество. Мы разделим их на две группы: технические причины и причины, зависящие от контента.

Технические причины

Редиректы

Поисковые системы исключают из индекса страницы, которые перенаправляют пользователя на другие страницы. При этом сама конечная страница (на которую идет перенаправление) зачастую не исключается (если нет другой причины).

Типичный пример исключения страницы, перенаправляющей пользователя на другую страницу (301 редирект):

Конечная страница осталась в поиске:

Так как конечная страница остается в поиске, то ничего страшного в данной ситуации нет, но желательно минимизировать кол-во ненужных 301 редиректов на сайте, если есть такая возможность.

404

Страницы с 404 ошибками также выпадают из индекса:

Если страница удалена по ошибке, то конечно необходимо ее восстановить. Если страница больше не нужна, то нужно удалить все ссылки на сайте, ведущие на нее.

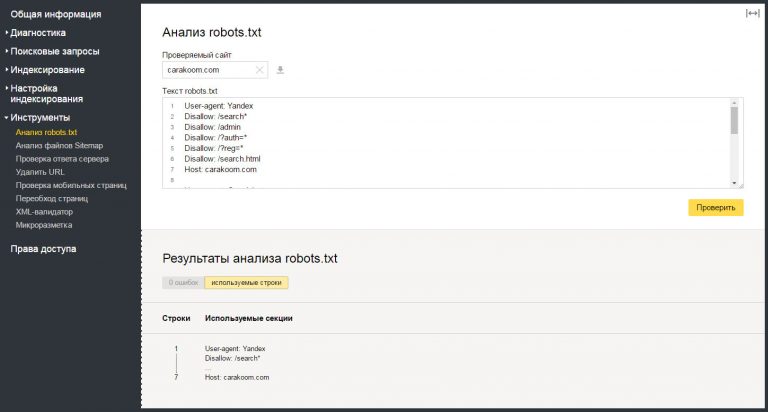

Файл Robots.txt и мета-тег Robots

Вебмастер может рекомендовать поисковым системам не включать в индекс нужные ему URL с помощью файла robots. txt или с помощью мета-тега Robots:

txt или с помощью мета-тега Robots:

Проверьте файл robots.txt, нет ли там нужных вам страниц. Также проверьте мета-тег Robots. Если вы видите, что у атрибута “name” задано значение “robots”, а у атрибута “content” присутствует значение “noindex”, это означает, что сканирование страницы запрещено для всех поисковых роботов:

Более подробно про данный мета-тег можете почитать в справке Google.

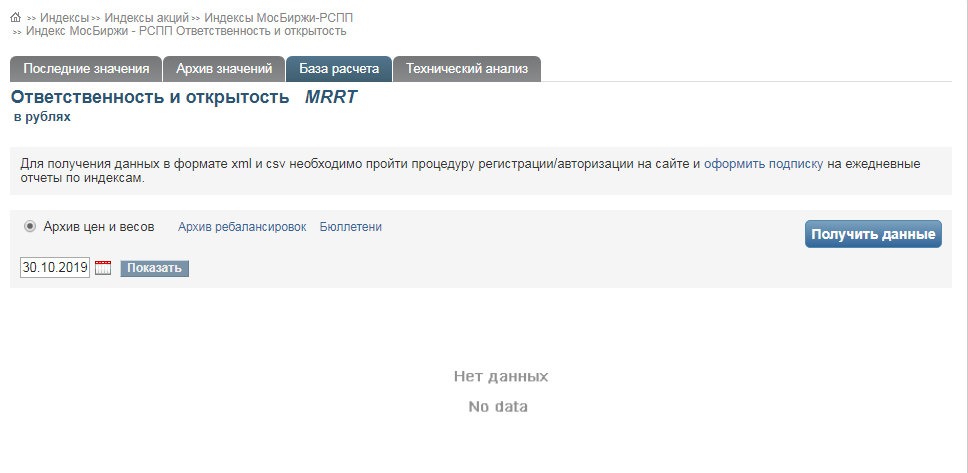

Страница обнаружена, но не проиндексирована

В Google Search Console есть исключенные из индекса URL со статусом «Страница просканирована, но пока не проиндексирована»:

Это означает, что поисковый робот нашел вашу страницу, но не добавил ее в индекс. В данном случае нужно просто подождать и страница будет добавлена в поиск.

Причины, зависящие от контента

Дубли

Страницы полностью или частично дублирующие другие могут быть исключены из поиска.

Если страницы-дубли не нужны, то лучшим решением будет их удалить. Если нужны, то можно установить тег “rel=canonical” в этих страниц.

Если нужны, то можно установить тег “rel=canonical” в этих страниц.

Например:

Также можно настроить 301 редирект со страницы-дубля на каноническую страницу.

Если обе похожие друг на друга страницы должны присутствовать не только на сайте, но и в поиске (например, две страницы карточек товара), то их нужно сделать уникальными (изменить мета-теги, текст на странице, фото и т.д.).

Недостаточно качественные страницы

Сюда относятся страницы, несоответствующие запросу и неcпособные удовлетворить потребности пользователя.

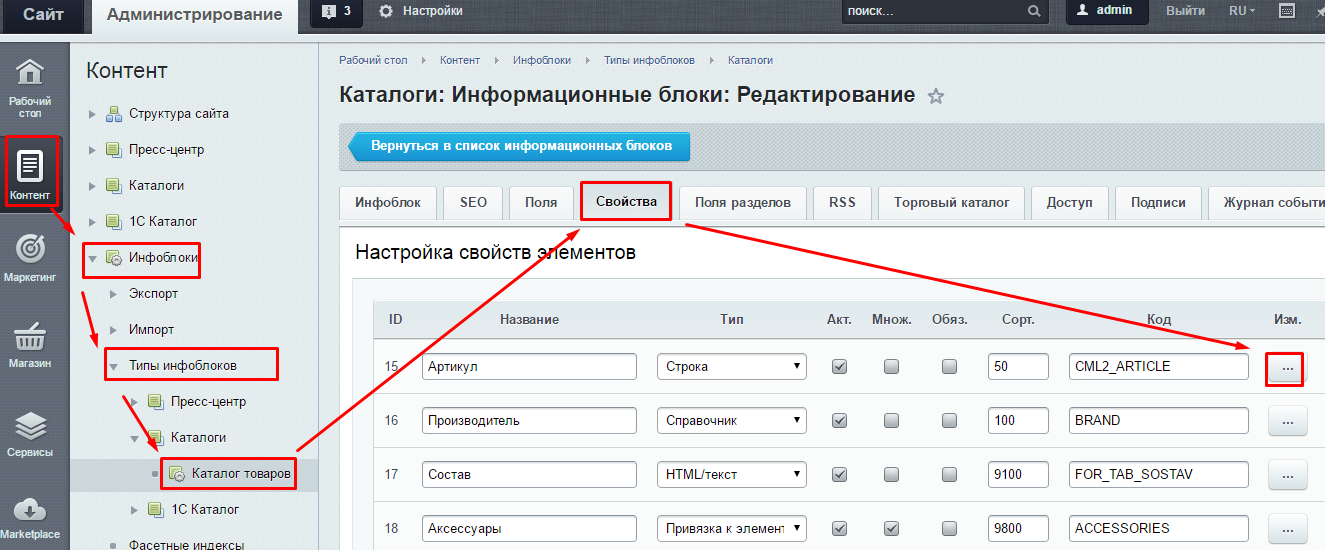

Необходимо сделать страницу более качественной. Если это страница блога, то сделать уникальный и полезный читателю контент. Если это страница карточки товара в интернет-магазине, то товар должен быть в наличии (или должна присутствовать возможность заказать со склада), содержать описание, краткие характеристики товара и т.д.

Переоптимизированный контент

Тексты, сделанные для поисковиков, а не для людей. Их отличает большое количество вхождений ключевых слов. В случае, если у вас на сайте много переоптимизированного контента, поисковики могут наложить фильтр на сайт и целое множество страниц выпадет из индекса.

Их отличает большое количество вхождений ключевых слов. В случае, если у вас на сайте много переоптимизированного контента, поисковики могут наложить фильтр на сайт и целое множество страниц выпадет из индекса.

Как написано выше — делайте контент в первую очередь для пользователей. И не забывайте про фактор переоптимизации.

Накрутка поведенческих факторов

Поисковые системы накладывают санкции за использование различных методов так называемого «черного» SEO. Одним из таких методов и является попытка накрутить поведенческие факторы искусственным путем.

Не стоит использовать в своей работе сомнительные сервисы и программы по накрутке поведенческих факторов.

Неестественный ссылочный профиль

Если на сайте расположено множество покупных ссылок, а естественных ссылок очень мало, на него может наложиться фильтр поисковых систем (Минусинск у Яндекса и Пингвин у Гугла).

Аффилированность

Если два сайта одной компании борются за место в выдаче, то поисковые системы показывают страницу только одного сайта (как правило показывается наиболее подходящий запросу).

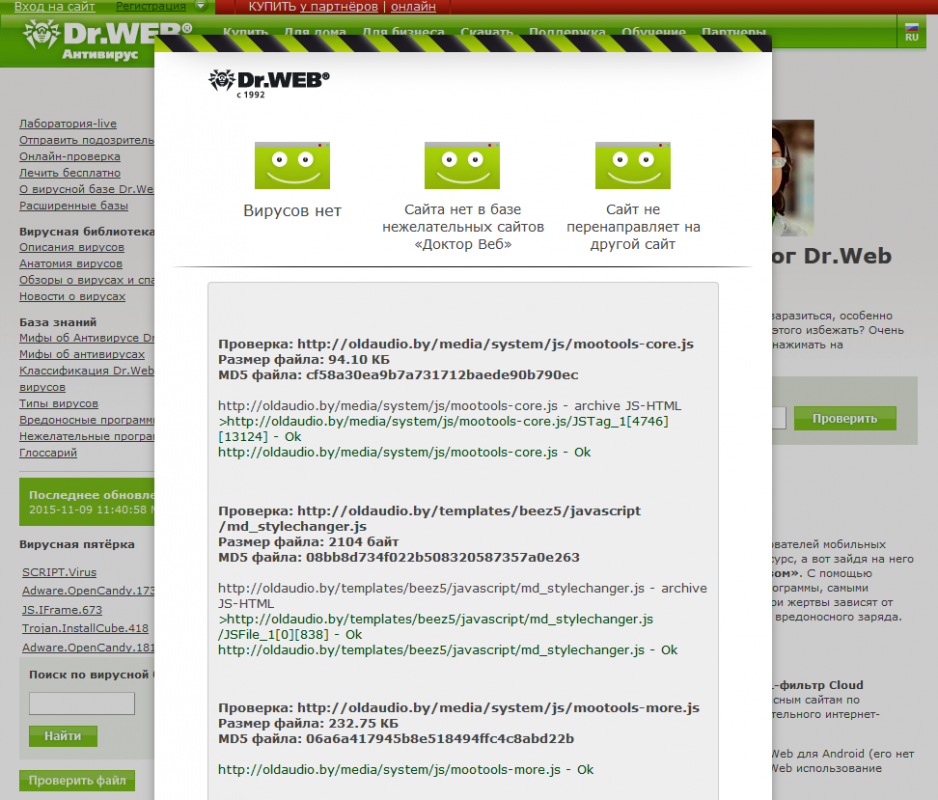

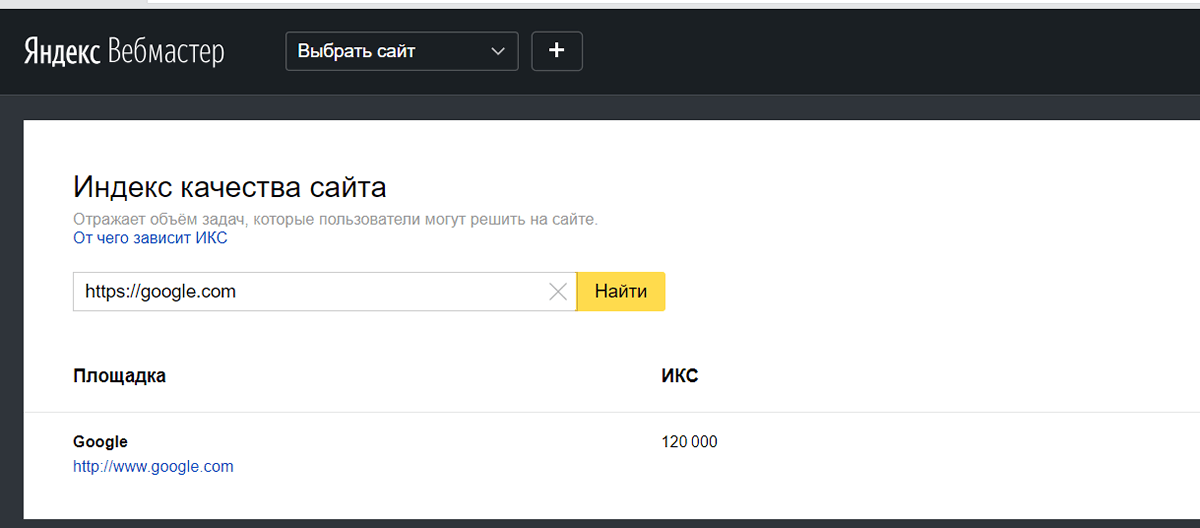

Как проверить находится ли сайт под фильтром

В Яндексе

Зайдите в раздел «Диагностика -> Безопасность и нарушения» в Яндекс Вебмастере:

Если ваш сайт получил фильтр, то информация об этом отобразится в данном разделе.

В Google

В Google Search Console это можно проверить в разделах «Меры принятые вручную» и «Проблемы безопасности»:

Вывод

Если вы попали ситуацию с кучей выпавших из индекса URL, проанализируйте:

- Заказывали ли вы ссылки, какие и сколько

- Все ли тексты на вашем сайте качественные и уникальные

- Удобен ли ваш сайт для пользователя, нет ли там излишней рекламы

- Какие страницы запрещены с помощью файла Robots.txt и мета-тега robots

- Присутствуют ли на сайте страницы-дубли

и исходя из итогов анализа устраните причину.

Если же вам не удалось установить причину исключения URL из индекса, или вы устранили все возможные ошибки, а страницы так и не попали в поиск, попробуйте обратиться в техподдержку поисковой системы.

Автор: специалист SEO- отдела в Mello, Павел Шевченко.

ТОП-7 причин, почему сайт не индексируется Google

Spread the love

В практике SEO-специалистов нередко бывают ситуации, когда работа над сайтом ведется полным ходом: добавляется уникальный качественный контент, расширяется структура, появляются новые полезные разделы, статьи блога, а количество страниц в индексе никак не увеличивается. Что еще хуже — они начинают выпадать оттуда или вовсе индексация веб-сайта отсутствует, и он не появляется в результатах поиска, невидим для поисковика и не получает органический трафик.

Повторные проверки, как показывает опыт, ни к чему не приводят. Единственный рациональный выход из данной ситуации — поиск причины, почему сайт не индексируется в Гугле. Не будем тянуть время, и приступим к решению вашей проблемы “не отходя от кассы”.

В статье вы узнаете:

- Что такое ранжирование, индексирование сайта и краулинг

- Как проверить наличие и количество страниц в индексе Гугла

- Сайт не индексируется Google: как “скормить” его поисковику

- Каковы причины отсутствия сайта в индексе и что сделать для их устранения

- Оптимизируйте файлы robots.

txt, sitemap.xml и .htaccess

txt, sitemap.xml и .htaccess - Просмотрите теги meta name «robots» и rel=”canonical”

- Проверьте скорость и правильность ответов сервера

- Убедитесь, что web-страница уникальна, полезна, не “сирота”, не дубль

- Исключите фактор влияния поисковика: фильтр, технические проблемы

- Проверьте доменное имя: молодой сайт либо домен с историей

- Проанализируйте ссылки, как внешние, так и внутренние

- Подытоживая сказанное

Что такое ранжирование, индексирование сайта и краулинг?

Для начала разберемся в базовой терминологии и поймем принцип работы поисковика. Поисковый бот Google как паук пробирается по Всемирной паутине, находит и добавляет в базу новые веб-страницы. После ввода запроса пользователем поисковик сортирует ресурсы так, чтобы в ТОПе оказались те, содержание которых максимально соответствует вводимой поисковой фразе.

Теперь по терминам:

- Индексирование — добавление и сохранение новых страниц в базу данных.

- Краулинг — процесс обхода гиперссылок с целью поиска нового контента.

- Ранжирование — распределение страниц по релевантности ключевому запросу.

Проводя аналогию, можно сказать, что индексирование — это регистрация в турнире, а ранжирование — присвоение призовых мест. Согласитесь, без регистрации участие и победа не возможны.

Как проверить наличие и количество страниц в индексе Гугла?

При наличии доступа к сервису Search Console, проверяйте индексирование сайта в Гугл там. В разделе “Покрытие” содержится вся необходимая информация, отображающая количество онлайн-страниц в индексе, в том числе с ошибками и предупреждениями.

Якщо в перших трьох полях ви бачите числа, відмінні від нуля, – індексація сайту в Гугл присутня, і хоча б частина контенту є в базі даних. Наявність певної кількості сторінок в графі “Виключених” не є чимось критичним. Однак, якщо у вас всюди 0, а в останньому полі значення не дорівнює нулю, є проблеми зі сприйняттям ресурсу пошукачем. Значить, пора шукати причину, чому

Значить, пора шукати причину, чому

Гугл не індексує сайт, та усувати її.

Помимо общего количества интернет-страниц в индексе, сервис Search Console позволяет проверить индекс любой отдельно взятой. В зависимости от ее состояния вы увидите соответствующее уведомление.

Например, тут все в порядке

А здесь индексирование не выполнено

Лучшего способа, как проверить количество страниц в индексе Google, пожалуй, нет. Когда судьба web-ресурса вам не безразлична, а поисковый трафик представляет интерес, рекомендуем зарегистрироваться в Search Console — это необходимо и делается бесплатно.

Второй вариант все же есть, и он для тех, у кого нет доступа к консоли, — использование оператора site: перед url поможет выяснить, есть ли интернет-ресурс в индексе и в каком объеме он там присутствует. Как проверить страницы в индексе Гугл таким способом?

Допустим, вводим site: перед нашим url-ом

Видим приблизительное количество интернет-страниц в индексе поисковика. По такому же принципу можно проверить отдельный page. Например:

По такому же принципу можно проверить отдельный page. Например:

Сайт не индексируется Google: как “скормить” его поисковику

Если вы обнаружили, что Гугл не индексирует сайт или отдельную web-page, рекомендуем действовать по следующему алгоритму:

- Откройте панель вебмастера Search Console;

- Зайдите в раздел проверки урлов;

- Вставьте в поисковую строку ссылку, которую вы желаете проверить;

- Запросите проверку и дождитесь результата;

- Если урла нет в базе Гугл, кликните по параметру “Запросить индексирование”.

Увы, если в индексе отсутствует несколько сотен или тысяч целевых страниц вашего онлайн-ресурса, данный метод перебора окажется не особо эффективным и слишком затратным по времени. Плохая индексация сайта в Google указывает на глубинные проблемы, для решения которых одними запросами не обойтись. Но и забывать о них не следует. Запросы через Search Console полезны, когда вы размещаете новые материалы, расширяете структуру, обновляете контент. С их помощью вы сообщаете поисковику о том, что web-сайт обновился, и боту следует обратить внимание на это.

С их помощью вы сообщаете поисковику о том, что web-сайт обновился, и боту следует обратить внимание на это.

Например, моделируем ситуацию. Молодой web-сайт после разработки был выпущен в индекс в начале февраля этого года. Понятно, что Гугл к новым инет-ресурсам относится с подозрением и не спешит награждать их хорошим ранжированием. По истечении пары месяцев работы оказалось, что некоторые карточки товаров, причем с оптимизированным контентом и мета данными, отсутствуют в выдаче просто потому, что бот посетил их однажды, например, 31 января, увидел noindex в мета теге robots, и в течение двух месяцев больше туда не заходил.

В данной ситуации причина, вероятно, кроется в том, что после обновления и оптимизации карточки товара забыли отправить запрос через консоль веб-мастера и уведомить Гугл о том, что контент обновился.

Каковы причины отсутствия сайта в индексе и что сделать для их устранения

Касаемо вариантов, почему Гугл не индексирует сайт в целом, нужно тщательно изучать каждый отдельный случай, и отыскать источник этого явления как можно скорее. В нашей новой статье мы рассмотрим ТОП-7 наиболее частых причин отсутствия web-платформ в базе поисковика, и опишем методы их устранения.

В нашей новой статье мы рассмотрим ТОП-7 наиболее частых причин отсутствия web-платформ в базе поисковика, и опишем методы их устранения.

Оптимизируйте файлы robots.txt, sitemap.xml и .htaccess

Одной из распространенных ошибок веб-мастеров является неправильно составленный robots. Наличие в нем блокирующих директив Disallow может препятствовать обработке ботом всего ресурса или отдельных его инет-страниц. Тут важно помнить, что у каждого web-сайта есть страницы, которые нужно закрывать от индексации. К таковым относятся технические, результатов поиска, get-параметров, логина, админа, корзины покупок, “мусорные” и т.п.

Если в роботсе указано:

- User-agent: *

- Disallow:

Значит, интернет-ресурс полностью закрыт для поисковиков. В Search Console в категории “Покрытие” можно увидеть все урлы, заблокированные в robots. Чаще всего это происходит с новыми web-сайтами, когда разработчики сохранили тестовые версии на поддомене и закрыли их от индексации. При переносе обновить роботс часто забывают, и готовый ресурс остается недоступным для ботов.

При переносе обновить роботс часто забывают, и готовый ресурс остается недоступным для ботов.

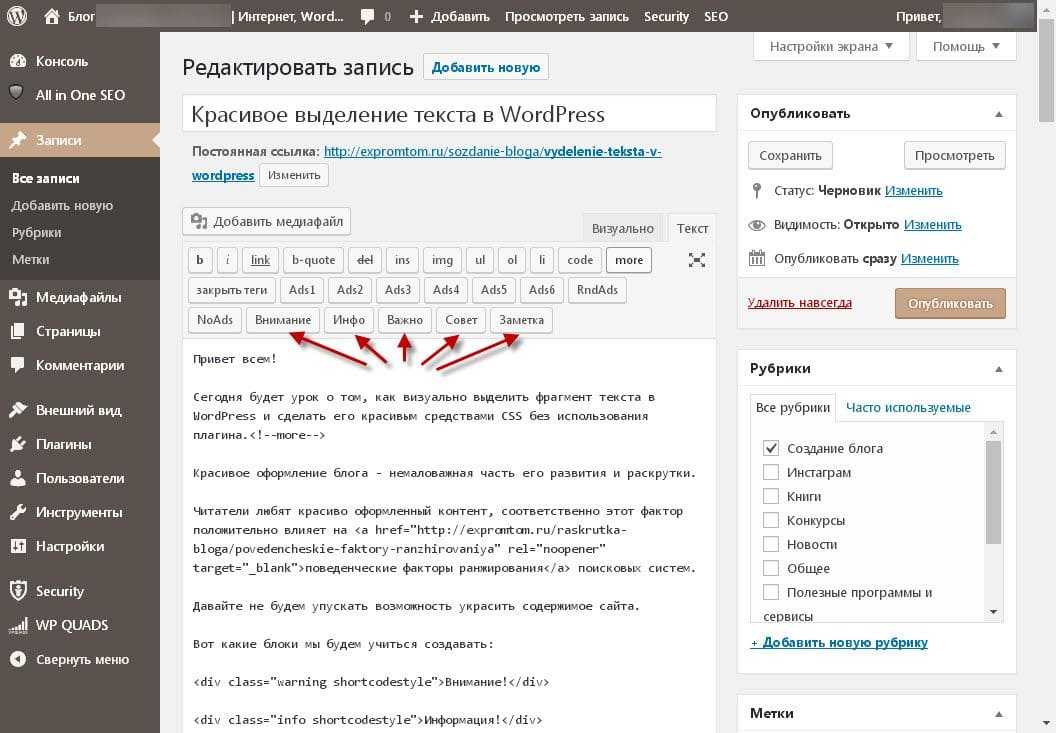

Для сайтов на WordPress еще нужно не забывать снять “галочку” запрета видимости для поисковика в разделе Настройки → Чтение.

Доступ к файлу роботс открывается по ссылке https://sitenametest.ua/robots.txt. Проверить его можно инструментами панели вебмастера, онлайн сервисами, например, этим, с помощью программ-парсеров — Screaming Frog либо Netpeak Spider. Решается проблема запрета индекса легко — достаточно удалить блокирующие условия и отправить запрос на обновление robots.txt.

Файл sitemap.xml нужен для взаимодействия вашего онлайн-ресурса с поисковиком. Он сообщает ему о важных страницах и рекомендуемой частоте повторного сканирования. Конечно, поисковый бот способен обойти web-сайт и без карты sitemap.xml, но ее наличие считается хорошей практикой и упрощает работу Гугла, Яндекса, Бинга и прочих поисковых систем. Проверить карту онлайн-ресурса можно через панель вебмастера либо по ссылке https://sitenametest. com/sitemap.xml. В Search Console можно заодно и запросить переобход поисковиком в разделе “Файлы Sitemap”.

com/sitemap.xml. В Search Console можно заодно и запросить переобход поисковиком в разделе “Файлы Sitemap”.

Так вы сможете проиндексировать сайт в Гугл быстрее. Карта sitemap.xml чаще всего создается плагином с поддержкой автообновления, чтобы все новые публикации сразу же добавлялись в нее. Если у web-ресурса sitemap отсутствует, это может негативно сказаться на индексации, поэтому рекомендуем добавить его на хостинг.

Файл .htaccess предназначается для сервера и содержит правила его работы. Обычно он размещается в корне:

- сервера — /public_html

- онлайн-сайта — /public_html/sitenametest.ua/

Посредством правил, содержащихся в .htaccess, можно закрыть индексирование, запрещая:

order allow, deny

deny from all

allow from IP

или разрешая:

order allow, deny

deny from UndesiredIP

allow from all

доступ всем пользователям, кроме определенного IP.

Рекомендуем проанализировать . htaccess, быть может, в нем окажутся запрещающие индекс правила.

htaccess, быть может, в нем окажутся запрещающие индекс правила.

Просмотрите теги meta name «robots» и rel=”canonical”

Сайт не индексируется в Гугле? Проблема может крыться в неправильных тегах роботс или неверном указании канонических веб-страниц. Если в хедере вы вдруг обнаружите meta name=“robots” content=“noindex, nofollow” — значит, ресурс закрыт, и поисковик лишен возможности сканирования. Выполнить проверку тега роботс можно в панели вебмастера в категории “Покрытие” или посредством программ-парсеров, например, Screaming Frog.

Решение простое и вполне логичное — удалить мета теги noindex, nofollow там, где они не нужны. Если результата нет, рекомендуем заглянуть на сервер, и проверить HTTP-ответы тега X‑Robots.

Если вы обнаружите там такую директиву

HTTP / 1.1 200 OK

Date: Tue, 25 May 2021 23:31:10 GMT

X-Robots-Tag: noindex

значит, ресурс закрыт и не индексируется.

Следовательно, урлы, которым необходимо попасть в индекс, не должны возвращать HTTP-ответ “noindex”. В Apache данная директива добавляется через .htaccess. На Nginx — в conf. HTTP-ответы проверяются также, как и теги роботс — через панель вебмастера в отчете проверки url или же парсерами.

В Apache данная директива добавляется через .htaccess. На Nginx — в conf. HTTP-ответы проверяются также, как и теги роботс — через панель вебмастера в отчете проверки url или же парсерами.

Атрибут rel=”canonical” является еще одним аспектом, влияющим на индексацию ресурса. Обычно используется автореферентный каноникал, сообщающий поисковикам о том, что веб-страница — основная, т.н. каноническая, и представлена в единственном варианте. Тег link rel=»canonical» задействуется при SEO продвижении сайта в поисковых системах с целью устранения дублей контента. Так вот, в некоторых случаях он может препятствовать индексации, а именно, когда для проверяемого url в качестве канонической выбрана иная, либо несуществующая страница. В таком случае будет статус Canonicalised, Non-Indexable.

Следовательно, избежать некачественной индексации поможет грамотное использование атрибута ”canonical”. Проверьте наличие и корректность каноничности для найденных неиндексируемых страниц, и если хотите “скормить” их поисковому боту, настройте тег правильно.

Проверьте скорость и правильность ответов сервера

Гугл или Яндекс не индексирует сайт, хотя предыдущие причины проверены и устранены? Проверьте скорость отрисовки контента. Бывает, такие страницы не попадают в базу данных поисковой системы из-за медленной загрузки. Причина этого может крыться в слабой оптимизации кода или нестабильном хостинге. Боты попросту не могут получить ответ на свой запрос, и покидают веб-страницу еще до загрузки основного контента. Что делать в таком случае? Стремиться сократить время ответа сервера до первого байта TTFB до 200 мс. В целом, чем меньше, тем лучше. Главное, — не более 500 мс. TTFB свыше 500 мс является проблемой.

Для проверки скорости существует множество сервисов, выбирайте наиболее удобный для вас:

- web site optimization,

- pingdom tools,

- loading.express,

- dotcom-tools,

- sitespeed,

- webmaster.yandex,

- gtmetrix,

- webpagetest,

- pagespeed insights.

Среди причин замедленного ответа сервера чаще всего наблюдаются следующие:

- Не настроена скорость загрузки интернет-сайта, картинки не сжаты, блокирующие ресурсы не устранены, файлы и скрипты CSS/JS не минимизированы.

- Не оптимизирован функционал сервера, не настроены базы данных.

- Отсутствует кеширование.

- Слабая мощность сервера, мало памяти, низкая производительность процессора, некачественный хостинг.

Что касается серверного ответа, то все инет-страницы в доступном состоянии должны иметь код 200. Если наблюдаются проблемы, — появляются ошибки 5хх. Проверяются коды ответа парсерами, например, Screaming Frog, сторонними online-сервисами — httpstatus.io и др., через панель вебмастера, с помощью браузера — комбинация F12 + вкладка Network.

Убедитесь, что web-страница уникальна, полезна, не “сирота”, не дубль

Когда технические проблемы индексации не найдены, возможно, проблема кроется в недостаточной уникальности, ценности, полезности содержимого. Дело в том, что Google предпочитает демонстрировать качественный контент, максимально релевантный ключевым запросам пользователей и соответствующий принципам E-A-T. Рекомендуем убедиться в том, что проверяемая онлайн-страница несет ценность для посетителей онлайн-ресурса. Если пользы нет, обновите контент, добавьте свежести, экспертности, повысьте уникальность содержимого, органично распределите ключевые запросы по тексту.

Дело в том, что Google предпочитает демонстрировать качественный контент, максимально релевантный ключевым запросам пользователей и соответствующий принципам E-A-T. Рекомендуем убедиться в том, что проверяемая онлайн-страница несет ценность для посетителей онлайн-ресурса. Если пользы нет, обновите контент, добавьте свежести, экспертности, повысьте уникальность содержимого, органично распределите ключевые запросы по тексту.

Как правило, бесполезной является любая web-page, на которой размещен:

- текст, сгенерированный автоматически;

- дублирующийся контент;

- копипаст;

- контент, заспамленный исходящими url;

- текст, не имеющий смысловой нагрузки, обильно снабженный ключевыми словами.

Также к некачественным веб-страницам относятся дорвеи, используемые для продвижения методом черного SEO.

Касаемо страниц-сирот, их особенностью является отсутствие каких-либо входящих ссылок, как в пределах вашего интернет-ресурса, так и с посторонних веб-платформ. Поскольку боты поисковой системы ищут новый контент, переходя поочередно между страницами, они, собственно, как и пользователи, не могут найти страницы-сироты. Проверить наличие “сирот”, как и дублей, можно парсерами. Только в первом случае нужно будет количество всех просканированных страниц сравнить со списком урлов, выгруженных через CMS. Страницы, не найденные при парсинге, и окажутся искомыми “сиротами”.

Поскольку боты поисковой системы ищут новый контент, переходя поочередно между страницами, они, собственно, как и пользователи, не могут найти страницы-сироты. Проверить наличие “сирот”, как и дублей, можно парсерами. Только в первом случае нужно будет количество всех просканированных страниц сравнить со списком урлов, выгруженных через CMS. Страницы, не найденные при парсинге, и окажутся искомыми “сиротами”.

Исключите фактор влияния поисковика: фильтр, технические проблемы

При неправильной стратегии продвижения интернет-ресурс может попасть в бан, получив санкции со стороны поисковика. В таком случае Google не индексирует сайт, и это одна из причин его отсутствия в органической выдаче. Поисковики, как правило, блокируют онлайн ресурсы в трех случаях:

- заспамленность ключевыми фразами,

- бесполезный контент или дорвей,

- низкокачественные бэклинки.

Проверить наличие санкций можно в Search Console в меню “Проблемы безопасности и принятые вручную меры”. Если фильтра нет, причиной слабой индексации контента могут быть технические проблемы на стороне поисковой системы. Например, в мае 2020 года случился сбой, повлекший за собой проблемы индексирования нового контента. Обычно такие ситуации оперативно выявляются и устраняются техподдержкой поисковика.

Если фильтра нет, причиной слабой индексации контента могут быть технические проблемы на стороне поисковой системы. Например, в мае 2020 года случился сбой, повлекший за собой проблемы индексирования нового контента. Обычно такие ситуации оперативно выявляются и устраняются техподдержкой поисковика.

Проверьте доменное имя: молодой сайт либо домен с историей

Как известно, новые онлайн-ресурсы, созданные менее чем полгода назад, не особо известны поисковикам, и без добавления в индекс через панель вебмастера боты будут долго находить их. Чем быстрее вы уведомите Google о вашем web-ресурсе и отправите его на переобход, тем скорее они появятся в поисковой выдаче.

Второй вариант — использование домена с историей. Покупка дроп-доменов вообще дело рискованное. Если предыдущий владелец доменного имени успел “наследить”, и получить санкции, загнав ресурс под фильтры поисковика, вам придется пожинать плоды его стараний. При этом новый онлайн-сайт будет плохо индексироваться. Покупая старый домен важно тщательно проверять его, изучая историю и ресурсы, ранее расположенные там.

Покупая старый домен важно тщательно проверять его, изучая историю и ресурсы, ранее расположенные там.

Проанализируйте ссылки, как внешние, так и внутренние

Ссылочная масса — один из ключевых факторов ранжирования, сообщающий поисковому боту о том, что web-ресурс популярен, и на него ссылаются другие веб-платформы. Да, в индексе присутствует множество страниц без обратных ссылок, но поисковик все же отдает предпочтение ресурсам с хорошей ссылочной массой. В результате быстрее индексируются страницы с качественными обратными ссылками.

Что касается внутренней перелинковки, рекомендуется избегать использования атрибута rel=“nofollow” для урлов внутри веб-сайта. Во-первых, Гугл не переходит по таким ссылкам. Во-вторых, данный атрибут препятствует передаче PageRank целевому url. Как результат, страница с nofollow-ссылкой сможет попасть в базу поисковика только если на нее ведет урл со стороннего ресурса, не отмеченный данным атрибутом.

Чтобы избежать проблем, нужно грамотно настраивать перелинковку, размещая несколько ссылок на целевую страницу. Допустим, в статьях блога о разработке интернет-ресурсов, размещать ссылку на страницу услуги, увеличивая ее внутренний вес. В свою очередь, rel=“nofollow” рекомендуется добавлять к исходящим ссылкам, например, на соцсети, чтобы не передавать им вес своего онлайн-сайта.

Допустим, в статьях блога о разработке интернет-ресурсов, размещать ссылку на страницу услуги, увеличивая ее внутренний вес. В свою очередь, rel=“nofollow” рекомендуется добавлять к исходящим ссылкам, например, на соцсети, чтобы не передавать им вес своего онлайн-сайта.

Подытоживая сказанное

Да, что-то мы разогнались… получился в итоге реальный лонгрид, информирующий о том, как проверить, есть ли страница в индексе Google, и сообщающий о возможных причинах отсутствия индексации. Вместо резюме предлагаем чек-лист, что нужно проверить на сайте, если у него плохая индексация:

- файлы robots.txt, sitemap.xml и .htaccess;

- теги meta name «robots» и rel=”canonical”;

- скорость и ответ сервера;

- контент: уникальность, полезность, экспертность;

- фильтр и технические проблемы со стороны поисковика;

- качество домена;

- ссылки: внешние и внутренние.

Если у вас нет времени на проверку, либо какие-то аспекты вызывают у вас трудности, вы можете в любой момент обратиться в наше digital-агентство, и заказать комплексный аудит с акцентом на поиск проблем индексирования сайта.

14 главных причин, почему Google не индексирует ваш сайт

Google не будет индексировать ваш сайт? Ты не одинок. Существует множество потенциальных проблем, которые могут помешать Google индексировать веб-страницы, и в этой статье рассматриваются 14 из них.

Если вы хотите знать, что делать, если ваш сайт не оптимизирован для мобильных устройств или вы столкнулись со сложными проблемами индексации, у нас есть информация, которая вам нужна.

Узнайте, как устранить эти распространенные проблемы, чтобы Google снова начал индексировать ваши страницы.

1. У вас нет доменного имени

Первая причина, по которой Google не будет индексировать ваш сайт, заключается в том, что у вас нет доменного имени. Это может быть связано с тем, что вы используете неправильный URL-адрес для контента или он неправильно настроен в WordPress.

Если это происходит с вами, есть несколько простых решений.

Проверьте, не начинается ли ваш веб-адрес с «https://XXX. XXX…», что означает, что кто-то может вводить IP-адрес вместо имени домена и перенаправляться на ваш веб-сайт.

XXX…», что означает, что кто-то может вводить IP-адрес вместо имени домена и перенаправляться на ваш веб-сайт.

Кроме того, возможно, неправильно настроено перенаправление вашего IP-адреса.

Один из способов решить эту проблему — добавить переадресацию 301 с WWW-версий страниц обратно на соответствующие домены. Если люди перенаправляются сюда, когда пытаются найти что-то вроде [yoursitehere], мы хотим, чтобы они попали на ваше физическое доменное имя.

Важно убедиться, что у вас есть доменное имя. Это не подлежит обсуждению, если вы хотите занимать высокие позиции и быть конкурентоспособными в Google.

2. Ваш сайт не оптимизирован для мобильных устройств

Веб-сайт, адаптированный для мобильных устройств, имеет решающее значение для индексации вашего сайта Google, поскольку он ввел индексирование Mobile-First.

Независимо от того, насколько хорош контент на вашем веб-сайте, если он не оптимизирован для просмотра на смартфоне или планшете, вы потеряете рейтинг и трафик.

Оптимизация для мобильных устройств не должна быть сложной — простое добавление принципов адаптивного дизайна, таких как плавающие сетки и CSS Media Queries, может значительно помочь пользователям найти то, что им нужно, без каких-либо проблем с навигацией.

Первое, что я рекомендую сделать с этой проблемой, — запустить ваш сайт с помощью Google Mobile-Friendly Testing Tool.

Если вы не получили «пройдено чтение», вам нужно проделать некоторую работу, чтобы сделать ваш сайт удобным для мобильных устройств.

3. Вы используете язык кодирования слишком сложным для Google способом

Google не будет индексировать ваш сайт, если вы используете язык кодирования сложным образом. Неважно, какой язык — он может быть старым или даже обновленным, как JavaScript — если настройки неверны и вызывают проблемы со сканированием и индексированием.

Если это проблема для вас, я рекомендую запустить Google Mobile-Friendly Testing Tool, чтобы увидеть, насколько ваш сайт действительно удобен для мобильных устройств (и внести любые исправления, которые могут потребоваться).

Если ваш веб-сайт еще не соответствует их стандартам, они предлагают множество ресурсов с рекомендациями по всевозможным причудам дизайна, которые могут возникнуть при разработке адаптивной веб-страницы.

4. Ваш сайт загружается медленно

Сайты с медленной загрузкой снижают вероятность того, что Google захочет, чтобы они отображались в верхних результатах индекса. Если ваш сайт долго загружается, это может быть связано со многими различными факторами.

Возможно даже, что у вас слишком много контента на странице для браузера пользователя, или если вы используете старомодный сервер с ограниченными ресурсами.

Решения:

- Используйте Google Page Speed Insights . Это один из моих любимых инструментов, который я нашел за последние годы, и он помогает мне определить, какие разделы веб-сайта требуют срочного внимания при повышении его скорости. Инструмент анализирует вашу веб-страницу в соответствии с пятью лучшими рекомендациями по производительности (которые имеют решающее значение для более быстрой загрузки сайтов), такими как минимизация подключений, уменьшение размера полезной нагрузки, использование кэширования браузера и т.

д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт.

д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт. - Используйте такой инструмент, как webpagetest.org . Этот инструмент сообщит вам, загружается ли ваш сайт достаточно быстро. Это также позволит вам подробно увидеть конкретные элементы на вашем сайте, которые вызывают у вас проблемы. Их водопад может помочь вам определить серьезные проблемы со скоростью страницы до того, как они вызовут серьезные проблемы.

- Снова используйте аналитику Google Page Speed — Посмотрите, где можно улучшить время загрузки сайта. Например, возможно, стоит изучить новый план хостинга с большим количеством ресурсов (чистые выделенные серверы намного лучше, чем общие) или использовать службу CDN, которая будет обслуживать статический контент из своего кеша в нескольких местах по всему миру.

В идеале, убедитесь, что скорость вашей страницы достигает 70 или выше. В идеале как можно ближе к 100.

Если у вас есть какие-либо вопросы относительно скорости страницы, вы можете ознакомиться с электронной книгой SEJ о Core Web Vitals.

5. На вашем сайте минимум хорошо написанного контента

Хорошо написанный контент имеет решающее значение для успеха в Google. Если у вас есть минимальный контент, который, по крайней мере, не соответствует уровню ваших конкурентов, у вас могут быть серьезные проблемы даже с попаданием в топ-50.

По нашему опыту, контент, содержащий менее 1000 слов, не так эффективен, как контент, содержащий более 1000 слов.

Являемся ли мы компанией по написанию контента? Нет, мы не. Является ли количество слов фактором ранжирования? Также нет.

Но когда вы решаете, что делать в контексте конкурса, убедитесь, что ваш контент хорошо написан, это ключ к успеху.

Содержание вашего сайта должно быть качественным и информативным. Он должен отвечать на вопросы, предоставлять информацию или иметь точку зрения, которая достаточно отличается от других сайтов в той же нише, что и ваша.

Если он не соответствует этим стандартам, Google, скорее всего, найдет другой сайт с более качественным контентом, который им соответствует.

Если вам интересно, почему ваш веб-сайт не занимает высокие позиции в результатах поиска Google по некоторым ключевым словам, несмотря на то, что он следует рекомендациям SEO, таким как добавление релевантных ключевых слов по всему тексту (Подсказка: ваш контент), тогда одним из виновников могут быть тонкие страницы, где на странице действительно должно быть больше 100 слов!

Тонкие страницы могут вызвать проблемы с индексацией, поскольку они не содержат много уникального контента и не соответствуют минимальным уровням качества по сравнению с вашими конкурентами.

6. Ваш сайт не удобен для пользователя и не привлекателен для посетителей

Наличие удобного и привлекательного сайта имеет решающее значение для хорошего SEO. Google повысит рейтинг вашего сайта в результатах поиска, если посетителям будет легко находить то, что они ищут, и перемещаться по веб-сайту, не чувствуя разочарования или раздражения.

Google не хочет, чтобы пользователи проводили слишком много времени на странице, которая либо долго загружается, либо имеет запутанную навигацию, либо просто неудобна в использовании, потому что слишком много отвлекающих факторов (например, реклама в верхней части страницы).

Если в каждой категории указан только один продукт вместо нескольких, возможно, именно поэтому ваш контент плохо ранжируется в Google! Важно не только настроить таргетинг на ключевые слова в каждом посте, но и убедиться, что все связанные посты ссылаются на другие соответствующие статьи/страницы по теме.

Нравится ли людям делиться вашим блогом? Читатели поражены вашим контентом? Если нет, то это может быть причиной того, что Google перестал индексировать ваш сайт.

Если кто-то ссылается непосредственно на одну конкретную страницу продукта, а не использует относительные ключевые слова, такие как «купить», «купить» и т. д., возможно, что-то не так с тем, как другие страницы ссылаются на этот конкретный продукт.

Убедитесь, что все продукты, перечисленные на страницах категорий, также существуют в каждой соответствующей подкатегории, чтобы пользователи могли легко совершать покупки без необходимости перемещаться по сложной иерархии ссылок.

7. У вас есть цикл перенаправления

Циклы перенаправления — еще одна распространенная проблема, препятствующая индексации. Обычно они вызваны распространенной опечаткой и могут быть исправлены с помощью следующих шагов:

Обычно они вызваны распространенной опечаткой и могут быть исправлены с помощью следующих шагов:

Найдите страницу, вызывающую цикл перенаправления. Если вы используете WordPress, найдите исходный HTML-код одного из ваших сообщений на этой странице или в файле .htaccess и найдите «Перенаправление 301», чтобы увидеть, с какой страницы он пытается направить трафик. Также стоит исправить все перенаправления 302 и убедиться, что они установлены на 301.

Используйте «найти» в проводнике Windows (или Command + F, если Mac) для поиска во всех файлах, содержащих «перенаправление», пока не обнаружите, в чем проблема.

Исправьте любые опечатки, чтобы дублирующийся URL-адрес не указывал на себя, а затем используйте код перенаправления, как показано ниже:

Коды состояния, такие как 404, не всегда отображаются в Google Search Console. Используя внешний сканер, такой как Screaming Frog, вы можете найти коды состояния для 404 и других ошибок.

Если все выглядит хорошо, используйте Google Search Console на месте, чтобы снова просканировать сайт и повторно отправить его на индексацию. Подождите неделю или около того, прежде чем снова зайти в Google Search Console, если появятся какие-либо новые предупреждения, требующие внимания.

Подождите неделю или около того, прежде чем снова зайти в Google Search Console, если появятся какие-либо новые предупреждения, требующие внимания.

У Google нет времени обновлять свои индексы каждый день, но они делают это каждые несколько часов, что означает, что иногда ваш контент может отображаться не сразу, даже если вы знаете, что он был обновлен. Потерпи! Вскоре он должен быть проиндексирован.

8. Вы используете плагины, которые блокируют сканирование вашего сайта роботом Googlebot

Одним из примеров такого плагина является плагин robots.txt. Если с помощью этого плагина вы установите для файла robots.txt запрет на индексирование своего сайта, робот Googlebot не сможет его просканировать.

Настройте файл robots.txt и выполните следующие действия:

При создании сделайте его общедоступным, чтобы поисковые роботы могли получить к нему доступ без ограничений.

Убедитесь, что в файле robots.txt нет следующих строк:

User-agent: * Disallow: /

Слэш означает, что файл robots. txt блокирует все страницы из корневой папки сайта. Вы хотите убедиться, что ваш файл robots.txt выглядит примерно так:

txt блокирует все страницы из корневой папки сайта. Вы хотите убедиться, что ваш файл robots.txt выглядит примерно так:

User-agent: * Запретить:

Если строка запрета пуста, это означает, что поисковые роботы могут сканировать и индексировать каждую страницу вашего сайта без ограничений (при условии, что у вас нет определенных страниц, помеченных как не индексируемые).

9. Ваш сайт использует JavaScript для Render Content

Использование JavaScript само по себе не всегда является сложной проблемой, которая вызывает проблемы с индексацией. Не существует единого правила, которое говорит, что JS — это единственное, что вызывает проблемы. Вы должны смотреть на отдельный сайт и диагностировать проблемы, чтобы определить если это проблема

Когда JS вступает в игру как проблема, это когда JS предотвращает сканирование, выполняя сомнительные действия — методы, которые могут быть похожи на маскировку.

Если у вас есть обработанный HTML, а не необработанный HTML, и у вас есть ссылка в необработанном HTML, которой нет в обработанном HTML, Google не может сканировать или индексировать эту ссылку. Определение проблем отображаемого HTML и необработанного HTML имеет решающее значение из-за ошибок такого типа.

Определение проблем отображаемого HTML и необработанного HTML имеет решающее значение из-за ошибок такого типа.

Если вы хотите скрыть файлы JS и CSS, не делайте этого. Google упомянул, что хочет видеть все ваши файлы JS и CSS при сканировании.

Google хочет, чтобы вы сохранили возможность сканирования всех JS и CSS. Если какие-либо из этих файлов у вас заблокированы, вы можете разблокировать их и разрешить полное сканирование, чтобы предоставить Google нужное представление о вашем сайте.

10. Вы не добавили все свойства домена в Google Search Console

Если у вас более одного варианта домена, особенно в ситуации, когда вы мигрировали с http:// на https://, вы должны все варианты вашего домена добавлены и проверены в Google Search Console.

Важно убедиться, что вы не пропустили ни один из вариантов домена при их добавлении в GSC.

Добавьте их в GSC и убедитесь, что вы подтвердили право собственности на все свойства домена, чтобы убедиться, что вы отслеживаете правильные.

Для новых сайтов, которые только начинают свою работу, это, скорее всего, не будет проблемой.

11. Ваши метатеги установлены на Noindex, Nofollow

Иногда, по чистой случайности, метатеги установлены на noindex, nofollow. Например, на вашем сайте может быть ссылка или страница, которая была проиндексирована поисковым роботом Google, а затем удалена до перехода на noindex, nofollow был правильно настроен в серверной части вашего сайта.

В результате эта страница, возможно, не была повторно проиндексирована, и если вы используете плагин для блокировки Google от сканирования вашего сайта, эта страница может больше никогда не быть проиндексирована.

Решение простое: измените любые метатеги со словами noindex,nofollow, чтобы они читались как index, вместо этого следуйте.

Однако, если у вас есть тысячи подобных страниц, вам, возможно, предстоит тяжелая битва. Это один из тех моментов, когда вы должны стиснуть зубы и двигаться вперед с трудом.

В конце концов, производительность вашего сайта скажет вам спасибо.

12. Вы не используете карту сайта

Вам необходимо использовать карту сайта!

Карта сайта — это список всех страниц вашего сайта, а также один из способов для Google узнать, какой у вас контент. Этот инструмент поможет гарантировать, что каждая страница будет просканирована и проиндексирована консолью поиска Google.

Если у вас нет карты сайта, Google работает вслепую, если только все ваши страницы в настоящее время не проиндексированы и не получают трафик.

Однако важно отметить, что файлы Sitemap в формате HTML устарели в Google Search Console. В настоящее время предпочтительным форматом файлов Sitemap являются XML Sitemaps.

Вы хотите использовать свою карту сайта, чтобы сообщить Google, какие страницы вашего сайта являются важными, и вы хотите регулярно отправлять ее для сканирования и индексации.

13. Вы были наказаны Google в прошлом и до сих пор не исправили свои действия

Google неоднократно заявлял, что штрафы могут последовать за вами.

Если у вас уже был штраф и вы не исправили свой поступок, то Google не будет индексировать ваш сайт.

Ответ на этот вопрос довольно прост: если это наказывает Google, они могут ничего не сделать, потому что штрафы следуют за вами повсюду, как незваный друг, который волочит ноги по ковру, проходя через каждую комнату. твой дом.

Если вам интересно, зачем вам по-прежнему исключать некоторую информацию со своего веб-сайта, если у вас уже есть проблемы с поисковыми системами?

Дело в том, что несмотря на то, что есть способы избежать наказания, многие люди не знают, или уже не могут вносить эти изменения по каким-либо причинам (может быть, они продали свою компанию). Некоторые также думают, что простое удаление страниц и добавление старого контента на новый сайт будет работать так же хорошо (это не так).

Если вас оштрафовали, самый безопасный путь — полностью исправить свой поступок. У вас должен быть совершенно новый контент, и вы должны перестроить домен с нуля или провести полную перестройку контента. Google объясняет, что они ожидают, что вам потребуется столько же времени, чтобы уйти от штрафа, сколько потребовалось, чтобы вы попали в него.

Google объясняет, что они ожидают, что вам потребуется столько же времени, чтобы уйти от штрафа, сколько потребовалось, чтобы вы попали в него.

14. Ваше техническое SEO ужасно

Не заблуждайтесь: покупка технического SEO на Fiverr.com похожа на покупку Lamborghini в магазине за доллар: вы, скорее всего, получите подделку, а не настоящую вещь.

Правильное техническое SEO того стоит: Google и ваши пользователи полюбят вас.

Давайте рассмотрим некоторые распространенные проблемы и решения, а также то, где вам может помочь техническое SEO.

Проблема: Ваш сайт не достигает показателей Core Web Vitals

Решение: Техническая поисковая оптимизация поможет вам определить проблемы с основными показателями работы сети и предоставит вам путь к их устранению. Не полагайтесь только на стратегический аудит — он не всегда поможет вам в этих областях. Вам нужен полный технический SEO-аудит, чтобы выявить некоторые из этих проблем, потому что они могут варьироваться от совершенно простых до невероятно сложных.

Проблема: Проблемы со сканированием и индексированием вашего сайта

Решение: Они могут быть невероятно сложными, и для их обнаружения и исправления требуется опытный специалист по технической оптимизации. Вы должны определить их, если обнаружите, что у вас нулевая тяга или вы не получаете никакой производительности от своего сайта.

Также убедитесь, что вы случайно не поставили галочку в поле «запрещать поисковым системам индексировать ваш сайт» в WordPress.

Проблема: Файл robots.txt вашего сайта каким-то образом непреднамеренно блокирует доступ поисковых роботов к важным файлам

Решение: Опять же, техническое SEO здесь, чтобы спасти вас из бездны. Некоторые сайты находятся в таком глубоком упадке, что вы не видите другого выхода, кроме как удалить сайт и начать заново. Ядерный вариант не всегда лучший вариант. Именно здесь опытный технический SEO-специалист на вес золота.

Выявление проблем с индексацией веб-сайта — сложная задача, но ее стоит решить

Контент, техническое SEO и ссылки — все это важно для поддержания траектории производительности вашего сайта. Но если у вашего сайта есть проблемы с индексацией, другие элементы SEO не помогут вам.

Не забудьте поставить галочки во всех полях и убедиться, что вы действительно продвигаете свой сайт самым правильным образом.

И не забудьте оптимизировать каждую страницу вашего сайта по релевантным ключевым словам! Также стоит убедиться, что ваше техническое SEO на должном уровне, потому что чем лучше Google сможет сканировать, индексировать и ранжировать ваш сайт, тем лучше будут ваши результаты.

Google (и трафик вашего сайта) будут вам благодарны.

Дополнительные ресурсы:

- 11 SEO-советов и приемов для улучшения индексации

- Как поисковые системы сканируют и индексируют: все, что вам нужно знать

- Как работают поисковые системы

Рекомендуемое изображение: Shutterstock/Sammby

Категория

SEO

Почему мой сайт не индексируется Google?

Последнее изменение:

09. 08.2022

08.2022

Время чтения:

Может быть очень обидно потратить время и деньги на свой сайт и, в конце концов, увидеть, что он не ранжируется в Google.

Вы, вероятно, думаете, что все сделали правильно — у вас есть страницы, дизайн, контент, и все это прекрасно работает.

Вы все перепроверяете, но все равно удивляетесь:

Почему мой сайт не отображается в Google?!

Что ж, когда дело доходит до поисковой оптимизации, многое может пойти не так, даже если вы делаете все по инструкции и регулярно пересматриваете свой контрольный список SEO.

Если у вас есть какие-либо сомнения, первое, что вы должны проверить, это правильно ли Google индексирует ваши страницы.

В конце концов, если ваш сайт не проиндексирован, ваши клиенты не смогут найти его в Google, а это может поставить под угрозу все ваши усилия по цифровому маркетингу.

В этой статье мы выделяем наиболее распространенные причины, по которым страницы не индексируются Google, и предлагаем практические решения.

Читайте дальше!

Проиндексирован ли мой сайт?

Согласно Google «индексация»:

Страница индексируется Google, если она была посещена поисковым роботом Google («Googlebot»), проанализирована на содержание и значение и сохранена в индексе Google. Проиндексированные страницы могут отображаться в результатах поиска Google (если они соответствуют рекомендациям Google для веб-мастеров). Хотя большинство страниц сканируется перед индексированием, Google также может индексировать страницы без доступа к их содержанию (например, если страница заблокирована директивой robots.txt).

Как видно из определения, вам необходимо следовать определенным правилам, называемым рекомендациями Google для веб-мастеров, чтобы ваш веб-сайт «сохранился» в базе данных или индексе Google. После того как ваш веб-сайт будет проиндексирован, Google может показать вашу страницу пользователям, которые выполняют запросы с использованием релевантных ключевых слов.

Однако иногда, даже если вы следуете рекомендациям Google, ваш сайт может неправильно индексироваться и, следовательно, не отображаться в результатах поиска Google. Этому может быть несколько причин.

Хорошая новость заключается в том, что все это можно исправить.

Почему мой сайт не отображается в Google?

Прежде чем мы углубимся в детали, давайте уточним, что ваш веб-сайт может быть проиндексирован, но по-прежнему не отображаться в Google.

Это потому, что индекс Google — это просто индекс. Боты сканируют и составляют список страниц, которые они посещают, вместе с соответствующей информацией об их значении, содержании и качестве. Как только пользователь вводит запрос в поисковую систему, алгоритм сопоставляет его запрос со страницами в индексе.

Если ваша страница подходит, она может появиться в поисковой выдаче.

Однако, если есть веб-сайты с более качественным контентом, более высокими техническими стандартами, улучшенным UX и авторитетом, алгоритм может предпочесть их вашим.

Это может повлиять на ваш рейтинг и привести к тому, что вы, в конце концов, выпадете из поисковой выдачи.

Но есть проблемы, из-за которых ваш веб-сайт вообще не отображается в Google:

Ваш веб-сайт новый

Если вы только что создали и запустили свой веб-сайт, ему нужно время, чтобы появиться в результатах поиска.

Довольно часто новые веб-сайты не индексируются. Фактически, индексация ваших страниц Google может занять несколько недель.

Вы не сделали ничего плохого, просто Google нужно время, чтобы просканировать ваш новый веб-сайт и включить его в свой индекс, поэтому не ожидайте, что ваш веб-сайт сразу же появится на первой странице поисковой выдачи.

Есть простой способ проверить, знает ли Google о существовании вашего веб-сайта. Вы можете выполнить поиск по:

Site:yourdomain.com

Это пример с веб-сайтом DevriX:

DevriX.com — не новый веб-сайт, и, как вы видите, с ним связано более 1500 результатов.

Попробуйте сейчас со своим доменом и посмотрите на результаты. Имейте в виду, что если есть хотя бы один результат, это означает, что Google обнаружил ваш сайт. В случае отсутствия результатов Google может потребоваться больше времени для сканирования вашей страницы.

Тем не менее, есть кое-что, что вы можете сделать, чтобы улучшить свое ранжирование, ожидая, пока Google обнаружит ваш веб-сайт. Вы можете создать карту сайта и отправить ее через Google Search Console.

Карта сайта — это список страниц вашего веб-сайта, который помогает поисковым системам легко обнаруживать и сканировать ваш веб-сайт. Это жизненно важно для вашего SEO, поскольку оно сообщает Google, какие страницы важны на вашем сайте и где их найти. Поэтому лучше создать его как можно скорее.

Проверьте свой файл robots.txt

Существует так называемый файл robots.txt , который можно использовать для указания поисковым системам, где они могут или не могут посещать ваш сайт. Его можно найти/поместить в самый верхний каталог сайта.

Его можно найти/поместить в самый верхний каталог сайта.

Если вы заблокировали свой веб-сайт и сказали Google не сканировать определенные URL-адреса, то Google не будет посещать эти страницы, что обычно приводит к тому, что они не отображаются в результатах поиска.

Если вы отправили карту сайта через Google Search Console, она должна предупредить вас о проблемах, связанных с этим. Имейте в виду, что вы получите оповещения только в том случае, если боты Google попытаются просканировать ваши URL-адреса — если Google все еще не обнаружил ваш веб-сайт, этого не произойдет.

Еще один способ проверить, не блокирует ли ваш файл robots.txt ваши страницы, — ввести в браузере:

yourwebsite.com/robots.txt

Запретить показывает страницы, которые заблокированы от сканирования Google.

Проверьте, есть ли в вашем файле следующая команда:

Disallow: /

User-agent: *

User-agent: Googlebot

Это блокирует Google от сканирования вашего сайта. Кроме того, вы не хотите иметь «Запретить» для любой из ваших важных страниц, таких как ваш блог, страницы продуктов или страницы часто задаваемых вопросов. Это предотвратит их обнаружение Google. Если они не будут обнаружены, они не будут ранжироваться в Google, когда пользователь ищет ключевые слова, связанные с вашим сайтом, и, как следствие, новые пользователи могут не попасть на ваш сайт и не стать клиентами.

Кроме того, вы не хотите иметь «Запретить» для любой из ваших важных страниц, таких как ваш блог, страницы продуктов или страницы часто задаваемых вопросов. Это предотвратит их обнаружение Google. Если они не будут обнаружены, они не будут ранжироваться в Google, когда пользователь ищет ключевые слова, связанные с вашим сайтом, и, как следствие, новые пользователи могут не попасть на ваш сайт и не стать клиентами.

У вас недостаточно качественных обратных ссылок

Отсутствие качественных обратных ссылок может быть одной из причин, по которой ваш сайт не индексируется в Google.

Это правда, что сотни факторов играют роль в алгоритме Google, и никто точно не знает всех деталей системы ранжирования Google.

Однако известно, что качественные обратные ссылки являются довольно сильным фактором и серьезно влияют на ваш рейтинг. Фактически, они считаются одним из трех наиболее важных факторов ранжирования.

Существует простой способ проверить количество уникальных веб-сайтов, ссылающихся на ваши страницы. Существуют различные бесплатные или платные инструменты SEO, которые предоставляют вам эту информацию. Самый простой способ — использовать средство проверки обратных ссылок Ahrefs или Link Explorer от Moz.

Существуют различные бесплатные или платные инструменты SEO, которые предоставляют вам эту информацию. Самый простой способ — использовать средство проверки обратных ссылок Ahrefs или Link Explorer от Moz.

В этом примере мы будем использовать Ahrefs. Как только вы введете свой домен или URL-адрес в строку поиска, вы увидите, сколько существует уникальных ссылающихся доменов, ссылающихся на ваш сайт. См. столбец «Ссылающиеся домены» на скриншоте ниже.

В столбце показано, сколько уникальных ссылающихся доменов ссылаются на ваш сайт. Если ваш веб-сайт новый, у вас, скорее всего, будет очень низкое число.

Чтобы получить более четкое представление о том, сколько у вас должно быть ссылающихся доменов, вы можете сравнить их с вашими конкурентами. Анализ их веб-сайтов даст вам представление о том, с чего начать ваши кампании по созданию ссылок.

Однако при построении ссылок всегда помните о качестве, а не о количестве. У вас могут быть сотни некачественных и/или нерелевантных ссылок, но они не повысят ваш авторитет.

Между тем, несколько правильных ссылок могут иметь большое значение.

Вашему веб-сайту не хватает авторитета

Создание высококачественных ссылок связано с авторитетом вашего домена или рейтингом домена. Действует правило: чем больше качественных ссылок, тем выше авторитет.

Имейте в виду, что существуют разные инструменты для измерения рейтинга домена, и ваша оценка может варьироваться в зависимости от их данных и алгоритма.

Например, если вы хотите использовать средство проверки обратных ссылок Ahrefs, вы можете измерить рейтинг своего домена. Инструмент показывает силу профиля обратных ссылок веб-сайта по сравнению с другими в их базе данных по 100-балльной шкале.

На скриншоте ниже мы видим, что Content Marketing Institute имеет рейтинг домена 88, что является довольно хорошим числом, говорящим об его авторитете.

Инструмент SEO-анализа бесплатного домена от Moz использует другую методологию и измеряет рейтинг авторитетности вашего домена. Инструмент предоставляет информацию о том, какой веб-сайт будет занимать более высокое место в поисковой выдаче, измеряя связывающие корневые домены и количество качественных входящих и исходящих ссылок. Он также предсказывает, насколько хорошо сайт будет ранжироваться в результатах поиска.

Инструмент предоставляет информацию о том, какой веб-сайт будет занимать более высокое место в поисковой выдаче, измеряя связывающие корневые домены и количество качественных входящих и исходящих ссылок. Он также предсказывает, насколько хорошо сайт будет ранжироваться в результатах поиска.

Если мы проанализируем веб-сайт Content Marketing Institute с использованием Moz, то увидим, что показатель авторитетности домена равен 76.

Как видите, Moz показывает немного более низкий результат, потому что он использует другие данные и измеряет другие вещи, чем Ahrefs.

Вам решать, какой инструмент вы собираетесь использовать.

Вы можете сравнить свой результат с показателями конкурентов, чтобы лучше понять, сколько у них качественных обратных ссылок и насколько выше авторитет вашего домена должен «расти».

Какая связь между авторитетом вашего сайта и индексом Google?

Если у вашей страницы низкий авторитет домена, это может помешать вам занять более высокие позиции в Google. Опять же, если ваш веб-сайт новый, невозможно сразу получить авторитет домена, но вы можете немного повысить его с помощью двух простых стратегий:

Опять же, если ваш веб-сайт новый, невозможно сразу получить авторитет домена, но вы можете немного повысить его с помощью двух простых стратегий:

- Создание обратных ссылок

- Увеличить количество внутренних ссылок

Однако, отслеживая эти показатели и оценку SEO, имейте в виду, что они являются симптомом, а не проблемой, поэтому их повышение не является конечной целью. Вы должны использовать их для диагностики потенциальных проблем с вашим сайтом и поиска решений.

Ваш Google EAT неудовлетворителен

Обратные ссылки — не единственное, что определяет ваш авторитет. Фактически, в последнее время Google сосредоточился на группе факторов, называемых Google EAT, которые они используют для оценки качества вашего контента:

- Опыт

- Власть

- Надежность

Это особенно важно для страниц YMYL (Ваши деньги вашей жизни), которые касаются тем, которые могут оказать реальное влияние на пользователя, таких как банковское дело, налоги и деньги; поход по магазинам; Новости; политика; здоровье и благополучие; законы и юридические; и так далее.

Веб-сайты, публикующие такого рода информацию, должны ясно показывать, что она предоставлена заслуживающими доверия экспертами, которые являются авторитетом в своей области и имеют подтвержденный авторитет и могут нести за это ответственность.

Для этого вам необходимо:

- Работать над своей репутацией в Интернете. Убедитесь, что ваш веб-сайт не связан со слишком большим количеством негативных отзывов и негативных отзывов.

- Предоставьте контактную информацию. На вашем веб-сайте должны быть четкие и точные контактные данные с указанием того, кто за этим стоит и как человек может с ними связаться.

- Подтвердите свой опыт. Предоставьте информацию, которая показывает, что вы и/или лицо, предоставившее контент, являетесь экспертом — награды, образование, опыт и т. д.

- Предоставляйте ценный контент. Контент вашего веб-сайта должен быть осмысленным и представлять ценность для пользователей.

Недостаток EAT может повлиять на ваш рейтинг. Если Google сочтет ваш сайт некачественным, он, скорее всего, будет реже показывать его в результатах поиска.

Ваша веб-страница не соответствует «цели поиска»

Миссия Google — предоставить пользователю наиболее полезные и релевантные результаты. Вот почему важно согласовать ваш контент и стратегию ключевых слов с тем, что хочет видеть ваша целевая аудитория.

Вам необходимо предоставить выдающийся и ценный контент, который заинтересует вашу аудиторию и/или решит их проблемы. Google не будет ранжировать на первых страницах контент, который не является выдающимся и не помогает пользователям находить информацию, которую они ищут.

Для этого вам нужно сопоставить свои цели с намерениями пользователя. Как правило, существует 4 типа целей поиска:

- Информационные. Пользователь хочет изучить тему.

- Навигационная. Пользователь ищет определенный веб-сайт.

- Транзакционный. Пользователь хочет совершить покупку прямо сейчас.

- Коммерческий. Пользователь изучает продукты и услуги, чтобы принять решение о покупке.

Если пользователь хочет узнать больше по какой-то теме и сталкивается с фрагментом контента на вашем веб-сайте, который пытается продать продукт, он, скорее всего, будет отложен и уйдет навсегда.

Чтобы избежать этого, вам нужно использовать в своем контенте ключевые слова, которые соответствуют намерениям пользователя и его позиции на пути покупателя. Таким образом, вы обеспечите лучший UX, сохраните их на своем веб-сайте и улучшите SEO.

Чтобы устранить все проблемы, связанные с контентом, вам необходимо создать стратегию контент-маркетинга и привести ее в соответствие с потребностями ваших клиентов.

Вы можете запустить блог, в котором будете публиковать статьи на темы, интересные вашей целевой аудитории и отвечающие их потребностям. Вы также должны рассмотреть возможность предоставления учебных пособий или ответов на различные вопросы.

Вы также должны рассмотреть возможность предоставления учебных пособий или ответов на различные вопросы.

Вам необходимо поддерживать интерес целевой аудитории к вашему веб-сайту. Так вы улучшите свои позиции в поисковой выдаче.

Статья по теме: SEO на основе намерений: разумное управление трафиком на веб-сайте

На вашем веб-сайте дублируется контент

Дублированный контент — это когда одна и та же или похожая веб-страница доступна по разным URL-адресам. Представьте, что у вас есть две копии одной и той же книги. Вам они оба не нужны, верно?

Обычно Google не индексирует повторяющийся контент, потому что он занимает лишнее место в их индексе.

В этом случае чаще всего Google индексирует версию страницы, которая установлена как каноническая.

Тег canonical может препятствовать тому, чтобы поисковые системы ошибочно принимали определенные страницы за дублирующийся контент. Когда вы устанавливаете канонический тег, вы сообщаете ботам, какую версию URL вы хотите отображать в поиске.

Если вы не отметили, какая страница является канонической, Google попытается сделать это за вас. Что нехорошо, так как это может привести к еще большей путанице, и в результате боты могут даже сдаться и вообще не проиндексировать вашу страницу.

Чтобы проверить наличие дубликатов страниц на вашем веб-сайте, вы можете использовать некоторые из перечисленных здесь инструментов SEO.

Лучшие инструменты SEO и маркетинга для маркетологов

У вас есть штраф Google

Штрафы также могут помешать вашему веб-сайту занять место в результатах поиска Google.

Существует два типа санкций Google:

- Вручную: Google удаляет или понижает ваш сайт в результатах поиска. Это происходит, когда сотрудник Google вручную просматривает ваш веб-сайт и обнаруживает, что он не соответствует их Руководству для веб-мастеров.

- Алгоритмический: Это когда алгоритм Google блокирует веб-сайт или веб-страницу из-за проблем с качеством.

Что включают в себя штрафы Google?

- Деиндексировано: Google полностью удаляет ваш домен из своего индекса.

- Штраф: Ваш домен все еще существует в индексе, но вы не можете найти свою страницу, если будете искать ее напрямую.

Как исправить штраф Google?

Если у вас есть штраф, вы получите сообщение в Google Search Console. Если это произойдет, вам необходимо следовать рекомендациям Google и отправить свой веб-сайт на повторное рассмотрение, чтобы вернуться в Google.

Подведение итогов

Органический трафик имеет жизненно важное значение для вашей цифровой стратегии и может помочь вам повысить свое цифровое присутствие, расширить охват и привлечь новую аудиторию.

Однако, чтобы все это произошло, ваш сайт должен быть проиндексирован и отображаться в поиске Google.

Вот почему важно следить за всеми важными деталями, которые мы перечислили в этой статье.

txt, sitemap.xml и .htaccess

txt, sitemap.xml и .htaccess

д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт.

д., и дает вам предложения о том, как вы можете улучшить каждый аспект. твой сайт.