Содержание

Правильный файл robots.txt для Joomla

Автор: Нотан Ройамов

Создано:

Обновлено:

Оценка:

Комментарии: 3

Разбор примеров файла robots.txt для сайтов на CMS Joomla: создание правил для исключения индексации страниц в зависимости от установленных компонентов и общих особенностей структуры URL-адресов в Joomla.

Содержание

Современные CMS по умолчанию предусматривают наличие файла robots.txt в корне сайта, в том числе и Joomla. Рассмотрим стандартные примеры файлов robots.txt для Joomla разных версий, а также разберем варианты их оптимизации в зависимости от необходимости.

Рассмотрим стандартные примеры файлов robots.txt для Joomla разных версий, а также разберем варианты их оптимизации в зависимости от необходимости.

Пример robots.txt для Joomla 3

Прогресс не стоит на месте, и Joomla 3-й серии не исключение. Относительно версии 2.5, Joomla 3 отличается улучшенным функционалом, в том числе в отношении SEO. В частности это касается файла robots.txt: его не придется переименовывать, опасаясь, что файл «обнулится» при обновлении CMS, к тому же в файле исправлены «косяки», которые наблюдались в robots.txt для Joomla 2.5 по умолчанию.

Запрет индексирования системных каталогов

Файл robots.txt в Joomla 3 по умолчанию содержит исключающие правила почти для всех системных каталогов CMS:

User-agent: * Disallow: /administrator/ Disallow: /bin/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /layouts/ Disallow: /libraries/ Disallow: /logs/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/

Можно заметить, что в коде нет исключающего правила для каталога /media. Учитывая, что содержание данного каталога практически не соответствует его названию (в основном он содержит системные файлы с серверным кодом для отдельных элементов Joomla), рекомендуем всё же добавлять для него исключение:

Учитывая, что содержание данного каталога практически не соответствует его названию (в основном он содержит системные файлы с серверным кодом для отдельных элементов Joomla), рекомендуем всё же добавлять для него исключение:

Disallow: /media/

Запрет индексирования системных дублей

Дубли страниц компонента контента Joomla 3 генерируются сами собой. Рассмотрим пример:

Категория uncategorised применяется для материалов Joomla, не определённых в категорию. Допустим, материал с алиасом about закреплен за пунктом меню с алиасом about. В результате материал

В результате материал about будет доступен по двум URL-адресам:

- /about,

- /uncategorised/about +id материала.

Не углубляясь в подробности процесса генерации дублей в Joomla, следует добавить в robots.txt инструкции, ограждающие поисковых роботов от них:

Disallow: /uncategorised/ # дубли материалов без категорий Disallow: /component/ # дубли и ненужные страницы различных компонентов Disallow: /*print= # версии для печати Disallow: /*index.php # дубли с index.php Disallow: /*=feed # фиды RSS и Atom Disallow: /*?tp=1 # дубли с отображением позиций для модулей

Запрет страниц пагинации

Следует отметить, что разбиения материалов на отдельные страницы лучше избегать: в индексе должна быть первая страница материала, но преградив доступ к страницам пагинации через robots.txt, <div class="seog-tooltip-more-link"><a href="/terminy/robot">Подробнее</a></div> »>роботы не станут их сканировать и учитывать при определении релевантности. Если всё же будет необходимость для исключения страниц пагинации от сканирования и индексирования, то можно воспользоваться следующими директивами:

Disallow: /*start= Disallow: /*showall=

Иногда имеет смысл исключать любые страницы с параметрами в URL-адресах, в том числе:

- страницы пагинации,

- фиды RSS и Atom,

- страницы для печати.

Делается это с помощью одной директивы:

Disallow: /*?

Если к каким-то страницам, содержащим параметры в URL, потребуется открыть доступ для роботов, то можно добавить исключение. Например:

Allow: /index.php?option=com_xmap&view=xml&tmpl=component&id=1 # для отдельной страницы Allow: /*=com_xmap # для всех страниц с параметром

Оптимизированный robots.

txt для Joomla 3

txt для Joomla 3

Обобщим все приведённые выше доводы и соберём их к одному виду. robots.txt со следующим списком директив подойдёт для большинства сайтов на CMS Joomla 3:

User-agent: * Disallow: /administrator/ Disallow: /bin/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /layouts/ Disallow: /libraries/ Disallow: /logs/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/ Disallow: /media/ Disallow: /uncategorised/ Disallow: /component/ Disallow: /*print= Disallow: /*index.php Disallow: /*=feed Disallow: /*?tp=1

Указанные правила robots.txt также актуальны для сайтов на Joomla 2.5.

Пример robots.txt для Joomshopping

Рассмотрим пример, как следует оптимизировать файл robots.txt для интернет-магазина, построенного на CMS Joomla с использованием компонента электронной коммерции JoomShopping.

Запрет индексирования страниц компонента

Интернет-магазины на «голом» (без сторонних расширений) JoomShopping, как правило, имеют:

- страницу виртуальной корзины URL-префикс по умолчанию: /cart/

- страницы оформления заказа URL-префикс по умолчанию: /checkout/

- страницы профиля клиента URL-префикс по умолчанию: /user/

- страницу поиска по сайту URL-префикс по умолчанию: /search/

Все эти страницы не нужны в индексной базе поисковых систем, поэтому их следует исключить через robots. txt.

txt.

URL-префиксы для данных страниц можно кастомизировать через алиасы, создавая пункты меню. Если этого не делать, то для их исключения достаточно добавить в robots.txt следующие строки:

Disallow: */cart/ Disallow: */checkout/ Disallow: */user/ Disallow: */search/

Следует отметить, что вариант с директивами без слеша в конце:

Disallow: */cart Disallow: */checkout Disallow: */user Disallow: */search

может запретить индексирование страниц, которые в этом не будут нуждаться. Например, могут появиться страницы

Например, могут появиться страницы /carts или /articles/user-catalog, которые будут попадать под правила запрета индексирования. Поэтому следует использовать более конкретные директивны.

Запрет индексирования дублей

Если при создании товаров и категорий JoomShopping не вводить алиас, то они будут иметь URL-префикс /product/view для товаров и /category/view для категорий. Даже если не забывать вводить алиас, все товары и категории всё равно будут иметь свои дубли с указанными префиксами. Для того, чтобы исключить попадание дублей данных страниц в индекс, необходимо добавить в robots.txt исключающие директивы для указанных URL-префиксов:

Disallow: */product/ Disallow: */category/

Индексирование изображений компонента

Компонент JoomShopping для хранения изображений использует не системный каталог /images, размещенный в корне сайта, а свои каталоги из папки /components/com_jshopping/files. Чтобы роботы индексировали изображения товаров и категорий, в robots.txt необходимо добавить разрешение для соответствующих каталогов:

Чтобы роботы индексировали изображения товаров и категорий, в robots.txt необходимо добавить разрешение для соответствующих каталогов:

Allow: /components/com_jshopping/files/img_products/ Allow: /components/com_jshopping/files/img_categories/

Оптимизированный robots.txt для JoomShopping

Добавив к правилам, созданным для компонента контента Joomla 3, директивы для компонента JoomShopping, получим следующий пример оптимизированного файла robots.txt, актуального для интернет-магазинов на Joomla:

User-agent: * Disallow: /administrator/ Disallow: /bin/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /layouts/ Disallow: /libraries/ Disallow: /logs/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/ Disallow: /media/ Disallow: /uncategorised/ Disallow: /component/ Disallow: /*print= Disallow: /*index.php Disallow: /*=feed Disallow: /*?tp=1 Disallow: */basket/ Disallow: */checkout/ Disallow: */user/ Disallow: */search/ Disallow: */product/ Disallow: */category/ Allow: /components/com_jshopping/files/img_products/ Allow: /components/com_jshopping/files/img_categories/

Пример robots.

txt для Joomla 2.5

txt для Joomla 2.5

Пакет Joomla 2.5.28 (последняя версия) содержит файл robots.txt в формате .dist. Необходимо удалить окончание .dist, чтобы файл имел формат .txt. Это сделано для того, чтобы файл не перезаписывался при обновлении CMS (это было актуально для Joomla 2.5).

Если не изменить формат файла, то сайт останется без robots.txt, т. е. поисковые роботы не получат инструкций по сканированию и индексированию файлов и каталогов сайта.

Файл robots.txt в Joomla 2.5 по умолчанию

После того, как файл robots.txt.dist преобразуется в robots.txt, можно открыть его в текстовом редакторе и увидеть следующее содержание:

User-agent: * Disallow: /administrator/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /images/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /libraries/ Disallow: /logs/ Disallow: /media/ Disallow: /modules/ Disallow: /plugins/ Disallow: /templates/ Disallow: /tmp/

Исключения для системных папок Joomla 2.

5

5

Базовый файл содержит исключающие инструкции для абсолютно всех системных каталогов сайта, в том числе папки с изображениями и файлами шаблонов. Следует ли говорить, что в большинстве случаев роботам необходим доступ к изображениям для их индексации, а также к .css и .js файлам для оценки веб-страниц.

Чтобы файл был не столь воспрещающим, достаточно удалить соответствующие запреты, а именно строки:

Disallow: /images/ # каталог с изображениями Joomla Disallow: /templates/ # каталог с файлами шаблонов

Настройка директив для Joomla 2.5

Рассматриваемый выше пример robots.txt для Joomla 3 актуален для сайтов на Joomla 2.5.

Для более тонкой настройки robots.txt необходимо внимательно изучить его синтаксис.

Настройка robots.txt для Joomla | Центр обучения Joomla

- Александр Куртеев

- Основы Joomla

Комментарии

- Для чего нужен robots.

txt?

txt? - Что представляет стандартный robots.txt в Joomla?

- Каким должен быть правильный robots.txt для Joomla?

Посмотрите видео по настройке и создайте идеальный файл robots.txt, открыв свой сайт на Joomla для поисковых роботов и пользователей из поисковой выдачи.

Для чего нужен robots.txt?

Одной из важных задач в SEO-оптимизации является открытие своего сайта для роботов поисковых систем.

Представьте: вы решили продать квартиру, но всеми силами не пускаете туда покупателей, а только позволяете посмотреть в замочную скважину. Что они там увидят? Как смогут оценить подходит им ваша квартира или нет?

Что они там увидят? Как смогут оценить подходит им ваша квартира или нет?

Поэтому в первую очередь для того, чтобы поисковые роботы видели наш сайт так же, как видят его пользователи нужно, обеспечить им доступ к сканированию с помощью файла robots.txt.

К сожалению, по умолчанию, если мы ничего не делаем с файлом robots.txt для сайта на Joomla, то мы разрешаем поисковым роботам именно подглядывать в щелку и, как следствие, получаем посредственный результат.

Работы на несколько минут, но многие терпят годами и ругаются на плохие результаты продвижения сайта на Joomla.

Что представляет стандартный robots.txt в Joomla?

Мало кто знает, что в стандартном файле robots.txt в Joomla до версии 3.3 поисковые роботы не видят изображений, не понимают оформления сайта и могут не видеть части контента, а иногда и вовсе не смогут переходить по сквозным ссылкам из меню.

Начиная с Joomla 3.3 разработчики изменили файл robots.txt и это похвально, но:

- при обновлении Джумла с предыдущей версии данный файл не перезаписывается автоматически,

- всё равно требуется его небольшая доработка.

Каким должен быть правильный robots.txt для Joomla?

Посмотрите видео по настройке и создайте идеальный файл robots.txt, открыв свой сайт для поисковых роботов и пользователей из поисковой выдачи:

Это была первая фишка в SEO-оптимизации Joomla. С помощью файла robots.txt также можно успешно удалять дубли страниц, которые не любят поисковые системы, но это отдельная тема, требующая погружения.

Упоминаемые термины:

Joomla

SEO

Как изменить файл robots.txt в Joomla

Все популярные поисковые системы в Интернете согласились использовать текстовый файл, предоставляемый каждым веб-сайтом, который указывает им, какую часть веб-сайта следует индексировать, а какую нет. Этот текстовый файл называется robots.txt.

В этом посте мы поговорим о файле robots. txt Joomla, в частности

txt Joomla, в частности

Что такое robots.txt

Файл robots.txt — это файл, который содержит набор правил для поисковых систем. Каждое правило содержит путь к папке и указывает, разрешено или запрещено индексирование этого пути.

Хотя вы должны знать, что не все поисковые системы уважают этот файл. Так что имейте в виду, что вы не должны использовать этот файл для сокрытия информации.

Что содержит файл robots.txt Joomla

Как видно из приведенного ниже кода, файл robots.txt Joomla содержит довольно большой набор папок, индексация которых запрещена поисковыми системами.

# Если сайт Joomla установлен в папке # например, www.example.com/joomla/, затем файл robots.txt # ДОЛЖЕН быть перемещен в корень сайта # например, www.example.com/robots.txt # И имя папки joomla ДОЛЖНО иметь префикс ко всем # пути. # например, правило Disallow для папки /administrator/ ДОЛЖНО # изменить на чтение # Запретить: /joomla/administrator/ # # Для получения дополнительной информации о стандарте robots.txt см.: # http://www.robotstxt.org/orig.html # # Для проверки синтаксиса см.: # http://tool.motoricerca.info/robots-checker.phtml Пользовательский агент: * Запретить: /администратор/ Запретить: /bin/ Запретить: /кеш/ Запретить: /cli/ Запретить: /компоненты/ Запретить: /включает/ Запретить: /установка/ Запретить: /язык/ Запретить: /макеты/ Запретить: /библиотеки/ Запретить: /журналы/ Запретить: /модули/ Запретить: /плагины/ Запретить: /tmp/

Строка User-agent: * в основном говорит о том, что приведенным ниже правилам должны следовать ВСЕ поисковые системы.

Набор запрещенных папок — это в основном папки, которые содержат код Joomla и не имеют ничего общего с вашим контентом. Поэтому они в любом случае не содержат ценной информации для поисковых систем. Вот почему разумно запретить любой доступ к ним и сохранить результаты поисковых систем для вашего веб-сайта, релевантные только вашему контенту.

Как изменить его из глобальной конфигурации Joomla

Глобальная конфигурация Joomla содержит способ быстрого изменения основных функций файла robots. txt. Давайте посмотрим, что доступно.

txt. Давайте посмотрим, что доступно.

Сначала вам нужно перейти к глобальной конфигурации Joomla, как показано на скриншоте ниже.

Как видите, это поле выбора содержит 4 параметра, которые в основном представляют собой все комбинированные параметры Индекс / Без индекса и Следовать / Не следовать.

Наиболее распространенным значением этого параметра является Index, Follow , который указывает поисковым системам сканировать весь веб-сайт и индексировать все.

Вопрос в том, что значит Index and Follow?

Индекс: Индексация означает, что поисковая система будет использовать любую часть вашего веб-сайта в результатах поиска.

Follow: Follow означает, что поисковая система будет использовать любую ссылку, предоставленную любой частью вашего веб-сайта, для дальнейшего перехода на ваш веб-сайт и, следовательно, для создания его древовидной структуры.

Как правило, вы бы использовали No Follow, если бы ваш веб-сайт имел только один уровень и вы не хотели бы, чтобы какая-либо поисковая система использовала какие-либо ссылки на этой странице, которые могут вести или не вести на совершенно другой веб-сайт.

Наконец, выбрав подходящий вариант, просто нажмите «Сохранить».

Что делать, если вы недавно обновились с Joomla 3.3

Joomla 3.3 и более ранние версии имели другой robots.txt, который использовал другой набор инструкций. После выпуска Joomla 3.4 эти инструкции были изменены, чтобы соответствовать последним изменениям в поисковых системах и структуре папок Joomla.

Проблема в том, что процесс автоматического обновления не изменяет файл robots.txt, поэтому вам следует вручную получить новую копию robots.txt из последней версии Joomla и использовать ее вместо этого.

Вот оно! Если вам нравятся наши руководства для начинающих Joomla, вы можете подписаться на нашу рассылку новостей и подписаться на нас в Twitter, чтобы получать уведомления о новых сообщениях первыми!

Об авторе

Редакция

Редакция JoomlaBeginner — это команда экспертов Joomla во главе с Тассосом Мариносом. Свяжитесь с нами, если вы хотите присоединиться к нашей команде. Подпишитесь на нас в Twitter или Facebook.

Подпишитесь на нас в Twitter или Facebook.

Читайте также

Включите JavaScript для просмотра комментариев, созданных с помощью Disqus.

Обновили ли вы файл Joomla Robots.txt

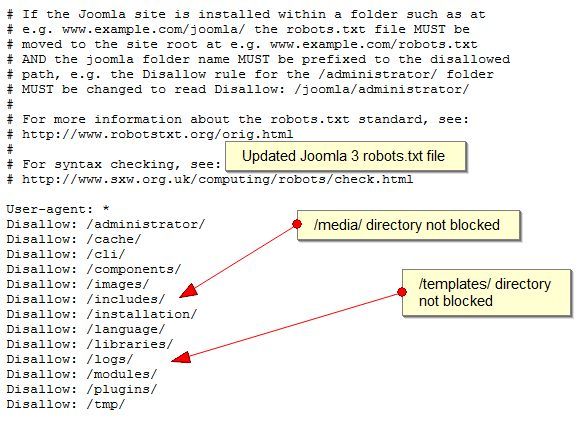

Версия файла robots.txt по умолчанию была обновлена начиная с Joomla 3.3, чтобы сделать его более удобным для поисковых систем, что позволяет Google получать доступ и сканировать /media/ и /templates/ каталоги.

Старая версия файла в основном не позволяла Google сканировать каталоги /media/ и /templates/ и препятствовала доступу Google к файлам CSS, Java и изображениям.

Обновления файла robotos.txt не применяются автоматически после обновления до последней версии Joomla 3.

Вам потребуется вручную внести изменения в файл , чтобы Google мог правильно сканировать и индексировать ваш веб-сайт.

Старая версия файла robots.txt

Как видно из приведенного ниже снимка экрана, старая версия файла robots. txt блокирует Google от сканирования /media/ и /templates/ каталоги.

txt блокирует Google от сканирования /media/ и /templates/ каталоги.

Новая версия файла Robots.txt

Как видно из новой обновленной версии снимка экрана с файлом robots.txt, Google разрешен доступ и сканирование каталогов /media/ и /Templates/.

Зачем обновлять файл Robots.txt

В июле 2015 года Google обновил руководство для веб-мастеров, чтобы сообщить владельцам веб-сайтов о том, что блокирование доступа робота Googlebot к файлам javascript и CSS может повлиять на рейтинг вашего веб-сайта в списке поисковых систем.

- Если Google не сможет получить доступ к каталогам /media/ и /templates/, он не сможет правильно отобразить веб-сайт.

- Устаревшая версия файла Robotos.txt будет создавать проблемы для вас через консоль поисковой системы Google и при тестировании вашего веб-сайта с помощью удобного для мобильных устройств инструмента тестирования Google.

Что такое файл robots.txt?

Файл robots.txt хранится в корневом или домашнем каталоге вашего веб-сайта Joomla и в основном сообщает поисковым роботам, какую часть вашего веб-сайта вы хотите, чтобы они сканировали, а какие части веб-сайта вы не хотите, чтобы они сканировали и индексировали.

Для получения более подробной информации прочитайте статьи, узнайте больше о файлах Robots.txt и стандартах исключения, которые можно применить к файлу.

Как обновить файл Joomla Robots.txt

- Откройте программу FTP, установленную на вашем компьютере.

- FTP в корневой или домашний каталог вашего веб-сайта.

- Загрузите файл robots.txt на свой компьютер. Если у вас нет файла robots.txt, у вас будет файл robots.txt.dist, который загрузит этот файл на ваш компьютер.

- Откройте файл .txt с помощью программы notepad.exe на своем компьютере. Если вы используете robots.txt.dist, просто удалите .dist из имени файла.

txt?

txt?

txt см.:

# http://www.robotstxt.org/orig.html

#

# Для проверки синтаксиса см.:

# http://tool.motoricerca.info/robots-checker.phtml

Пользовательский агент: *

Запретить: /администратор/

Запретить: /bin/

Запретить: /кеш/

Запретить: /cli/

Запретить: /компоненты/

Запретить: /включает/

Запретить: /установка/

Запретить: /язык/

Запретить: /макеты/

Запретить: /библиотеки/

Запретить: /журналы/

Запретить: /модули/

Запретить: /плагины/

Запретить: /tmp/

txt см.:

# http://www.robotstxt.org/orig.html

#

# Для проверки синтаксиса см.:

# http://tool.motoricerca.info/robots-checker.phtml

Пользовательский агент: *

Запретить: /администратор/

Запретить: /bin/

Запретить: /кеш/

Запретить: /cli/

Запретить: /компоненты/

Запретить: /включает/

Запретить: /установка/

Запретить: /язык/

Запретить: /макеты/

Запретить: /библиотеки/

Запретить: /журналы/

Запретить: /модули/

Запретить: /плагины/

Запретить: /tmp/